Page not found :(

+The page you are looking for doesn't exist or has been moved.

+The page you are looking for doesn't exist or has been moved.

+这里列出部分 Databend 设计和实现过程中参考和借鉴的论文,供感兴趣的朋友阅读。

+Databend 除了支持本机构建外,还可以使用 build tool 来进行跨平台构建。

+Databend 在 Makefile 中封装了大量常见命令。采用 make 构建只会开启默认特性,并且会一次性构建 databend-meta、databend-query 以及 databend-metactl 。

按 前文 设置好开发环境后。

+make build 即可轻松构建 debug 版本。make build-release 则会构建 release 版本,并会采用 objcopy 减少二进制体积。使用 cargo 构建的好处在于可以按需开启特性,并灵活控制要构建的目标二进制文件。

+常用的命令格式如:

+RUSTFLAGS="--cfg tokio_unstable" cargo build --bin=databend-query --features=tokio-console

+即可构建启用 tokio-console 支持的 databend-query ,使用 RUSTFLAGS="--cfg tokio_unstable" 是因为 tokio 的 tracing 特性还没有稳定下来。

Databend features 速览

+simd = ["common-arrow/simd"]:默认开启的特性,启用 arrow2 的 SIMD 支持(meta & query)。tokio-console = ["common-tracing/console", "common-base/tracing"]:用于 tokio 监控和调试,(meta & query)。memory-profiling = ["common-base/memory-profiling", "tempfile"]:用于内存分析,(meta & query)。storage-hdfs = ["opendal/services-hdfs", "common-io/storage-hdfs"]:用于提供 hdfs 支持,(query)。hive = ["common-hive-meta-store", "thrift", "storage-hdfs"]:用于提供 hive 支持,(query)。Databend 提供了 build-tool image,可以简化跨平台构建所需工作。

+示例选用 x86_64-unknown-linux-musl 目标平台,其他支持平台也类似:

IMAGE='datafuselabs/build-tool:x86_64-unknown-linux-musl' RUSTFLAGS='-C link-arg=-Wl,--compress-debug-sections=zlib-gabi' ./scripts/setup/run_build_tool.sh cargo build --target x86_6

+4-unknown-linux-musl

+在最近的一个 Issue 中 (#9387),Databend 社区的朋友希望能够通过 PGO 构建性能优化的二进制。让我们一起来看一下如何使用 Rust 构建 PGO 优化后的 Databend 吧!

+Profile-guided optimization 是一种编译器优化技术,它会收集程序运行过程中的典型执行数据(可能执行的分支),然后针对内联、条件分支、机器代码布局、寄存器分配等进行优化。

+引入这一技术的背景是:编译器中的静态分析技术能够在不执行代码的情况下考虑代码优化,从而提高编译产物的性能;但是这些优化并不一定能够完全有效,在缺乏运行时信息的情况下,编译器无法考虑到程序的实际执行。

+PGO 可以基于应用程序在生产环境中的场景收集数据,从而允许优化器针对较热的代码路径优化速度并针对较冷的代码路径优化大小,为应用程序生成更快和更小的代码。

+rustc 支持 PGO ,允许创建内置数据收集的二进制文件,然后在运行过程中收集数据,从而为最终的编译优化做准备。其实现完全依赖 LLVM 。

+构建 PGO 优化的二进制文件通常需要进行以下几步工作:

+.proraw 的形式存在.proraw 文件转换为 .prodata 文件.prodata 文件进行构建优化运行过程中的收集到的数据最终需要使用 llvm-profdata 进行转换,经由 rustup 安装 llvm-tools-preview 组件可以提供 llvm-profdata ,或者也可以考虑使用最近版本的 LLVM 和 Clang 提供的这一程序。

rustup component add llvm-tools-preview

+安装之后的 llvm-profdata 可能需要被添加到 PATH ,路径如下:

~/.rustup/toolchains/<toolchain>/lib/rustlib/<target-triple>/bin/

+这里并没有选用某个具体生产环境的工作负载,而是使用 Databend 的 SQL 逻辑测试作为一个示范。在性能上可能并不具有积极意义,但可以帮助我们了解如何进行这一过程。

+++特别提示: 提供给程序的数据样本必须在统计学上代表典型的使用场景; 否则,反馈有可能损害最终构建的整体性能。

+

清除旧数据

+rm -rf /tmp/pgo-data

+编译支持收集 profile 数据的 release ,使用 RUSTFLAGS 可以将 PGO 编译标志应用到所有 crates 的编译中。

RUSTFLAGS="-Cprofile-generate=/tmp/pgo-data" \

+cargo build --release --target=x86_64-unknown-linux-gnu

+运行编译好的程序,实际情况下推荐使用符合生产环境典型工作负载的数据集和查询。

+示例中选择执行 SQL 逻辑测试,仅供参考。

+BUILD_PROFILE=release ./scripts/ci/deploy/databend-query-standalone.sh

+ulimit -n 10000;ulimit -s 16384; cargo run -p sqllogictests --release -- --enable_sandbox --parallel 16 --no-fail-fast

+使用 llvm-profdata 合并 profile 数据

llvm-profdata merge -o /tmp/pgo-data/merged.profdata /tmp/pgo-data

+在 profile 数据指导下进行编译,其实可以注意到,两次编译都使用 --release 标志,因为实际运行情况下,我们总是使用 release 构建的二进制。

RUSTFLAGS="-Cprofile-use=/tmp/pgo-data/merged.profdata -Cllvm-args=-pgo-warn-missing-function" \

+cargo build --release --target=x86_64-unknown-linux-gnu

+再次运行编译好的程序,运行之前的工作负载以检查性能。

+BUILD_PROFILE=release ./scripts/ci/deploy/databend-query-standalone.sh

+ulimit -n 10000;ulimit -s 16384; cargo run -p sqllogictests --release -- --enable_sandbox --parallel 16 --no-fail-fast

+工欲善其事,必先利其器。在开启 Databend 贡献之旅前,一起来配置适合自己的开发环境吧。

+为方便开发者快速建立开发环境,Databend 维护了一个复杂的 shell 脚本,位于 scripts/setup/dev_setup.sh 。

只需执行一条指令即可完成开发环境配置:

+$ make setup -d

+++注意:此过程会辅助安装部分 python 环境,可能会对本地原开发环境造成影响,建议预先执行以下命令以创建并启用专属虚拟环境。

++$ python -m venv .databend +$ source .databend/bin/activate +

如果遇到依赖缺失问题,可以参考「分步安装 - 测试必备」这一部分的内容安装。

+这里以 Fedora 36 为例,考虑到不同系统和发行版之间的差异,你可能需要自行安装 gcc,python 和 openssl 。

推荐使用 rustup 来管理 Rust toolchain ,参考 https://rustup.rs/ 进行安装。

+对于 MacOS 和 Linux 用户,执行:

+$ curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh

+Databend 通常使用最新发布的 nightly 工具链进行开发,相关信息记录在 rust-toolchain.toml 中。

Rustup 会在使用时对工具链进行自动重载,安装时只需默认配置。

+$ cargo build

+info: syncing channel updates for 'nightly-2022-05-19-x86_64-unknown-linux-gnu'

+info: latest update on 2022-05-19, rust version 1.63.0-nightly (cd282d7f7 2022-05-18)

+以下列出了一些安装构建和测试必备依赖的关键步骤,说明及报错信息以注释形式呈现。

+构建必备

+# common-hive-meta-store 需要,thrift not found

+$ sudo dnf install thrift

+# openssl-sys 需要,Can't locate FindBin.pm, File/Compare.pm in @INC

+$ sudo dnf install perl-FindBin perl-File-Compare

+# prost-build 需要,is `cmake` not installed?

+# The CMAKE_CXX_COMPILER: c++ is not a full path and was not found in the PATH.,安装 clang 时也会安装 gcc-c++ 和 llvm

+$ sudo dnf install cmake clang

+测试必备

+# 功能测试和后续体验需要

+$ sudo dnf install mysql

+# 包含目前功能测试和 lint 需要的所有 Python 依赖

+$ cd tests

+$ pip install poetry

+$ poetry install

+$ poetry shell

+# sqllogic 测试需要(包含在上面步骤中,按需选用)

+(tests) $ cd logictest

+$ pip install -r requirements.txt

+# fuzz 测试需要

+(tests) $ cd fuzz

+$ pip install -r requirements.txt

+Lint 必备

+# taplo fmt 需要

+$ cargo install taplo-cli

+

rust-analyzer

+crates

+CodeLLDB

+Remote - Containers

+安装「Remote - Containers」插件,打开 Databend 后会看到右下角弹出窗口并提示「Reopen in Container」。

+安装 Docker

+根据 Docker Docs - Install 安装并启动对应你发行版的 docker 。

+以 Fedora 36 为例,步骤如下:

# 移除旧版本 docker

+$ sudo dnf remove docker \

+ docker-client \

+ docker-client-latest \

+ docker-common \

+ docker-latest \

+ docker-latest-logrotate \

+ docker-logrotate \

+ docker-selinux \

+ docker-engine-selinux \

+ docker-engine

+# 设置存储库

+$ sudo dnf -y install dnf-plugins-core

+$ sudo dnf config-manager \

+ --add-repo \

+ https://download.docker.com/linux/fedora/docker-ce.repo

+# 安装 Docker Engine

+$ sudo dnf install docker-ce docker-ce-cli containerd.io docker-compose-plugin

+将当前 User 添加到 'docker' group 中

+参考 Docker Docs - PostInstall 中 Manage Docker as a non-root user 一节配置,可能需要重启。

+步骤如下:

+# 添加 docker 用户组

+$ sudo groupadd docker

+# 将用户添加到 docker 这个组中

+$ sudo usermod -aG docker $USER

+# 激活更改

+$ newgrp docker

+# 更改权限以修复 permission denied

+$ sudo chown "$USER":"$USER" /home/"$USER"/.docker -R

+$ sudo chmod g+rwx "$HOME/.docker" -R

+其他步骤

+启用 Docker :

+$ sudo systemctl start docker

+点击左下角「打开远程窗口」选中「Reopen in Container」即可体验。

+这里列出一些可能有助于 Databend 开发的实用工具,根据实际情况按需选用。

+轻量级、反应迅速、可无限定制的高颜值终端!

+ +

参考 starship - installation 进行安装。

+curl -sS https://starship.rs/install.sh | sh

+命令行基准测试工具。

+ +参考 hyperfine - installation 进行安装。

+cargo install hyperfine

+开发和调试 Databend 时,难免会遇到一些小问题,这里列出一些解决方案供大家参考。

+下面是 16g 内存的一台设备编译 Databend 时的 Swap 情况。

+$> swapon -s

+Filename Type Size Used Priority

+/dev/nvme0n1p3 partition 134217724 32632196 50

+/dev/zram0 partition 8388604 8388264 100

+通常情况下,OOM 会在链接阶段发生。一些可能有效的解决方案包括:

+可以参考下面内容:

+用于判断兼容性的代码会检查当前的 tag,可能是 fork 的 tags 落后于 datafuselabs/databend 。

+$> git fetch git@github.com:datafuselabs/databend.git --tags

+protoc 现在可以随源码一起构建,考虑到发行版中的 protoc 版本不好统一,建议删除并重新构建项目源码。

提示需要 lzma,安装 xz 或者 lzip 可以解决。

Undefined symbols for architecture x86_64:

+ "_lzma_auto_decoder", referenced from:

+ xz2::stream::Stream::new_auto_decoder::hc1bac2a8128d00b2 in databend_query-6ac85c55ade712f3.xz2

+ld: symbol(s) not found for architecture x86_64

+clang: error: linker command failed with exit code 1 (use -v to see invocation)

+Databend 的设计目标之一就是保持最佳性能,为了更好观测和评估性能,社区不光提供一套简单的本地基准测试方案,还建立了可视化的持续基准测试。

+hyperfine 是一种跨平台的命令行基准测试工具,支持预热和参数化基准测试。

+Databend 建议使用 hyperfine 通过 ClickHouse / MySQL 客户端执行基准测试,本文将使用 MySQL 客户端来介绍它。

+进行本地基准测试之前,必须完成以下几项准备工作:

+根据你的数据集特征和关键查询设计 SQL 语句,如果需要预先加载数据,请参考 Docs - Load Data 。

+为方便示范,这里选用 Continuous Benchmarking - Vectorized Execution Benchmarking 列出的 10 条语句,保存到 bench.sql 中。

SELECT avg(number) FROM numbers_mt(100000000000)

+SELECT sum(number) FROM numbers_mt(100000000000)

+SELECT min(number) FROM numbers_mt(100000000000)

+SELECT max(number) FROM numbers_mt(100000000000)

+SELECT count(number) FROM numbers_mt(100000000000)

+SELECT sum(number+number+number) FROM numbers_mt(100000000000)

+SELECT sum(number) / count(number) FROM numbers_mt(100000000000)

+SELECT sum(number) / count(number), max(number), min(number) FROM numbers_mt(100000000000)

+SELECT number FROM numbers_mt(10000000000) ORDER BY number DESC LIMIT 10

+SELECT max(number), sum(number) FROM numbers_mt(1000000000) GROUP BY number % 3, number % 4, number % 5 LIMIT 10

+下面给出一个 benchmark.sh 范本,可以简化整个基准测试流程:

#!/bin/bash

+

+WARMUP=3

+RUN=10

+

+export script="hyperfine -w $WARMUP -r $RUN"

+

+script=""

+function run() {

+ port=$1

+ sql=$2

+ result=$3

+ script="hyperfine -w $WARMUP -r $RUN"

+ while read SQL; do

+ n="-n \"$SQL\" "

+ s="echo \"$SQL\" | mysql -h127.0.0.1 -P$port -uroot -s"

+ script="$script '$n' '$s'"

+ done <<< $(cat $sql)

+

+ script="$script --export-markdown $result"

+ echo $script | bash -x

+}

+

+

+run "$1" "$2" "$3"

+在这个脚本中:

+-w/--warmup & WARMUP 在实际基准测试之前运行 3 次程序执行来预热。-r/--runs & RUN 要求执行 10 次基准测试。在使用前需要先运行 chmod a+x ./benchmark.sh 赋予其可执行权限。

用法如下所示:

+./benchmark.sh <port> <sql> <result>

+在这个例子中,MySQL 兼容服务的端口是 3307 ,基准测试用到的 SQL 文件为 bench.sql , 预期的输出在 databend-hyperfine.md 。

./benchmark.sh 3307 bench.sql databend-hyperfine.md

+当然,你可以根据自己的配置和需要进行调整。

+++注意:下面的示例是在 AMD Ryzen 9 5900HS & 16GB RAM 配置下运行产生,仅供参考。

+

终端中的输出如下所示:

+Benchmark 1: "SELECT avg(number) FROM numbers_mt(100000000000)"

+ Time (mean ± σ): 3.486 s ± 0.016 s [User: 0.003 s, System: 0.002 s]

+ Range (min … max): 3.459 s … 3.506 s 10 runs

+最终的结果会保存在 databend-hyperfine.md 中,如下所示。

| Command | Mean [s] | Min [s] | Max [s] | Relative |

|---|---|---|---|---|

"SELECT avg(number) FROM numbers_mt(100000000000)" | 3.690 ± 0.193 | 3.425 | 4.086 | 2.58 ± 0.16 |

"SELECT sum(number) FROM numbers_mt(100000000000)" | 3.660 ± 0.156 | 3.386 | 3.911 | 2.56 ± 0.13 |

"SELECT min(number) FROM numbers_mt(100000000000)" | 9.581 ± 0.158 | 9.246 | 9.884 | 6.69 ± 0.23 |

"SELECT max(number) FROM numbers_mt(100000000000)" | 6.388 ± 0.142 | 6.203 | 6.624 | 4.46 ± 0.17 |

"SELECT count(number) FROM numbers_mt(100000000000)" | 2.647 ± 0.108 | 2.424 | 2.757 | 1.85 ± 0.09 |

"SELECT sum(number+number+number) FROM numbers_mt(100000000000)" | 19.408 ± 1.125 | 17.857 | 21.616 | 13.55 ± 0.89 |

"SELECT sum(number) / count(number) FROM numbers_mt(100000000000)" | 3.869 ± 0.133 | 3.600 | 4.073 | 2.70 ± 0.12 |

"SELECT sum(number) / count(number), max(number), min(number) FROM numbers_mt(100000000000)" | 15.488 ± 0.263 | 15.133 | 16.064 | 10.81 ± 0.38 |

"SELECT number FROM numbers_mt(10000000000) ORDER BY number DESC LIMIT 10" | 2.971 ± 0.085 | 2.871 | 3.186 | 2.07 ± 0.09 |

"SELECT max(number), sum(number) FROM numbers_mt(1000000000) GROUP BY number % 3, number % 4, number % 5 LIMIT 10" | 1.432 ± 0.044 | 1.399 | 1.545 | 1.00 |

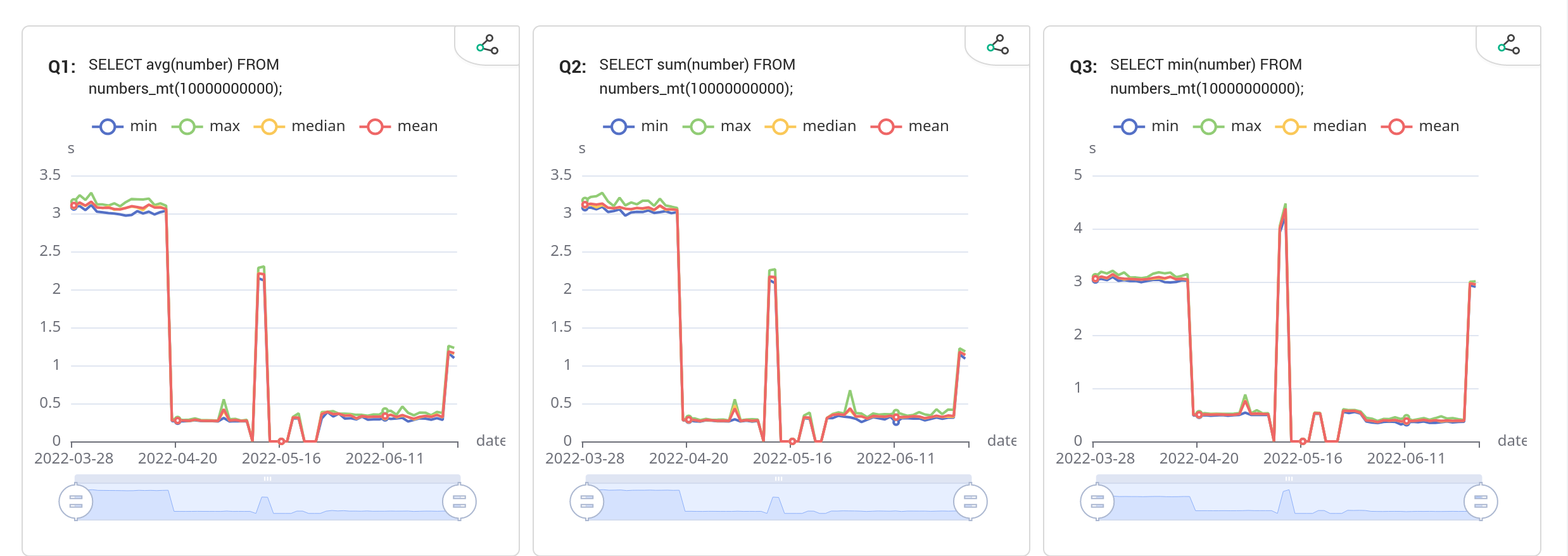

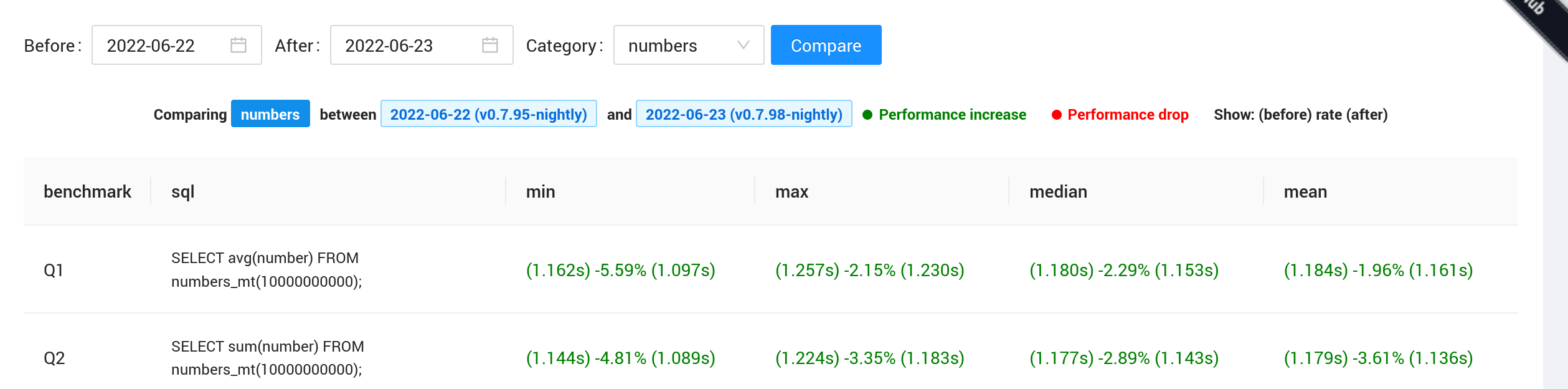

Databend 的持续基准测试由 GitHub Action + Vercel + DatabendCloud 强力驱动,在 datafuselabs/databend-perf 这个 repo 中开源了源代码和 Workflow 。

+项目布局

+.

+├── .github/workflows # 持续集成工作流

+├── benchmarks # YAML 格式的 SQL Query 测试套件

+├── collector # 分类存放性能数据

+├── front # 可视化前端

+├── reload # YAML 格式的 Data Load 测试套件

+└── script # 数据预处理脚本

+Workflow

+持续基准测试工作流定时计划执行,Perf Workflow 会在每天 00:25 UTC(北京时间 08:25)执行,Reload Workflow 会在每周五 08:25 UTC(北京时间 16:25)执行。

+databend-perf 中的测试套件分为 Query Benchmark 和 Load Benchmark 两类,前者放在 benchmarks 目录下,后者放在 reload 目录下。

+测试用 YAML 格式定义:

+metadata:

+ table: numbers

+

+statements:

+ - name: Q1

+ query: "SELECT avg(number) FROM numbers_mt(10000000000);"

+metadata 中的 table 字段是必须的,且分配给每类 benchmark 的值都唯一。statements 则只需要指定 name 和 query 。

向量化执行基准测试

+定义在 benchmarks/numbers.yaml ,一组数值计算 SQL,利用 Databend 的 numbers 表函数提供百亿级别的数据量。

+完整语句也可以在 Continuous Benchmarking - Vectorized Execution Benchmarking 查看。

+Ontime 常见分析场景基准测试

+定义在 benchmarks/ontime.yaml ,一组常见的空中交通分析 SQL ,基于美国交通部公开的 OnTime 数据集,共计 202,687,654 条记录。

+当前此基准测试不包含 JOIN 语句,Q5、Q6、Q7 均采用优化后的形式。

+完整语句也可以在 Continuous Benchmarking - Ontime Benchmarking 查看。

+Ontime 数据集载入基准测试

+定义在 reload/ontime.yaml ,同样基于美国交通部公开的 OnTime 数据集,通过 s3 进行 COPY INTO 。

+关键语句:

+COPY INTO ontime FROM 's3://<bucket>/m_ontime/'

+credentials=(aws_key_id='AWS_KEY_ID' aws_secret_key='AWS_SECRET_KEY')

+pattern ='.*[.]csv' file_format=(type='CSV' field_delimiter='\t' record_delimiter='\n' skip_header=1);

+上面 SQL 语句中的 m_ontime/ 目录即为数据集:由原来 60.8 GB 数据全部合并后,再拆分成 100 个大小相近的文件。

基准测试得到的数据是 Json 格式的,会分类存放到 collector 这个目录下。

+metadata 部分是包含表、版本、机器规格的信息;schema 部分则是对每条语句执行情况的统计,包括中位数、平均数等。

示例:

+{

+ "metadata":{

+ "table":"numbers",

+ "tag":"v0.7.92-nightly",

+ "size":"Large"

+ },

+ "schema":[

+ {

+ "name":"Q1",

+ "sql":"SELECT avg(number) FROM numbers_mt(10000000000);",

+ "min":0.305,

+ "max":0.388,

+ "median":0.354,

+ "std_dev":0.02701407040784487,

+ "read_row":10000000000,

+ "read_byte":80000000000,

+ "time":[

+ 0.315,

+ 0.326,

+ ...

+ ],

+ "error":[

+

+ ],

+ "mean":0.34774024905853534

+ },

+ ...

+ ]

+}

+经由 stript/transform.go 处理,为每个查询的对应图表聚合数据,主要强调最大、最小、均值、中位数四个指标。

示例:

+{

+ "title":"Q1",

+ "sql":"SELECT avg(number) FROM numbers_mt(10000000000);",

+ "lines":[

+ {

+ "name":"min",

+ "data":[

+ 3.084,

+ 3.097,

+ 3.043,

+ ...

+ ],

+ ...

+ }

+ ],

+ "version":[

+ "v0.7.0-nightly",

+ "v0.7.1-nightly",

+ "v0.7.2-nightly",

+ ...

+ ],

+ "legend":[

+ "min",

+ ...

+ ],

+ "xAxis":[

+ "2022-03-28",

+ "2022-03-29",

+ "2022-03-30",

+ ...

+ ],

+}

+目前可视化方案采用 React + Echarts 实现,每个图表都对应上面处理得到的一个 Json 文件。在添加新的基准测试后,无需修改前端即可展现新的图表。

+Graphs

+

Compare

+

Status

+

目前 https://perf.databend.rs 为 Databend 提供了基本的持续性能监控方案,但仍然需要关注以下几个方向的内容:

+Databend 是一个开源的云数仓项目,这意味着你可以轻松参与“设计->研发->使用->反馈”的整个链路。这篇文章总结了参与 Databend 开源协作时需要注意的一些事项,以使贡献流程更加清晰和透明。+

在这篇文章中,主要从“沟通”和“实施”两个方面介绍 Databend 的开源协作。

+沟通是参与开源的重要环节,正是得益于开源世界中沟通的公开与透明,才能迸发出如此生机与活力。

+参与 Databend 开源协作的主要沟通方式有 Issues 、RFCs 以及 Channels 三种。

+Issues 通常用于 Bug 反馈和新特性请求,Databend 使用 GitHub Issues 来跟踪和管理这些反馈。

+https://github.com/datafuselabs/databend/issues/new/choose

+Bug 反馈

+Databend 提供了一个基本的 Bug 反馈模板以确保沟通的顺畅进行。

+在进行 Bug 反馈之前,请检索是否存在已知的解决方案,并确定你正在运行的版本,最好包含 commit id 。

当然,提供清晰的问题描述和可复现步骤也是非常重要的环节。

+好例子:https://github.com/datafuselabs/databend/issues/6564

+++Databend 的迭代速度非常快,每天都会发布新的 nightly 供用户尝鲜,建议尝试新版本以确定能否复现。

+

新特性请求

+对于新特性请求,请尽可能提供详细的描述或是预期的行为,如果有可以参考的文档就更好了。

+好例子:https://github.com/datafuselabs/databend/issues/5979

+对于小的功能点,打开 Issues 进行沟通就足够了。而大的功能、设计上的变动或者是需要充分讨论和同步的想法,请以 RFC 的形式提交。

+在设计和沟通的早期阶段,推荐使用 Discusssions 进行讨论。

+一旦确认实施和落地,提交 RFC 文档并建立用于跟踪的 Issues 则是更为合适的做法。

+好例子:https://github.com/datafuselabs/databend/discussions/5438

+Channels 通常用于一般的交流和讨论,Databend 团队鼓励使用 GitHub Discusssions 进行一般问题的咨询和讨论,形成一个“知识库”,方便检索和参与。

+当然,Databend 也提供 Slack 频道和微信群用于日常交流与讨论。

+Slack:https://link.databend.rs/join-slack

+进入到实施环节,你将亲自动手改进 Databend 的代码或者文档,并踏上成为 Databend 维护者的道路,接下来让我们一起看一下有哪些环节需要重视。

+前置环境

+在「Databend 贡献之路 | 如何设置 Databend 开发环境」一文中,已经详细介绍过如何配置 Databend 开发环境。

+需要注意的是,考虑到不同系统和发行版之间的差异,你可能需要自行安装 gcc,python 和 openssl 等相关基础程序。

代码文档

+任何公共字段、函数和方法都应该用 Rustdoc 进行文档化。

+必要的时候,请使用 Diagon 或其他 ASCII 图像生成器生成示意图以对设计进行充分描述。

+下面给出一个简单的例子:

+/// Represents (x, y) of a 2-dimensional grid

+///

+/// A line is defined by 2 instances.

+/// A plane is defined by 3 instances.

+#[repr(C)]

+struct Point {

+ x: i32,

+ y: i32,

+}

+前置环境

+本机上需要安装有用于 node 环境管理的 nvm ,以及用于 node 依赖管理的 yarn 。

文档的开发环节需要进入 website 目录后根据 README.md 中的描述进行配置。

通常情况下,包含以下步骤:

+node 版本:nvm useyarn installyarn start重要提示

+文档应当正确放置在 docs 目录下,请本地预览确认无误后再进行提交。

最终文档会托管到 https://databend.rs 。

+License 检查

+如果引入了新文件,建议执行 License 以确认是否添加了合适的许可信息。对于非代码文件,可能需要编辑 .licenserc.yaml 以跳过检查。

make check-license

+代码风格

+请运行下述命令以完成代码风格的统一:

+make lint

+依赖审计

+如果你引入了一些新的依赖项,可以使用:

+cargo udeps --workspace

+cargo audit

+测试

+在「Databend 贡献之路 | 如何为 Databend 添加新的测试」中,已经对测试做了详细的描述。

+通常情况下,使用 make test 一次性执行 单元测试 和 功能测试 就可以。

但是,也建议执行 集群 相关的测试,以确保分布式执行不会出现差错。

一般流程

+make lint 。@mergify 的回复,它会提供一些指导。PR 标题填写

+PR 标题需要符合 <类型>(<范围>): <描述> 的约束。

fix(query): fix group by string bug

+^--^ ^------------^

+| |

+| +-> Summary in present tense.

+|

++-------> Type: feat, fix, refactor, ci, build, docs, website, chore

+PR 模板填写

+Databend 提供了一个基本的 PR 模板,请不要修改模板上下文,并填充对本次 PR 的总结信息,包括是否修复/修复了哪个已知的 Issue 。

+I hereby agree to the terms of the CLA available at: https://databend.rs/dev/policies/cla/

+

+## Summary

+

+Summary about this PR

+

+Fixes #issue

+好例子:https://github.com/datafuselabs/databend/pull/6665

+持续集成相关的文件位于 .github 目录中的 actions 和 workflows 目录下。

文档

+文档相关的持续集成会通过 Vercel 进行,需要关注 Status ,并点击 Visit Preview 查看渲染情况。

检查

+包括 License 检查、代码风格检查、依赖关系审计等内容。

+构建

+主要是测试跨平台构建,主要是针对 x86_64 和 aarch64 架构,对 Linux 的 GNU 和 MUSL 支持处于第一优先级别。MacOS 虽然标记为 optional ,但是需要尽量保证。

+测试

+主要是执行各种测试确保代码和功能都符合要求,包括单元测试、功能测试、分布式测试、模糊测试等:

+有两位或两位以上维护者投下赞同票,并满足下述条件,Mergify 将会帮助我们完成代码合并工作:

+在合并之后,你的 git name 将收集在 Databend 的 system.contributors 表中,在新版本 release 之后,执行 SELECT * FROM system.contributors 即可查看。

Databend 整合了一些性能剖析工具,可以方便进行深入分析。本文将会介绍如何进行 CPU / Memory Profiling 。

+CPU 分析,按照一定的频率采集所监听的应用程序 CPU(含寄存器)的使用情况,可确定应用程序在主动消耗 CPU 周期时花费时间的位置。

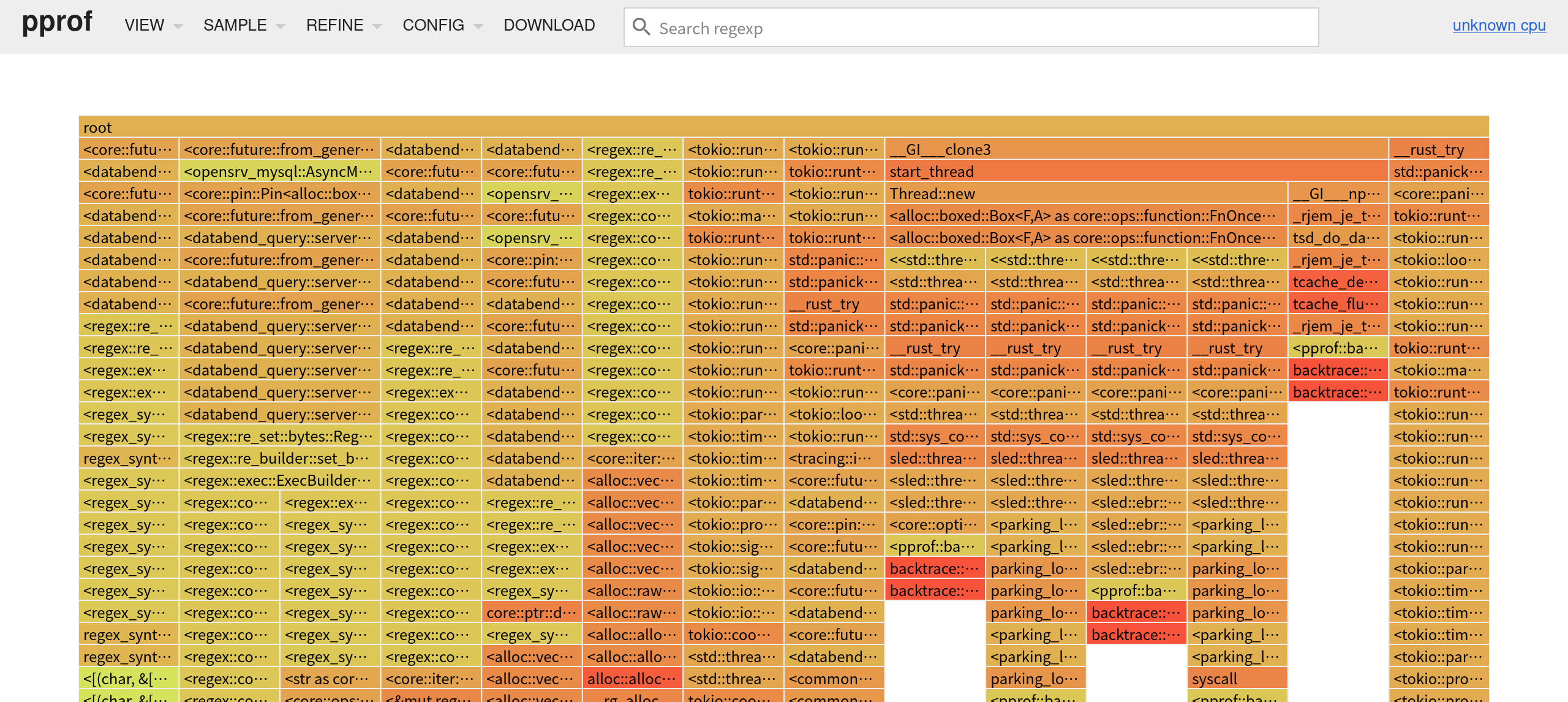

+pprof 是 Google 开源的代码性能分析工具,可以直接生成代码分析报告,不仅支持通过命令式交互查看,也便于可视化展示。Databend 使用 pprof-rs 完成对 pprof 工具的支持。

+go tool pprof http://localhost:<your-databend-port>/debug/pprof/profile?seconds=<your-profile-second>

+若 http 端口为 8080 ,采样时间为 20 秒,结果示例如下:

+$ go tool pprof http://localhost:8080/debug/pprof/profile?seconds=20

+Fetching profile over HTTP from http://localhost:8080/debug/pprof/profile?seconds=20

+Saved profile in ~/pprof/pprof.samples.cpu.001.pb.gz

+Type: cpu

+Time: Jul 15, 2022 at 9:45am (CST)

+Duration: 20s, Total samples = 141.41ms ( 0.71%)

+Entering interactive mode (type "help" for commands, "o" for options)

+(pprof) top

+Showing nodes accounting for 141.41ms, 100% of 141.41ms total

+Showing top 10 nodes out of 218

+ flat flat% sum% cum cum%

+ 141.41ms 100% 100% 141.41ms 100% backtrace::backtrace::libunwind::trace

+ 0 0% 100% 10.10ms 7.14% <&mut regex_syntax::utf8::Utf8Sequences as core::iter::traits::iterator::Iterator>::next

+ 0 0% 100% 10.10ms 7.14% <<std::thread::Builder>::spawn_unchecked_<sled::threadpool::queue::spawn_to<sled::pagecache::iterator::scan_segment_headers_and_tail::{closure#0}::{closure#0}, core::option::Option<(u64, sled::pagecache::logger::SegmentHeader)>>::{closure#0}::{closure#0}, ()>::{closure#1} as core::ops::function::FnOnce<()>>::call_once::{shim:vtable#0}

+ 0 0% 100% 10.10ms 7.14% <<std::thread::Builder>::spawn_unchecked_<sled::threadpool::queue::spawn_to<sled::pagecache::iterator::scan_segment_headers_and_tail::{closure#0}::{closure#0}, core::option::Option<(u64, sled::pagecache::logger::SegmentHeader)>>::{closure#0}::{closure#1}, ()>::{closure#1} as core::ops::function::FnOnce<()>>::call_once::{shim:vtable#0}

+ 0 0% 100% 10.10ms 7.14% <<std::thread::Builder>::spawn_unchecked_<sled::threadpool::queue::spawn_to<sled::pagecache::iterator::scan_segment_headers_and_tail::{closure#0}::{closure#0}, core::option::Option<(u64, sled::pagecache::logger::SegmentHeader)>>::{closure#0}::{closure#2}, ()>::{closure#1} as core::ops::function::FnOnce<()>>::call_once::{shim:vtable#0}

+ 0 0% 100% 10.10ms 7.14% <<std::thread::Builder>::spawn_unchecked_<sled::threadpool::queue::spawn_to<sled::pagecache::iterator::scan_segment_headers_and_tail::{closure#0}::{closure#0}, core::option::Option<(u64, sled::pagecache::logger::SegmentHeader)>>::{closure#0}::{closure#3}, ()>::{closure#1} as core::ops::function::FnOnce<()>>::call_once::{shim:vtable#0}

+ 0 0% 100% 10.10ms 7.14% <[&str]>::iter

+ 0 0% 100% 10.10ms 7.14% <[(char, &[char])]>::binary_search_by::<<[(char, &[char])]>::binary_search_by_key<char, regex_syntax::unicode::simple_fold::imp::{closure#0}>::{closure#0}>

+ 0 0% 100% 10.10ms 7.14% <[(char, &[char])]>::binary_search_by_key::<char, regex_syntax::unicode::simple_fold::imp::{closure#0}>

+ 0 0% 100% 10.10ms 7.14% <[(char, &[char])]>::binary_search_by_key::<char, regex_syntax::unicode::simple_fold::imp::{closure#0}>::{closure#0}

+执行下述命令可以进行可视化:

+go tool pprof -http=0.0.0.0:<your-profile-port> <your profile data>

+例如,执行下述语句可以在 8088 端口开启 WEB UI 。

+go tool pprof -http=0.0.0.0:8088 ~/pprof/pprof.samples.cpu.001.pb.gz

+访问 http://0.0.0.0:8088/ui/flamegraph 即可得到火焰图。

Databend 暂时不支持在 musl 平台上运行 pprof 。

+内存分析,在应用程序进行堆分配时记录堆栈追踪,用于监视当前和历史内存使用情况,以及检查内存泄漏。

+通过与 jemalloc 的集成,Databend 得以整合多种内存分析能力。这里使用 jeprof 进行内存分析。

安装 Jemalloc,并启用其剖析能力 ./configure --enable-prof

在构建二进制文件时启用 memory-profiling 特性:cargo build --features memory-profiling

在创建 Databend 实例时,设置环境变量 MALLOC_CONF=prof:true 以启用内存分析。示例:

MALLOC_CONF=prof:true ./target/debug/databend-query

+jeprof <your-profile-target> http://localhost:<your-databend-port>/debug/mem

+下面的例子选用 debug 模式下编译的 databend-query 作为 target,端口为 8080,结果如下所示:

+$ jeprof ./target/debug/databend-query http://localhost:8080/debug/mem

+Using local file ./target/debug/databend-query.

+Gathering CPU profile from http://localhost:8080/debug/mem/pprof/profile?seconds=30 for 30 seconds to

+ ~/jeprof/databend-query.1658367127.localhost

+Be patient...

+Wrote profile to ~/jeprof/databend-query.1658367127.localhost

+Welcome to jeprof! For help, type 'help'.

+(jeprof) top

+Total: 11.1 MB

+ 6.0 54.6% 54.6% 6.0 54.6% ::alloc_zeroed

+ 5.0 45.4% 100.0% 5.0 45.4% ::alloc

+ 0.0 0.0% 100.0% 0.5 4.5% ::add_node::{closure#0}

+ 0.0 0.0% 100.0% 5.0 45.4% ::alloc_impl

+ 0.0 0.0% 100.0% 5.0 45.4% ::allocate

+ 0.0 0.0% 100.0% 4.5 40.8% ::allocate_in

+ 0.0 0.0% 100.0% 0.5 4.5% ::apply_batch_inner

+ 0.0 0.0% 100.0% 11.1 100.0% ::block_on::

+ 0.0 0.0% 100.0% 11.1 100.0% ::block_on::::{closure#0}

+ 0.0 0.0% 100.0% 0.5 4.5% ::clone

+(jeprof)

+常见的用例之一是查找内存泄漏,通过比较间隔前后的内存画像即可完成这一工作。

+在下面的命令行中,以 10s 为间隔,获取前后两个时间节点的内存画像。

+curl 'http://localhost:<your-databend-port>/debug/mem/pprof/profile?seconds=0' > a.prof

+sleep 10

+curl 'http://localhost:<your-databend-port>/debug/mem/pprof/profile?seconds=0' > b.prof

+接着,可以利用这两份内存画像来生成 pdf 格式的内存分配调用图。

jeprof \

+ --show_bytes \

+ --nodecount=1024 \

+ --nodefraction=0.001 \

+ --edgefraction=0.001 \

+ --maxdegree=64 \

+ --pdf \

+ <your-profile-target> \

+ --base=a.prof \

+ b.prof \

+ > mem.pdf

+同样选用 debug 模式下编译的 databend-query 作为 target,端口为 8080,结果如图所示:

+

目前无法在 Mac 上进行内存分析,不管是 x86_64 还是 aarch64 平台。

+ + + + + + + + +如果你对自定义类型系统或者数据库项目的研发感兴趣,可以看看 Databend 是如何做的。

+现在 Databend 正在尝试将一些旧的函数迁移到全新表达式框架中,你愿意来试试看吗?

+近期,Databend 围绕全新表达式框架的设计与实现开展了许多工作,将会带来一些有意思的特性。

+旧的函数位于 query/functions/src/scalars ,它们需要被迁移到 query/functions-v2/src/scalars/ 。

通常情况下,旧函数实现中的核心逻辑是可以复用的,只需要进行少量重写使其符合新的实现方案。

+类似地,旧的测试位于 query/functions/tests/it/scalars/ ,也应该迁移到 query/functions-v2/tests/it/scalars/ 。

新测试将会使用 goldenfile 进行编写,所以可以轻松生成测试用例而无需大量繁重的手写工作。

LENGTH 将会按字节数返回字符串的长度。

仅仅使用 6 行,就可以在 query/functions-v2/src/scalars/strings.rs 中实现 LENGTH 函数。

registry.register_1_arg::<StringType, NumberType<u64>, _, _>(

+ "length",

+ FunctionProperty::default(),

+ |_| None,

+ |val| val.len() as u64,

+);

+由于 OCTET_LENGTH 是 LENGTH 的同义函数,只需为其添加一个函数别名即可,仅用一行。

registry.register_aliases("length", &["octet_length"]);

+接下来,需要写一些测试,来确保函数实现的正确性。编辑 query/functions-v2/tests/it/scalars/string.rs。

fn test_octet_length(file: &mut impl Write) {

+ run_ast(file, "octet_length('latin')", &[]);

+ run_ast(file, "octet_length(NULL)", &[]);

+ run_ast(file, "length(a)", &[(

+ "a",

+ DataType::String,

+ build_string_column(&["latin", "кириллица", "кириллица and latin"]),

+ )]);

+}

+将其注册到 test_string 函数中:

#[test]

+fn test_string() {

+ let mut mint = Mint::new("tests/it/scalars/testdata");

+ let file = &mut mint.new_goldenfile("string.txt").unwrap();

+

+ ...

+ test_octet_length(file);

+ ...

+}

+通过命令行,可以直接生成完整的测试用例,并附加到对应的 goldenflie 中:

REGENERATE_GOLDENFILES=1 cargo test -p query-functions-v2 --test it

+请使用 git diff 检查一下生成的测试是否符合预期,如果一切顺利,LENGTH 函数的迁移工作就完成了。

function 中暴露了多套注册方法, 根据函数接受的参数个数不同, 分为: register_0_arg, register_1_arg ..

另外, 根据不同的功能需求, 我们提供了不同Level的注册API

+| Auto Vectorization | Access Output Column Builder | Auto Null Passthrough | Auto Combine Null | Auto Downcast | Throw Runtime Error | Varidic | Tuple | |

|---|---|---|---|---|---|---|---|---|

| register_n_arg | ✔️ | ❌ | ✔️ | ❌ | ✔️ | ❌ | ❌ | ❌ |

| register_passthrough_nullable_n_arg | ❌ | ✔️ | ✔️ | ❌ | ✔️ | ✔️ | ❌ | ❌ |

| register_combine_nullable_n_arg | ❌ | ✔️ | ✔️ | ✔️ | ✔️ | ✔️ | ❌ | ❌ |

| register_n_arg_core | ❌ | ✔️ | ❌ | ❌ | ✔️ | ✔️ | ❌ | ❌ |

| register_function_factory | ❌ | ✔️ | ❌ | ❌ | ❌ | ✔️ | ✔️ | ✔️ |

Domain是函数的输入的值域经过函数转换后得出的值域, 一些函数计算是符合单调性等特性的, 利用这类特性我们轻量级计算出函数的值域,这对后续的Partition Prune 有很大帮助, 例如: 数据在底层是通过 timestamp 排序的, 在索引层我们会有timestamp列的 Min/Max 索引, 那么对于带 where to_date(timestamp) > '2020-01-01' 过滤条件的SQL查询, 根据索引数据可以利用 Domain 计算出 to_date(timestamp) 列的 Min/Max 索引,从而进入 Prune 逻辑。

i8 --> i16 --> i32 --> i64u32 --> i64, u64 ---> i64, 转型过程出现溢出会抛出错误i32 --> f64, u64 --> f64, 转型过程出现溢出会抛出错误null类型能转为nullable<T>类型, 如: null --> nullable<i32>T 类型能转为 nullable<T> 类型, 如: i32 --> nullable<i32>T 能转为 U 类型,则 nullable<T> 类型能转为 nullable<U> 类型, 则 Array<T> 类型能转为 Array<U> 类型由于数值类型较多,大部分情况下我们只需要定义 最大类型即可,如 asin 只需要定义 NumberType<f64> 类型的参数, 接收到其他类型的参数时会自动转型, 例如: asin(i32) 会自动转型为 asin(f64); 在少数性能敏感计算,我们会给较小范围的 数值参数定义额外函数重载, 如 plus, minus, 此时由于自动转换规则的存在,我们必须注意重载的函数必须定义在最大类型的函数之前, 因为函数的查找是按注册顺序进行查找, 只捕获符合条件的第一个函数。

所以: i32 优先 定义于 i64, u64 优先定义于 i64, i64 优先定义于 f64, null 优先定义于 nullable。

Databend 的绝大部分系统表都位于 query/storage 这个目录下,当然,如果因为一些特殊的构建原因无法放在这个位置的话,也可以考虑临时放到 service/databases/system 这个目录(不推荐)。

系统表的定义主要关注两个内容:一个是表的信息,会包含表名、Schema 这些;另一个就是表中数据的生成/获取。刚好可以对应到 SyncSystemTable 和 AsyncSystemTable 这两个 Trait 中的 get_table_info 和 get_full_data 。到底是同步还是异步,取决于在获取数据时,是否涉及到异步函数的调用。

本文将会以 credits 表的实现为例,介绍 Databend 系统表的实现,代码位于 https://github.com/datafuselabs/databend/blob/main/src/query/storages/system/src/credits_table.rs 。credits 会返回 Databend 所用到的上游依赖的信息,包括名字、版本和许可三个字段。

首先,需要参考其他系统表的实现,去定义表对应的结构,只需要保有表信息的字段就可以了。

+pub struct CreditsTable {

+ table_info: TableInfo,

+}

+接下来是为 CreditsTable 表实现 create 方法,对应的函数签名如下:

pub fn create(table_id: u64) -> Arc<dyn Table>

+传入的 table_id 会在创建表时由 sys_db_meta.next_table_id() 生成。

schema 用于描述表的结构,需要使用 TableSchemaRefExt 和 TableField 来创建,字段名字和类型取决于表中的数据。

let schema = TableSchemaRefExt::create(vec![

+ TableField::new("name", TableDataType::String),

+ TableField::new("version", TableDataType::String),

+ TableField::new("license", TableDataType::String),

+]);

+对于字符串类数据,可以使用 TableDataType::String ,其他基础类型也类似。但如果你需要允许字段中存在空值,比如字段是可以为空的 64 位无符号整数,则可以使用 TableDataType::Nullable(Box::new(TableDataType::Number(NumberDataType::UInt64))) 的方式,TableDataType::Nullable 表示允许空值,TableDataType::Number(NumberDataType::UInt64) 表征类型是 64 位无符号整数。

接下来就是定义表的信息,基本上只需要依葫芦画瓢,把描述、表名、元数据填上就好。

+let table_info = TableInfo {

+ desc: "'system'.'credits'".to_string(),

+ name: "credits".to_string(),

+ ident: TableIdent::new(table_id, 0),

+ meta: TableMeta {

+ schema,

+ engine: "SystemCredits".to_string(),

+ ..Default::default()

+ },

+ ..Default::default()

+};

+

+SyncOneBlockSystemTable::create(CreditsTable { table_info })

+对于同步类型的表往往使用 SyncOneBlockSystemTable 创建,异步类型的则使用 AsyncOneBlockSystemTable 。

接下来,则是实现 SyncSystemTable ,SyncSystemTable 除了需要定义 NAME 之外,还需要实现 4 个函数 get_table_info 、get_full_data、get_partitions 和 truncate ,由于后两个有默认实现,大多数时候不需要考虑实现自己的。(AsyncSystemTable 类似,只是没有 truncate )

NAME 的值遵循 system.<name> 的格式。

const NAME: &'static str = "system.credits";

+get_table_info 只需要返回结构体中的表信息。

fn get_table_info(&self) -> &TableInfo {

+ &self.table_info

+}

+get_full_data 是相对重要的部分,因为每个表的逻辑都不太一样,credits 的三个字段基本类似,就只举 license 字段为例。

let licenses: Vec<Vec<u8>> = env!("DATABEND_CREDITS_LICENSES")

+ .split_terminator(',')

+ .map(|x| x.trim().as_bytes().to_vec())

+ .collect();

+license 字段的信息是从名为 DATABEND_CREDITS_LICENSES 的环境变量(参见 common-building)获取的,每条数据都用 , 进行分隔。

字符串类型的列最后是从 Vec<Vec<u8>> 转化过来,其中字符串需要转化为 Vec<u8> ,所以在迭代的时候使用 .as_bytes().to_vec() 做了处理。

在获取所有数据后,就可以按 DataBlock 的形式返回表中的数据。非空类型,使用 from_data ,可空类型使用 from_opt_data 。

Ok(DataBlock::new_from_columns(vec![

+ StringType::from_data(names),

+ StringType::from_data(versions),

+ StringType::from_data(licenses),

+]))

+最后,要想将其集成到 Databend 中,还需要编辑 src/query/service/src/databases/system/system_database.rs,将其注册到 SystemDatabase 中 。

impl SystemDatabase {

+ pub fn create(sys_db_meta: &mut InMemoryMetas, config: &Config) -> Self {

+ ...

+ CreditsTable::create(sys_db_meta.next_table_id()),

+ ...

+ }

+}

+系统表的相关测试目前仍然位于 src/query/service/tests/it/storages/system.rs 。

对于内容不会经常动态变化的表,可以使用 Golden File 测试,其运行逻辑是将对应的表写入指定的文件中,然后对比每次测试时文件内容是否发生变化。

+#[tokio::test(flavor = "multi_thread")]

+async fn test_columns_table() -> Result<()> {

+ let (_guard, ctx) = crate::tests::create_query_context().await?;

+

+ let mut mint = Mint::new("tests/it/storages/testdata");

+ let file = &mut mint.new_goldenfile("columns_table.txt").unwrap();

+ let table = ColumnsTable::create(1);

+

+ run_table_tests(file, ctx, table).await?;

+ Ok(())

+}

+对于内容可能会变化的表,目前缺乏充分的测试手段。可以选择测试其中模式相对固定的部分,比如行和列的数目;也可以验证输出中是否包含特定的内容。

+

+#[tokio::test(flavor = "multi_thread")]

+async fn test_metrics_table() -> Result<()> {

+ ...

+ let result = stream.try_collect::<Vec<_>>().await?;

+ let block = &result[0];

+ assert_eq!(block.num_columns(), 4);

+ assert!(block.num_rows() >= 1);

+

+ let output = pretty_format_blocks(result.as_slice())?;

+ assert!(output.contains("test_test_metrics_table_count"));

+ #[cfg(feature = "enable_histogram")]

+ assert!(output.contains("test_test_metrics_table_histogram"));

+

+ Ok(())

+}

+目前 Databend 采用 nightly 发布模式,每天夜里都会打包二进制文件,并递增 patch 版本。

+目前主要关注的 targets 包括:

+为方便体验,release 中除了 meta 和 query 的二进制文件之外,还包含一份默认配置和用于快速启动的脚本。

+✦ ❯ tree .

+.

+├── bin

+│ ├── databend-meta

+│ ├── databend-metabench

+│ ├── databend-metactl

+│ └── databend-query

+├── configs

+│ ├── databend-meta.toml

+│ └── databend-query.toml

+├── readme.txt

+└── scripts

+ ├── start.sh

+ └── stop.sh

+

+3 directories, 11 files

+readme.txt 中包含一些必要的提示信息,只需执行 ./scripts/start.sh 即可快速启动 databend 。

尽管采用 nightly 发布模式,但 Databend 并非野蛮生长。除了年度路线图外,Databend 还会按开发阶段发布版本路线图,这也决定了当前 minor 版本的分配。

+日常维护工作虽然简单,但却是保证项目活力和竞争力的有效手段。本文将会介绍 Databend 是如何与最新的工具链/依赖关系协同的。

+Databend 的日常维护工作主要分为两大类:一类是工具链更新,另一类则是依赖关系更新。

+工具链更新会随着 Rust 版本更新进行。在新的 stable 版本发布后,Databend 就会升级到对应日期附近的 nightly 工具链。

+更新工具链的必要步骤是编辑 scripts/setup/rust-toolchain.toml 的 channel 字段,并提交 Pull Request 。PR 合并后,会构建新的 build-tool 镜像,以确保 Databend 的 CI workflow 可以正常运行。

在镜像构建完成后,还需要完成以下工作:

+rust-toolchain.toml,确保它和 scripts/setup/rust-toolchain.toml 一致。scripts/setup/run_build_tool.sh make lint,确保 clippy 无警告。

+#[allow(clippy::xxx)] 来跳过部分 clippy 规则。scripts/setup/run_build_tool.sh make test,确保测试通过。依赖关系更新以大约 30 天一次的频率进行,需要在应用上游最新成果和维持项目稳定构建之间进行权衡。

+当前 Databend 有数以千计的第三方依赖,除了 crates.io 上的依赖外,还有部分源自 github 上的某次提交或者是分叉的上游项目。

+这里列出一套相对普适的更新步骤:

+cargo upgrade --workspace 以更新来源为 crates.io 的依赖。

+upgrade 子命令依赖 cargo-edit,在使用前需要安装。rev 。

+version 或 branch 字段,这不利于后续更新维护。make lint 和 make test,以确保更新顺利进行。

+cargo upgrade --workspace 无法更新依赖,可以尝试先执行一遍 cargo update 。Cargo.lock 做一些手脚,请确保一切检查都可以顺利通过,并在 PR 中进行解释。全链路追踪意味着能够追踪到每一个调用请求的完整调用链路、收集性能数据并反馈异常。Databend 使用 tracing 赋能可观测性,实现全链路追踪。

+初步了解 Databend 怎么实现全链路追踪。

+Tracing 是由 Tokio 团队维护的 Rust 应用追踪框架,用来收集结构化的、基于事件的诊断信息。

+项目地址:https://github.com/tokio-rs/tracing

+示例:

+use tracing::{info, Level};

+use tracing_subscriber;

+

+fn main() {

+ let collector = tracing_subscriber::fmt()

+ // filter spans/events with level TRACE or higher.

+ .with_max_level(Level::TRACE)

+ // build but do not install the subscriber.

+ .finish();

+

+ tracing::collect::with_default(collector, || {

+ info!("This will be logged to stdout");

+ });

+ info!("This will _not_ be logged to stdout");

+}

+Databend 的 tracing-subscriber 被统一整合在 common/tracing,由 query 和 meta 共用。

// Use env RUST_LOG to initialize log if present.

+// Otherwise use the specified level.

+let directives = env::var(EnvFilter::DEFAULT_ENV).unwrap_or_else(|_x| level.to_string());

+let env_filter = EnvFilter::new(directives);

+let subscriber = Registry::default()

+ .with(env_filter) # 根据环境变量过滤

+ .with(JsonStorageLayer) # 利用 tracing-bunyan-formatter 格式化为 json

+ .with(stdout_logging_layer) # 标准输出

+ .with(file_logging_layer) # 输出到文件,默认位于 `_logs` 目录下

+ .with(jaeger_layer); # opentelemetry-jaeger

+

+#[cfg(feature = "console")]

+let subscriber = subscriber.with(console_subscriber::spawn()); # tokio console

+

+tracing::subscriber::set_global_default(subscriber)

+ .expect("error setting global tracing subscriber");

+具体到内部的 tracing 记录,大致有两类:

普通:与其他 log 方式一样,利用 info!、debug! 来收集信息。

use common_tracing::tracing;

+

+tracing::info!("{:?}", conf);

+tracing::info!("DatabendQuery {}", *databend_query::DATABEND_COMMIT_VERSION);

+Instruments:在调用函数时创建并进入 tracing span(跨度),span 表示程序在特定上下文中执行的时间段。

+use common_tracing::tracing::debug_span;

+#[tracing::instrument(level = "debug", skip_all)]

+async fn read(&mut self) -> Result<Option<DataBlock>> {

+ ...

+ fetched_metadata = read_metadata_async(&mut self.reader)

+ .instrument(debug_span!("parquet_source_read_meta"))

+ .await

+ .map_err(|e| ErrorCode::ParquetError(e.to_string()))?;

+ ...

+}

+示例:

+{

+ "v": 0,

+ "name": "databend-query-test_cluster@0.0.0.0:3307",

+ "msg": "Shutdown server.",

+ "level": 30,

+ "hostname": "dataslime",

+ "pid": 53341,

+ "time": "2022-05-11T00:51:56.374807359Z",

+ "target": "databend_query",

+ "line": 153,

+ "file": "query/src/bin/databend-query.rs"

+}

+Databend 原生提供了多种观测方式,以方便诊断和调试:

+_logs 目录(根据配置)。select * from system.tracing limit 20; 。使用 Jaeger 对 Databend 进行全链路追踪。

+OpenTelemetry 是工具、API 和 SDK 的集合。使用它来检测、生成、收集和导出遥测数据(度量、日志和追踪),以帮助您分析软件的性能和行为。

+Jaeger 是一个开源的端到端分布式追踪系统。由 Uber 捐赠给 CNCF 。它可以用于监视基于微服务的分布式系统,提供以下能力:

+

遵循下述步骤,即可使用 Jaeger 探索 Databend :

+cargo build(可以使用 --bin 指定)。DEBUG ,接着运行需要调试的应用程式。例如,DATABEND_JAEGER_AGENT_ENDPOINT=localhost:6831 LOG_LEVEL=DEBUG ./databend-query 。docker run -d -p6831:6831/udp -p6832:6832/udp -p16686:16686 jaegertracing/all-in- one:latest 。http://127.0.0.1:16686/ 以查看 jaeger 收集的信息。注意 只有正确配置 DATABEND_JAEGER_AGENT_ENDPOINT 才能启用 Jaeger 支持。

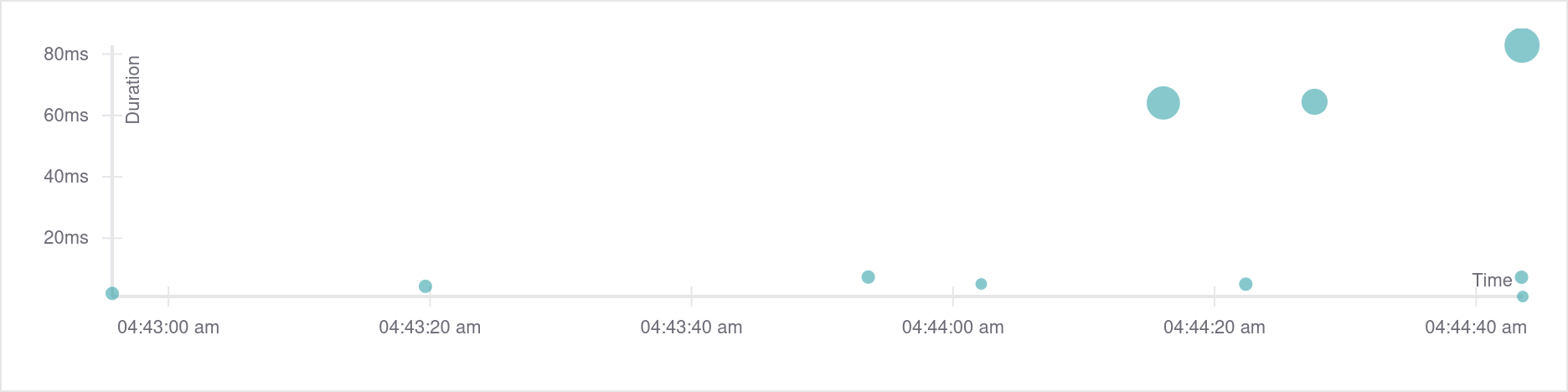

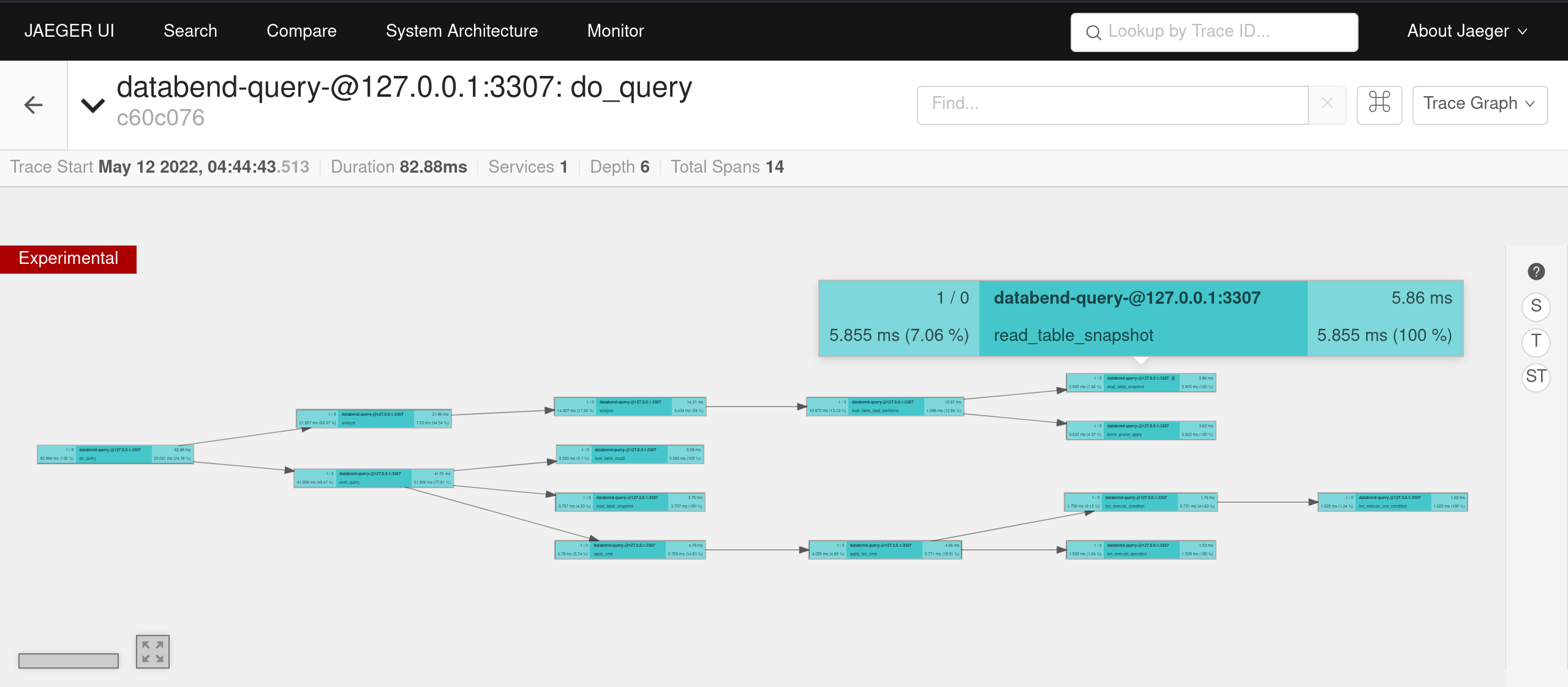

x 轴是执行时刻,y 轴是持续的时间,圆点反映 span 的聚集程度。

+执行下述语句即可得到上图所示追踪结果:

+CREATE TABLE t1(a INT);

+INSERT INTO t1 VALUES(1);

+INSERT INTO t1 SELECT * FROM t1;

+Timeline

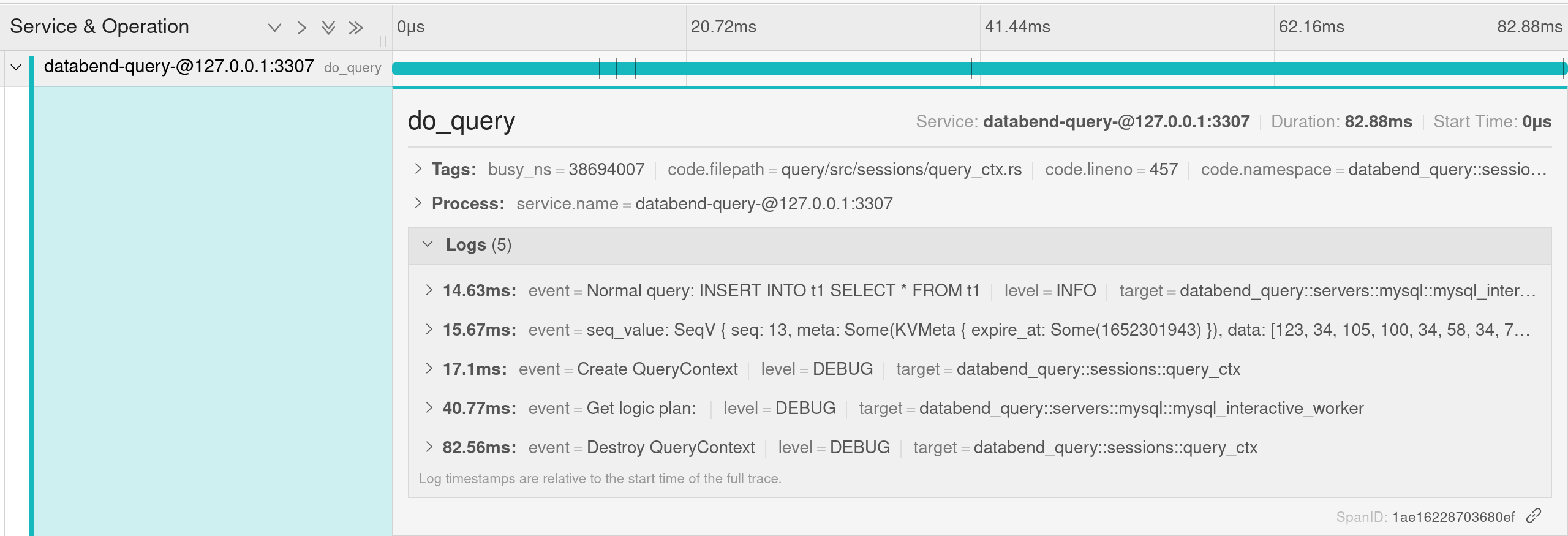

+下图是点击最大的圆点得到的追踪情况:

+

使用 timeline 模式来展现 tracing 的各个跨度之间的关系。以时间为主线进行分析,方便使用者观看在某个时间点观看程序信息。

+点开第一个跨度,可以看到这是执行 INSERT INTO t1 SELECT *FROM t1 查询时的情况。

Graph

+切换到 graph 模式,可以看到各个 span 之间的调用链,每个 span 具体用时 ,以及百分比。

+

通过这个视图使用者很容易知道系统瓶颈,快速定位问题。

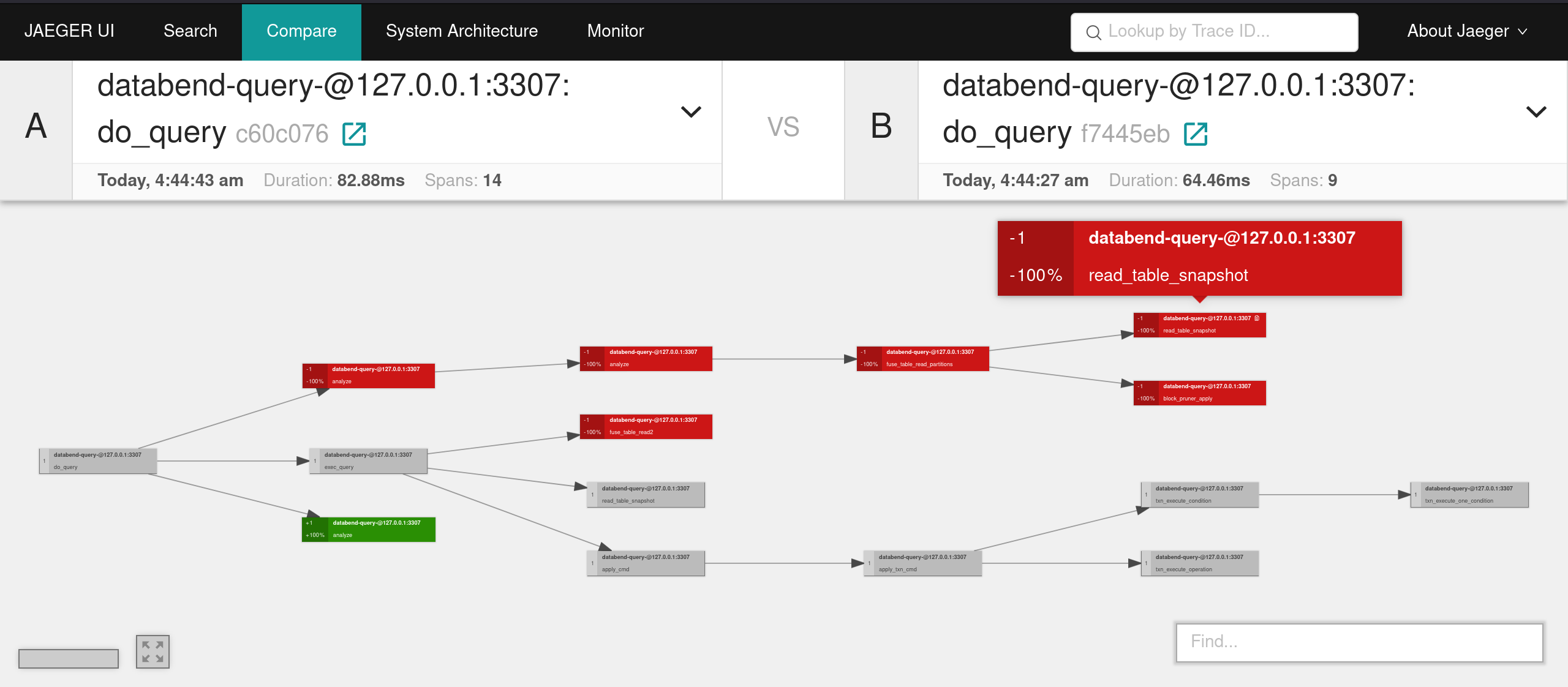

+Compare

+连起来的各个部分形成整个 trace 的调用链。因为比较时一般会比较两个相同类型的调用,所以看到的会是重合后的视图。

+

对于颜色的一个说明:

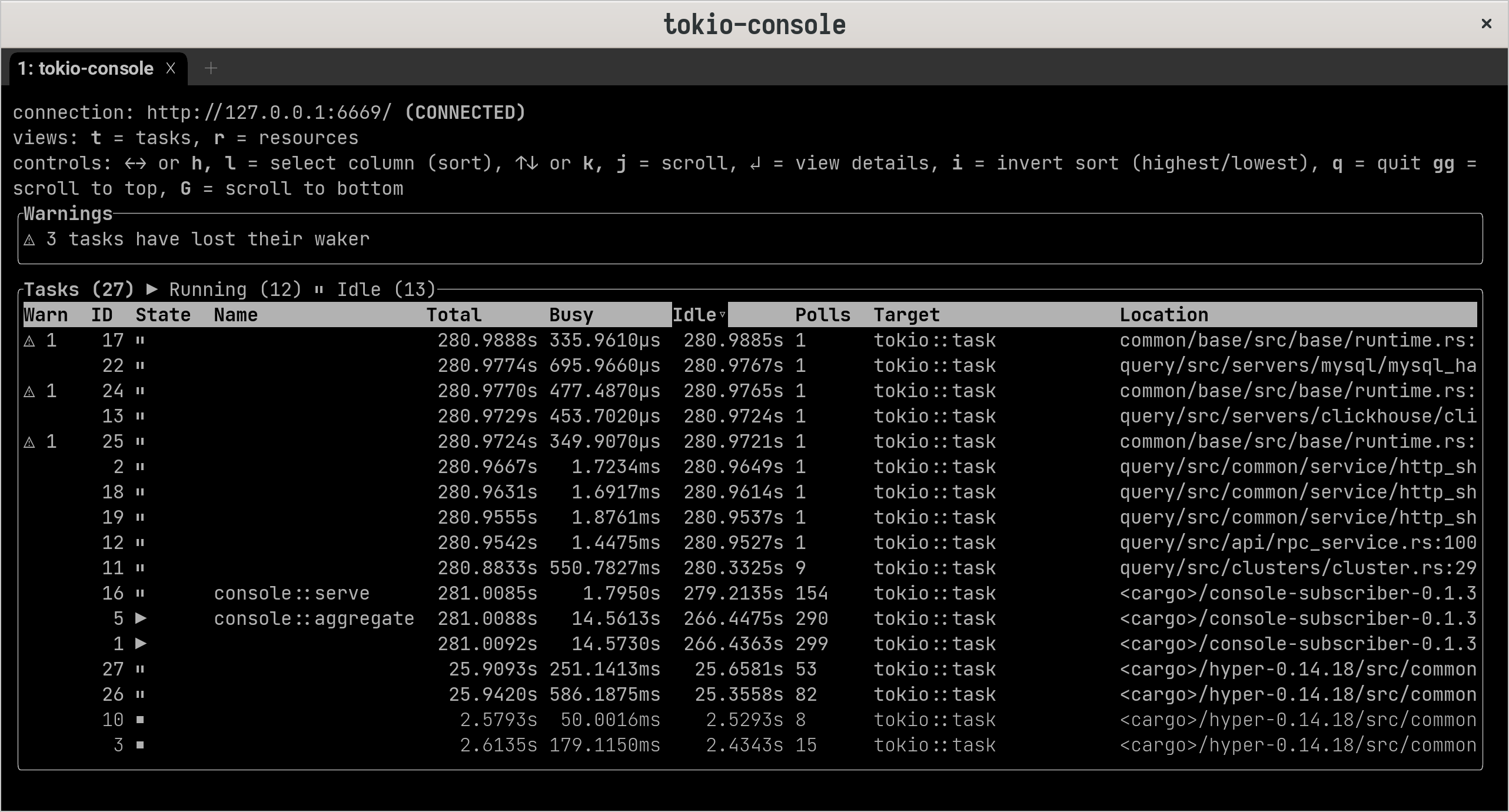

+tokio-rs 团队出品的诊断和调试工具,可以帮助我们诊断与 tokio 运行时相关的问题。

+

tokio-console 是专为异步程序设计的调试与诊断工具,能够列出 tokio 的任务,提供对程序的任务和资源的实时、易于导航的视图,总结了它们的当前状态和历史行为。主要包含以下组件:

+项目地址:https://github.com/tokio-rs/console

+rustflags 和 features 来构建:

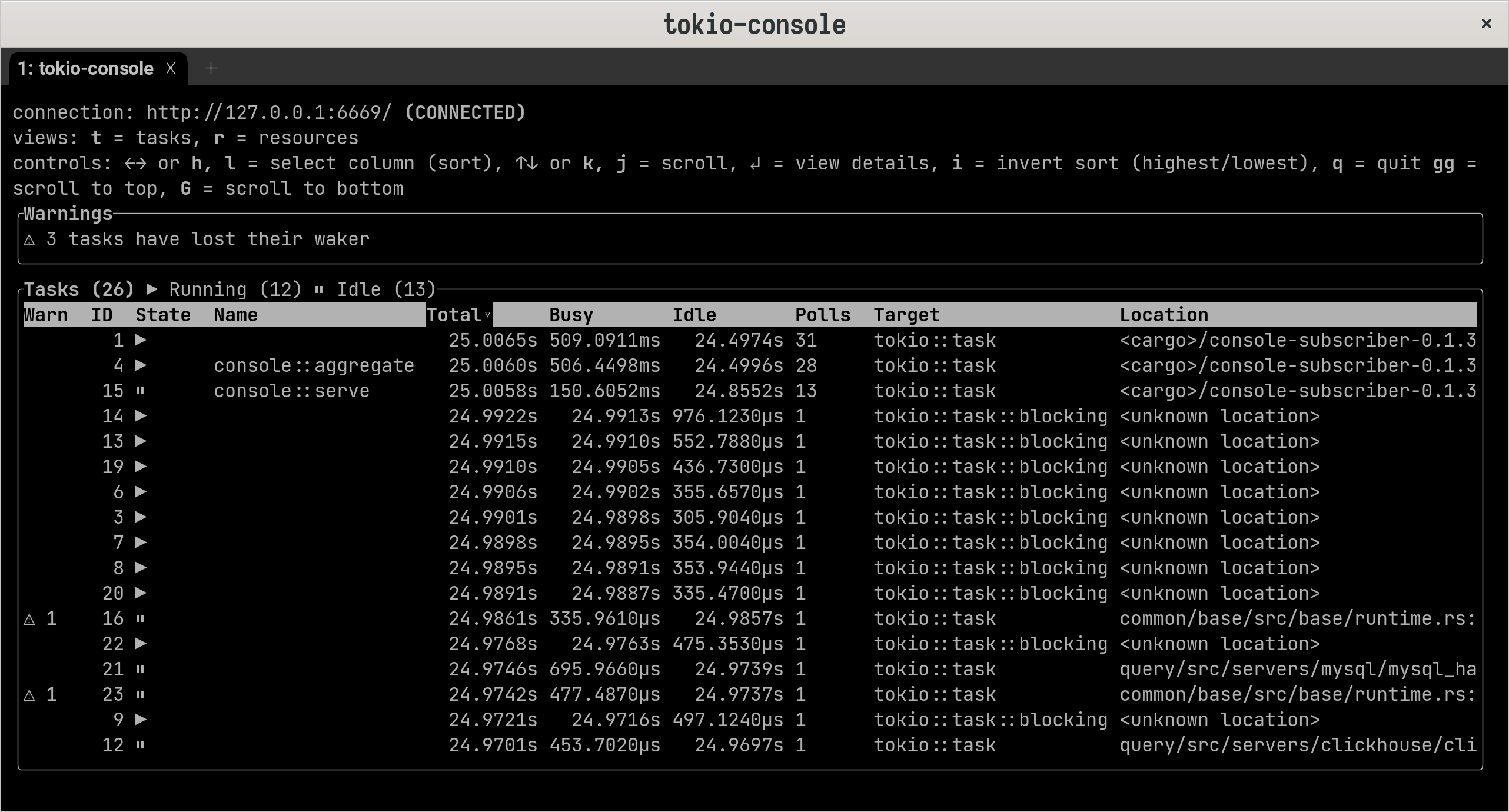

+RUSTFLAGS="--cfg tokio_unstable" cargo build --features tokio-console ,也可以只构建单个二进制程式,使用 --bin 进行指定。TRACE ,运行需要调试的应用程式 LOG_LEVEL=TRACE databend-query 或者 databend-meta --single --log-level=TRACE。可以使用 TOKIO_CONSOLE_BIND 指定端口,以避免潜在的端口抢占问题。tokio-console,默认连接到 http://127.0.0.1:6669 。任务

+先看什么是 tokio 任务:

+

基础视图

+通过左右切换,可以得到总忙时间或轮询次数等指标对任务进行排序。控制台通过高亮来提示较大差异,比如从毫秒到秒的切换。

+

控制台还实现了一个“警告”系统。通过监视应用程序中任务的运行时操作,控制台可以检测可能提示 bug 或性能问题的行为模式,并突出显示这些行为模式供用户分析。比如已经运行了很长时间而没有让步的任务,唤醒的次数比被其他任务唤醒的次数还要多的任务。

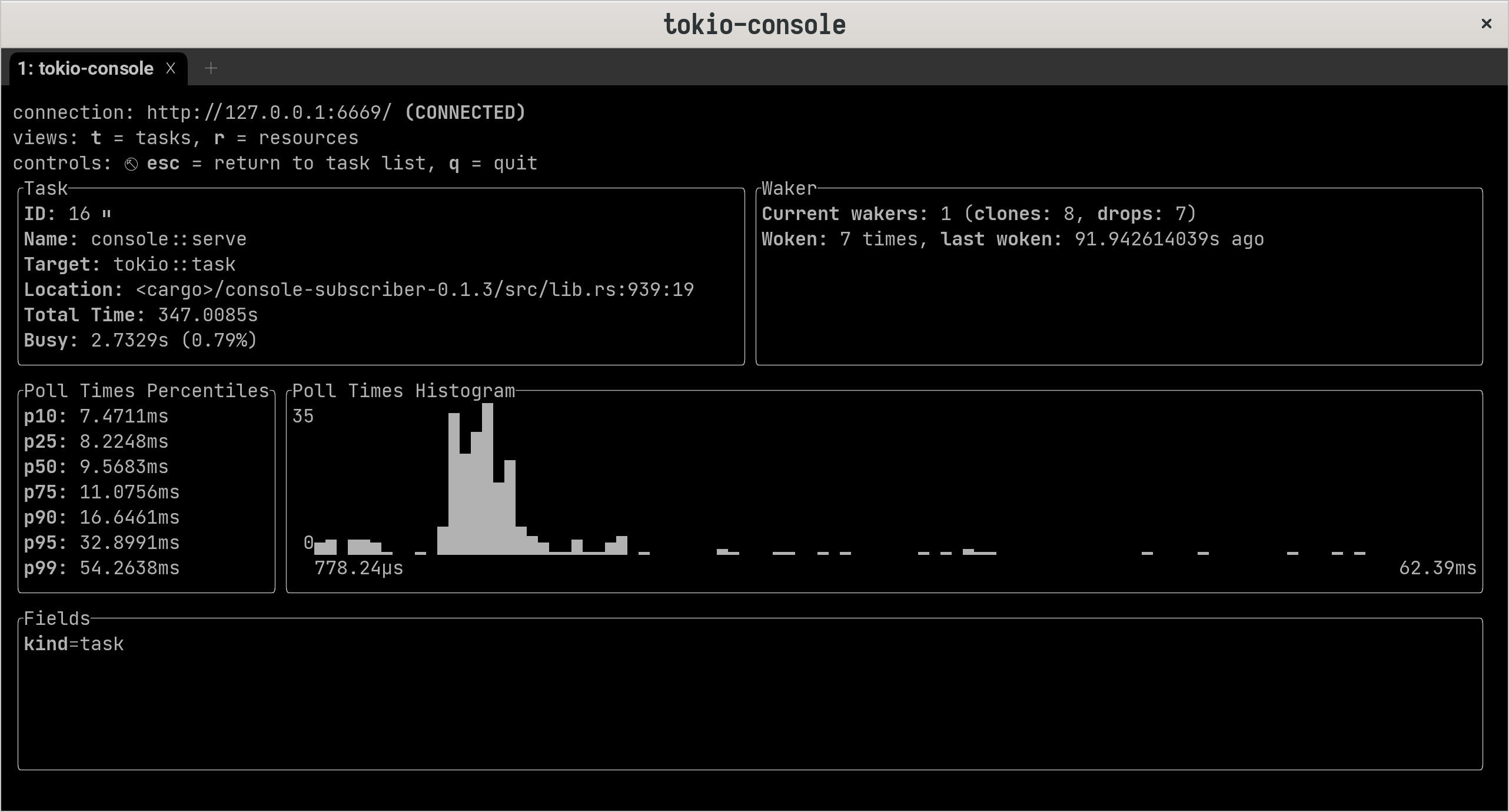

+任务视图

+上下切换选中任务,enter 查看关于每个任务的翔实数据,比如轮询持续时间的直方图。

+

不仅列出任务。console 还会插入异步互斥和信号量等资源。Tokio Console 的资源详细信息视图显示了哪些任务已经进入临界区,哪些任务正在等待获得访问权限。

+与分布式追踪和日志系统相关的一些其他内容。

+目前还有一系列关于可观测性和 Tracing 的 Issue 有待解决:

+另外,更进一步的考量是,如何基于可观测性来自动/半自动地发现问题并对系统进行调优。

+Tracing

+Jaeger

+tokio-console

+测试是提高软件健壮性、加速迭代进程的不二法宝。本文将会介绍如何为 Databend 添加不同种类的测试。

+++在「产品力:Databend 的质量保障」一文中,已经介绍到组成 Databend 测试的两个重要部分 —— 单元测试和功能测试。如有遗忘,不妨回顾一下。

+

Databend 的单元测试组织形式有别于一般的 Rust 项目,是直接一股脑放在 tests/it 目录下的。同时,在各个 crate 的 Cargo.toml 中,也针对性地禁用了 doctest 和 bin/lib test 。

优点

+src),只需要编译对应的 it(test) ,节省时间。缺点

+tests/it 会把需要测试的 crate 当作一个外部对象,所有待测试的内容都需要被设定为 pub 。不利于软件设计上的分层,整个项目结构会迅速的被破坏,需要引入编码规范并更加依赖开发者的主动维护。可以简单地将单元测试分为两类,一类是不需要外部文件介入的纯 Rust 测试,一类是 Golden Files 测试。

+Rust 测试

+与平时编写 Rust 单元测试相同,只是待测试的内容需要设为 pub ,且引用待测试 crate 需要使用该 crate 的名字。

Databend 提供一些用于模拟全局状态的函数,如 create_query_context 等,可能会有助于编写测试。

#[tokio::test(flavor = "multi_thread", worker_threads = 1)]

+async fn test_credits_table() -> Result<()> {

+ let ctx = crate::tests::create_query_context().await?;

+

+ let table = CreditsTable::create(1);

+ let source_plan = table.read_plan(ctx.clone(), None).await?;

+

+ let stream = table.read(ctx, &source_plan).await?;

+ let result = stream.try_collect::<Vec<_>>().await?;

+ let block = &result[0];

+ assert_eq!(block.num_columns(), 3);

+ Ok(())

+}

+上面示例来自 credits_table 的测试,先构建 read_plan 读取新建的 CreditsTable 表,再对列数进行断言。

Golden Files 测试

+++Golden File Testing are like unit tests, except the expected output is stored in a separate file. -- Max Grigorev at ZuriHac

+

Golden Files 测试是一种常用的测试手段,相当于是一类快照测试,如果执行情况和预期结果存在差异则认为测试失败。

+Databend 使用 goldenfile 这个 crate 来编写 Golden Files 测试。目前 Databend 有计划用此替代 assert_blocks 系列断言。

#[test]

+fn test_expr_error() {

+ let mut mint = Mint::new("tests/it/testdata");

+ let mut file = mint.new_goldenfile("expr-error.txt").unwrap();

+

+ let cases = &[

+ r#"5 * (a and ) 1"#,

+ r#"a + +"#,

+ r#"CAST(col1 AS foo)"#,

+ r#"1 a"#,

+ r#"CAST(col1)"#,

+ r#"G.E.B IS NOT NULL AND

+ col1 NOT BETWEEN col2 AND

+ AND 1 + col3 DIV sum(col4)"#,

+ ];

+

+ for case in cases {

+ run_parser!(file, expr, case);

+ }

+}

+编写 Golden Files 测试时需要指定挂载的目录和对应预期结果的文件。

+在执行测试的主体部分(如上面示例中的 run_parser! 宏),除了封装运行测试的必要逻辑外,还需要定义输出时的格式。

测试文件必须按指定格式编写。或者,使用 REGENERATE_GOLDENFILES=1 生成。

下面 Golden File 的例子节选自 common/ast 模块测试的 testdata/expr-error.txt,Output 对应解析 5 * (a and ) 1 的预期结果。

---------- Input ----------

+5 * (a and ) 1

+---------- Output ---------

+error:

+ --> SQL:1:12

+ |

+1 | 5 * (a and ) 1

+ | - ^ expected more tokens for expression

+ | |

+ | while parsing expression

+单元测试的运行可以运行 make unit-test 或者是 cargo test --workspace 。

二者的区别在于 make unit-test 封装了 ulimit 命令控制最大文件数和栈的大小以确保测试能够顺利运行,如果使用 MacOS 则更建议使用 make unit-test 。

通过过滤机制,可以轻松指定运行名字中具有特定内容的测试,例如 cargo test test_expr_error 。

Rust 测试

+同其他项目中的 Rust 测试一样,可以根据友好的错误提示轻松定位出现故障的测试。如果需要详细的 Backtrace ,可以在运行测试命令时添加环境变量 RUST_BACKTRACE=1 。

failures:

+

+---- buffer::buffer_read_number_ext::test_read_number_ext stdout ----

+Error: Code: 1046, displayText = Cannot parse value:[] to number type, cause: lexical parse error: 'the string to parse was empty' at index 0.

+

+<Backtrace disabled by default. Please use RUST_BACKTRACE=1 to enable>

+thread 'buffer::buffer_read_number_ext::test_read_number_ext' panicked at 'assertion failed: `(left == right)`

+ left: `1`,

+ right: `0`: the test returned a termination value with a non-zero status code (1) which indicates a failure', /rustc/cd282d7f75da9080fda0f1740a729516e7fbec68/library/test/src/lib.rs:185:5

+note: run with `RUST_BACKTRACE=1` environment variable to display a backtrace

+Golden Files 测试

+Golden Files 测试的执行命令与 Rust 测试相同,但在错误提示方面有所差异。得益于 goldenfiles 引入了 similar-assert ,可以轻松识别 diff :

Differences (-left|+right):

+ ---------- Output ---------

+ 'I'm who I'm.'

+ ---------- AST ------------

+ Literal {

+ span: [

+- QuotedString(0..18),

++ QuotedString(0..16),

+ ],

+ lit: String(

+ "I'm who I'm.",

+ ),

+ }

+.cargo/git/checkouts/rust-goldenfile-6352648ef139d984/16c5783/src/differs.rs:15:5

+note: run with `RUST_BACKTRACE=1` environment variable to display a backtrace

+上面示例中,+ 对应测试实际结果,- 对应测试预期结果,其他为相关的上下文。

goldenfiles 的报错可能会涉及多个测试文件,受限于长文本支持和空格显示,排查仍可能存在不便。

+这里提供一个相对友好的排查思路:

+REGENERATE_GOLDENFILES=1 cargo test -p <package> --test it 重新生成对应的测试。git diff 来显示前后 goldenfiles 文件的差异。功能测试主要由 SQL 逻辑测试(sqllogictest)和 stateful 测试两个部分组成。

+从本质上讲,这两类功能测试流程相同:

+在设计上,SQL 逻辑测试可以提供更全面的能力:

+SQL 逻辑测试

+SQL 逻辑测试放在 tests/logictest 目录下。

语句规范在 sqlite sqllogictest 的基础上进行拓展,可以分成以下几类:

+statement ok :SQL 语句正确,且成功执行。statement error <error regex> :SQL 语句输出期望的错误。statement query <desired_query_schema_type> <options> <labels> :SQL语句成功执行并输出预期结果。statement query B label(mysql,http)

+select count(1) > 1 from information_schema.columns;

+

+---- mysql

+1

+

+---- http

+true

+上面的例子展示了如何对 mysql 和 http 分别设计对应的输出结果。其中 B 表示结果为布尔类型,label 用来标记协议。

SQL 逻辑测试同样支持测试集生成 python3 gen_suites.py 。

stateful 测试

+stateful 测试放在 tests/suites 目录下:

++这里展示的是一类 stateless 写法,stateful 与之类似,区别在于 stateful 会加载数据集并执行查询。

+

输入是一系列 sql 语句,对应目录中的 *.sql 文件。

SELECT '==Array(Int32)==';

+

+CREATE TABLE IF NOT EXISTS t2(id Int null, arr Array(Int32) null) Engine = Fuse;

+

+INSERT INTO t2 VALUES(1, [1,2,3]);

+INSERT INTO t2 VALUES(2, [1,2,4]);

+INSERT INTO t2 VALUES(3, [3,4,5]);

+SELECT max(arr), min(arr) FROM t2;

+SELECT arg_max(id, arr), arg_min(id, arr) FROM (SELECT id, arr FROM t2);

+输出对应查询结果(含报错),如果没有输出则需要置空,对应目录中的 *.result 文件。

==Array(Int32)==

+[3, 4, 5] [1, 2, 3]

+3 1

+测试可以覆盖 SQL 执行过程中遇到预期错误的情况,有两种方式:

+沿用上面的方法,在 result 文件中标注具体报错信息。

也可以采用 ErrorCode 注释的方式,此时无需在 result 文件中添加对应内容。

SELECT INET_ATON('hello');-- {ErrorCode 1060}

+++由于 stateful 测试和 sqllogictest 测试均由 Python 编写,在运行前请确保你已经安装全部的依赖。

+

这几类测试都有对应的 make 命令,并支持集群模式测试:

sqllogictest 测试:make sqllogic-test & make sqllogic-cluster-test 。stateful 测试:make stateful-test & make stateful-cluster-test 。(一般在 CI 中运行,本地需要正确配置 MINIO 环境)。sqllogictest 测试

+sqllogictest 测试能提供精准到语句的报错,并提供更多有效的上下文帮助排查问题。

+AssertionError: Expected:

+INFORMATION_SCHEMA

+default

+ Actual:

+ INFORMATION_SCHEMA

+ db_12_0003

+ default

+ Statement:

+Parsed Statement

+ at_line: 77,

+ s_type: Statement: query, type: T, query_type: T, retry: False,

+ suite_name: gen/02_function/02_0005_function_compare,

+ text:

+ select * from system.databases where name not like '%sys%' order by name;

+ results: [(<re.Match object; span=(0, 4), match='----'>, 83, 'INFORMATION_SCHEMA\ndefault')],

+ runs_on: {'mysql', 'clickhouse', 'http'},

+ Start Line: 83, Result Label:

+make: *** [Makefile:82: sqllogic-test] Error 1

+stateful 测试

+目前 stateful 测试能够提供文件级的报错和 diff ,但无法确定报错是由哪一条语句产生。

+++这里展示的是过去 stateless 引发的报错,stateful 与之类似。

+

02_0057_function_nullif: [ FAIL ] - result differs with:

+--- /projects/datafuselabs/databend/tests/suites/0_stateless/02_function/02_0057_function_nullif.result

++++ /projects/datafuselabs/databend/tests/suites/0_stateless/02_function/02_0057_function_nullif.stdout

+@@ -3,7 +3,7 @@

+ 1

+ 1

+ NULL

+-a

++b

+ b

+ a

+ NULL

+

+Having 1 errors! 207 tests passed. 0 tests skipped.

+The failure tests:

+ /projects/datafuselabs/databend/tests/suites/0_stateless/02_function/02_0057_function_nullif.sql

+提示

+databend-query-standalone-embedded-meta.sh 等脚本中的 nohup 有助于在测试时同时输出日志到终端,可能同样有助于排查。databend-test 文件中的 timeout 改短。1、启动databend-query并创建用户

+./databend/bin/databend-query &

+mysql -uroot -h127.0.0.1 -P3307 -e "CREATE USER 'sqlancer' IDENTIFIED BY 'sqlancer'; GRANT ALL ON *.* TO sqlancer;"

+2、打包sqlancer

+git clone https://github.com/sqlancer/sqlancer.git

+cd sqlancer

+mvn package -DskipTests

+3、运行sqlancer

+#方式一,运行test单元

+DATABEND_AVAILABLE=true mvn -Dtest=TestDatabend test

+#方式二,运行jar包,可指定参数

+cd target

+java -jar sqlancer-*.jar --num-threads 4 --random-string-generation ALPHANUMERIC databend --oracle WHERE

+#运行成功每5s输出一条信息

+[2022/10/01 19:33:12] Executed 1037 queries (207 queries/s; 0.80/s dbs, successful statements: 100%). Threads shut down: 0.

+[2022/10/01 19:33:17] Executed 2133 queries (219 queries/s; 0.00/s dbs, successful statements: 100%). Threads shut down: 0.

+[2022/10/01 19:33:22] Executed 3248 queries (223 queries/s; 0.00/s dbs, successful statements: 100%). Threads shut down: 0.

+[2022/10/01 19:33:27] Executed 4351 queries (220 queries/s; 0.00/s dbs, successful statements: 100%). Threads shut down: 0.

+4、列举以下常用options(主可选项定义在MainOptions类,另外一个定义在DatabendOptions类)

+-h:查看帮助

+--num-threads:线程数

+--timeout-seconds:运行时间,单位秒,默认-1无限执行

+--num-tries:指定多少次异常后停止测试,默认100

+--database-prefix:数据库的前缀名

+--random-string-generation:随机字符串模式

+--host:主机,默认localhost

+--port:端口,默认3307

+--username:用户名,默认sqlancer

+--password:密码,默认sqlancer

+databend:指定的DBMS

+--oracle:测试的方式

+Non-optimizing Reference Engine Construction (NoREC)

+Ternary Logic Partitioning (TLP)

+当sqlancer停止测试后,会先清除原来的日志文件(注意备份),然后将所有错误写入到新的日志文件中 ./sqlancer/logs/databend/*.log 其中 *-cur.log 为某个db执行的sql记录。

若TLP检测出logic bug,日志文件会包含以下信息(错误的 query sql与重现db的sql):其中cardinality不一致说明发生了logic bug。

+--java.lang.AssertionError: the size of the result sets mismatch (3 and 6)!

+-- Time: 2022/08/29 16:57:50

+-- Database: databend1

+-- Database version: 8.0.26-v0.8.12-nightly-74d0287-simd(rust-1.64.0-nightly-2022-08-27T03:09:50.519081067Z)

+-- seed value: 1

+DROP DATABASE IF EXISTS databend1;

+CREATE DATABASE databend1;

+USE databend1;

+CREATE TABLE t0(c0BOOLEAN BOOLEAN NULL DEFAULT(true));

+CREATE TABLE t1(c0FLOAT DOUBLE NULL DEFAULT(0.8522535562515259), c1VARCHAR VARCHAR NULL);

+INSERT INTO t1(c0float) VALUES (0.48751503229141235);

+INSERT INTO t1(c0float, c1varchar) VALUES (0.8522535562515259, NULL);

+INSERT INTO t1(c1varchar) VALUES ('2'), ('78');

+INSERT INTO t0(c0boolean) VALUES (false), (false), (true);

+INSERT INTO t1(c0float) VALUES (0.8522535562515259), (0.48751503229141235);

+INSERT INTO t1(c0float, c1varchar) VALUES (0.48751503229141235, '7555834'), (0.7298239469528198, '8');

+-- SELECT t0.c0boolean FROM t0;

+-- cardinality: 3

+-- SELECT t0.c0boolean FROM t0 WHERE (NULL BETWEEN NULL AND NULL) UNION ALL SELECT t0.c0boolean FROM t0 WHERE (NOT (NULL BETWEEN NULL AND NULL)) UNION ALL SELECT t0.c0boolean FROM t0 WHERE (((NULL BETWEEN NULL AND NULL)) IS NULL);

+-- cardinality: 6

+TLP发现的bug例如:sqlancer: expression expansion error · Issue #7360 · datafuselabs/databend (github.com)

+若NoREC检测出logic bug,日志文件会包含以下信息(错误的query sql与重现db的sql):

+第一条 query sql 返回的是结果的row数,第二条 query sql 返回的是count的和,若两数不一致则出现logic bug。

+java.lang.AssertionError: SELECT t1.c0float, t1.c1varchar, t0.c0boolean FROM t1 RIGHT JOIN t0 ON true WHERE (NOT -1257754687); -- 3

+SELECT SUM(count) FROM (SELECT (((NOT -1257754687) IS NOT NULL AND (NOT -1257754687)) ::BIGINT)as count FROM t1 RIGHT JOIN t0 ON true) as res -- 0

+-- Time: 2022/09/24 09:27:50

+-- Database: databend1

+-- Database version: 8.0.26-v0.8.46-nightly-f524701-simd(rust-1.66.0-nightly-2022-09-23T16:20:13.611527635Z)

+-- seed value: 1

+DROP DATABASE IF EXISTS databend1;

+CREATE DATABASE databend1;

+USE databend1;

+CREATE TABLE t0(c0BOOLEAN BOOLEAN NULL DEFAULT(true));

+CREATE TABLE t1(c0FLOAT DOUBLE NULL DEFAULT(0.8522535562515259), c1VARCHAR VARCHAR NULL);

+INSERT INTO t1(c0float) VALUES (0.48751503229141235);

+NoREC发现的bug例如:bug: select error · Issue #7863 · datafuselabs/databend (github.com)

+NoREC与TLP测试期间还会检测出使得databend错乱的bug:

+如果报错信息有 Cause by 且报错信息很复杂则极有可能是bug,也可能是sqlancer生成的sql语法错误。

情况比较多,例如:

+long SQL makes parser work really slow. · Issue #7225 · datafuselabs/databend (github.com)

+ +Bug in numerical_coercion of in operator · Issue #7203 · datafuselabs/databend (github.com)

+sqlancer: expression expansion error · Issue #7360 · datafuselabs/databend (github.com)

+ +bug: where clause error · Issue #7457 · datafuselabs/databend (github.com)

+bug: expression evaluation error · Issue #7460 · datafuselabs/databend (github.com)

+ +bug: expression evaluation error · Issue #7460 · datafuselabs/databend (github.com)

+bug: the content of the result sets mismatch · Issue #7463 · datafuselabs/databend (github.com)

+ + +bug: Hash table capacity overflow · Issue #7495 · datafuselabs/databend (github.com)

+bug: cannot convert NULL to a non-nullable type · Issue #7498 · datafuselabs/databend (github.com)

+bug: expression explain error · Issue #7543 · datafuselabs/databend (github.com)

+bug: select view error · Issue #7573 · datafuselabs/databend (github.com)

+bug: select error · Issue #7863 · datafuselabs/databend (github.com)

+bug: where clause explain error · Issue #7864 · datafuselabs/databend (github.com)

+ +bug: return error after adding form and join · Issue #8000 · datafuselabs/databend (github.com)

+ + + + + + + + +身为项目维护者和贡献者,我们承诺使社区参与者不受骚扰,无论其年龄、体型、可见或不可见的缺陷、族裔、性征、性别认同和表达、经验水平、教育程度、社会与经济地位、国籍、相貌、种族、种姓、肤色、宗教信仰、性倾向或性取向如何。

+我们承诺以有助于建立开放、友善、多样化、包容、健康社区的方式行事和互动。

+有助于创造积极和谐环境的例子包括:

+不可接受的参与者行为包括:

+项目的维护者有责任解释和落实我们所认可的行为准则,并妥善公正地对他们认为不当、威胁、冒犯或有害的任何行为采取纠正措施。

+项目的维护者有权力和责任删除、编辑或拒绝或拒绝与本行为准则不相符的评论(comment)、提交(commits)、代码、维基(wiki)编辑、议题(issues)或其他贡献,并在适当时机知采取措施的理由。

+本守则适用于任何个人代表此项目或此项目社区时的项目空间和公共空间。项目代表将由项目维护者进一步定义和阐述。

+如遇到辱骂、骚扰或其它不被接受的行为,请联系 psiace@datafuselabs.com 上报项目团队。所有投诉都将被审核调查,并给出核定后的结果。具体措施的细节可能会单独发布。

+违背行为守则的项目维护者, 在其他的项目维护者决定下,可能面临临时或永久的惩罚。

+本行为准则改编自 Contributor Covenant 2.1 版, 参见 https://www.contributor-covenant.org/version/2/1/code_of_conduct.html。

+ + + + + + +这里列出一些协作相关的基本流程。

+++适用于已经列在大纲下面的文章/主题。

+

++适用于已规划的大纲中不涉及的文章/主题。

+

欢迎 打开 issue 或 新建 Pull Request 帮助改进内容和版面。

+在反馈/修改时,请提供相关上下文以帮助判断问题现状。

+本站使用 https://giscus.app/ 关联 Github Discussions 。

+文章相关的讨论建议在对应文章的评论区中进行。如有一般性话题,请在 Github Discussions 中选择合适的板块发布。

+可以向以下 Databend 贡献者寻求 Review 支持:

+| 分类 | GitHub |

|---|---|

| Meta | drmingdrmer |

| Query | sundy-li |

| Optimizer | leiysky |

| Cluster | zhang2014 |

| Storage | dantengsky Xuanwo |

| Common | PsiACE |

已上线

+进行中

+规划中

+需调整

+规划中

+已上线

+规划中

+预计以视频和文字稿形式发布,按模块进行规划。

+已上线

+规划中

+规划中

+待定

+预期会以视频结合文字稿的形式发布。

+ + + + + + + + +Databend 是一个使用 Rust 研发、开源、完全面向云架构的新式数仓。

+「Databend 内幕大揭秘」将会透过 Databend 的设计与实现,为你揭开面向云架构的现代数据库的面纱。

+「Databend 内幕大揭秘」并不致力于展示数据库领域的全貌,而是紧紧围绕 Databend 来展示现代云数仓的方方面面:设计与架构、算法与实现等。

+本书大概可以分为三个部分:

+「Databend 内幕大揭秘」的内容完全开源,有意向参与协作和贡献的,请参考「贡献相关」一节的内容。

+ + + + + + + + +本篇是 minibend 系列的第二期,将会介绍 Data Source 部分的设计与实现,当然,由于是刚开始涉及到编程的部分,也会提到包括 类型系统 和 错误处理 之类的一些额外内容。

+++前排指路视频和 PPT 地址

+视频(哔哩哔哩):https://www.bilibili.com/video/BV1A84y1Y7Ff/

+PPT:https://databend-internals.psiace.me/minibend/ppt/minibend-002-datasource.pdf

+

这里仅仅是进行一个初步的介绍,类型系统相关的实现请期待下一期内容。

+在构建查询引擎的时候,很重要的一个问题就是「数据在查询引擎中是如何表示的?」。这往往意味着我们需要考虑引入一套类型系统来完成这一工作。

+为了能够让查询引擎处理来自不同数据源的数据,通常情况下,会选择设计并构建一套能够涵盖所有数据源所涉及的全部数据类型的类型系统,并引入一些额外的机制使得数据能够从数据源轻松转换到这套类型系统之上。

+当然,如果查询引擎仅仅针对单一数据源设计,或许可以考虑复用数据源的类型系统。

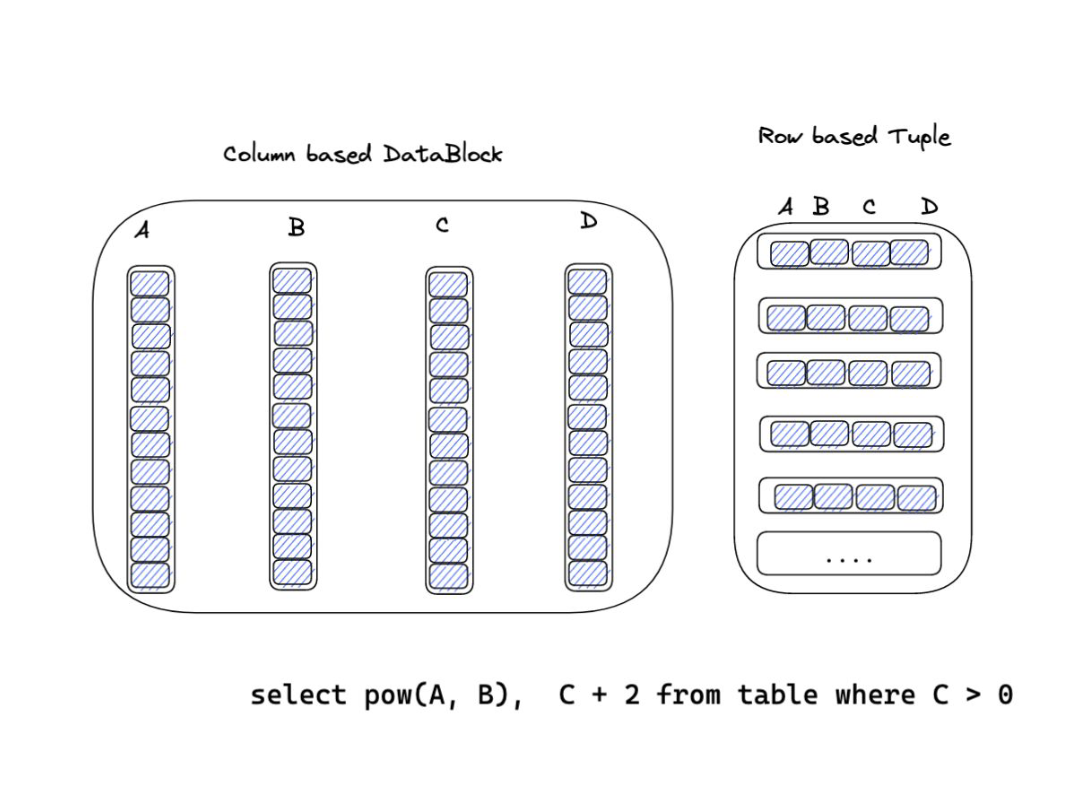

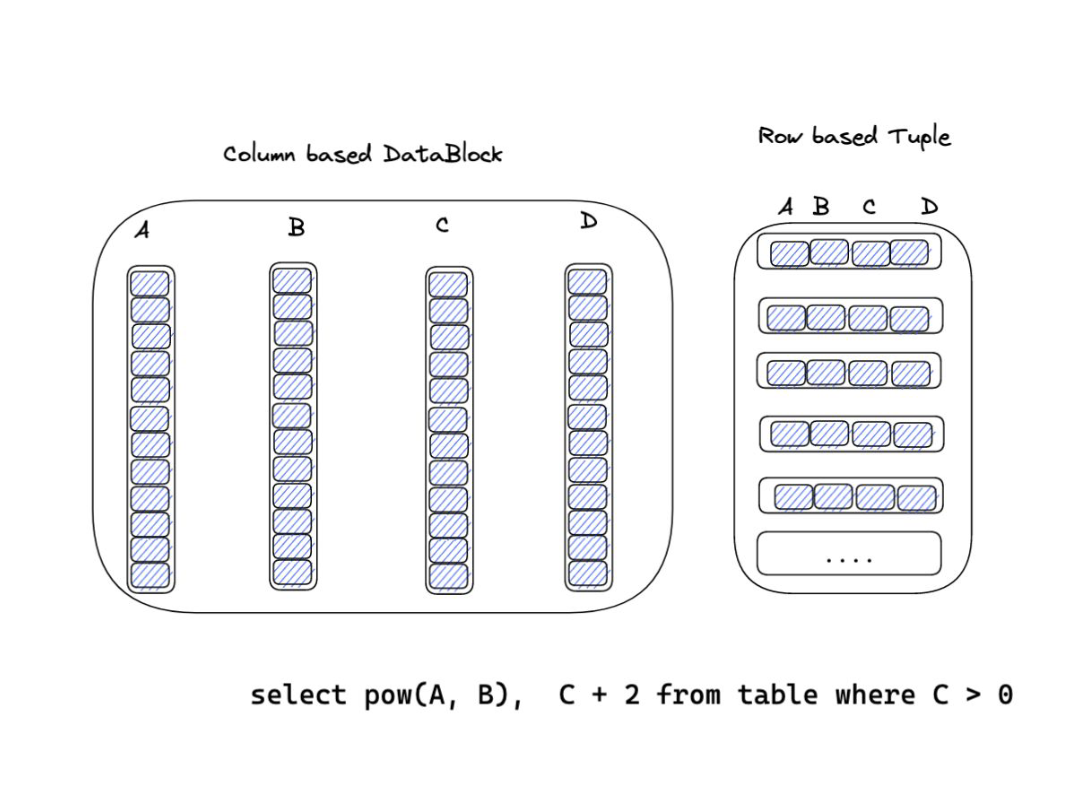

+解决了数据类型的问题,那么就该考虑数据存储时候的模型。行式存储和列式存储都属于流行的方案,当然,这往往取决于要面对什么样的查询任务。另外还有混合行式和列式存储的方案,但这并不在今天讨论的范畴之中。

+

对于 OLAP 系统,往往处理大量数据,更需要关注数据的吞吐量和执行效率,采用列式存储具有天然的优势。

+Apache Arrow 是一套通用、跨语言、高性能的列式数据内存格式规范,能够充分利用现代硬件的向量化执行能力。

+通过引入 Apache Arrow 作为标准的数据交换格式,可以有效提高各种大数据分析系统和应用程序之间的互操作性:

+Apache Arrow 现在有多种不同语言的实现,包括 C++、Java、Rust 等。

+值得关注的基于 Apache Arrow 的 Rust 实现的项目包括 pola-rs/polars、apache/arrow-datafusion,当然,还有 Databend 。

+Databend 是面向海量数据设计的云数仓,面向分析型工作负载进行设计,采用列式存储,使用 Apache Arrow 作为内存格式规范,并在此基础上设计开发类型系统。minibend 在这一点上将会与 Databend 保持一致。

+Databend 当前实现使用的是 arrow2 而非 arrow-rs ,主要有以下几个原因:

+Databend 从 arrow2 0.1 和 parquet2 0.1 发布 开始 考虑向 arrow2 迁移 ,十天左右完成 [commons] arrow -> arrow2 并在部分查询上获得性能提高。尽管从当时而言,切换到还处于早期的 arrow2 有些激进,但长远来看是利大于弊的。

+Data Source(数据源)是数据处理系统的重要部分,但通常只能依赖经验来谨慎处理。

+顾名思义,数据源就是数据的来源,倘若没有数据源,数据处理系统就像无根浮萍,自然也谈不上用武之地。

+数据源可以以不同的形态出现,比如各种各样格式的文件:CSV、JSON、Parquet 等;当然也可以是数据库,之前有很多朋友问过比如 Databend 能不能查询 MySQL 里面的数据(将 MySQL 作为数据源);也可以是内存对象,一个不那么典型的例子是 Databend 里面实现了用于测试向量化性能的 number 表。

+与不同数据源交互的处理逻辑也有所不同,为了能够更好接入不同数据源,查询引擎需要定义一套统一的接口,并确保能够返回符合预期的数据。对于查询引擎而言,主要关心两类数据:一类是 schema ,用来描述数据的结构,这可以帮助查询引擎对查询计划和表达式进行验证,但并不是所有数据都具有统一的/有效的结构,比如 JSON ;另一类就是具体的数据了,但考虑到查询引擎只需要处理关心的特定数据,所以应该有能力对数据进行过滤,只提取需要的列。

+ApacheParquet 是一种开源的、面向列的数据文件格式,用于高效的数据存储和检索。它提供了高效的数据压缩和编码方案,增强了处理大量复杂数据的性能。Parquet 支持多种语言,包括 Java、 C + + 、 Python 等等。.

+Parquet 受到 Google Dremel 格式启发,作为大数据领域的存储格式,被 iceberg 、hive 等各种系统使用。

+上图展示了 Parquet 文件的结构,Parquet 的存储模型主要由行组(Row Group)、列块(Column Chuck)、页(Page)组成。

+Databend 的底层存储格式为 Parquet ,过去其他格式的数据需要通过 Streaming Load 或者 Copy Into 等方式转换到 Databend 支持的 Parquet 格式。而在近期的设计和实现中,Databend 开始逐步实现对位于本地/远端的文件进行查询的支持。

+minibend 将会考虑优先从查询本地现有数据文件开始进行支持。首先是支持 Parquet 作为数据源,但为了方便浏览数据和审计查询结果,或许对 CSV 格式的支持应该提上日程。

+Databend 中同样包含读取 Parquet 文件作为数据源的代码。关于读取 Parquet 文件作为表的第一版实现可以参考 new table function read_parquet to read parquet files as a table 。

+在这个基础上,受 clickhouse-local 启发,@eastfisher 为 Databend 实现 databend-local,支持在不启动 Databend 集群的情况下查询本地文件。

+请查阅视频和 PPT 中的对应部分,或者查看 PR #40 | minibend: impl parquet data source 中的代码。

+在今天的内容中,我们简单介绍了类型系统和数据源的一些相关内容:

+当然,在这一期的代码时间,我们初步建立了 minibend 的基础,并支持使用 Parquet 文件作为数据源。

+下一期,我们将会进入到类型系统相关的部分,并进一步扩展到逻辑计划和表达式。

+这一次推荐两个博客给大家:

+一个是 风空之岛 ,@mwish 的技术博客,有关于 Parquet 的一个更详细的系列介绍,并且还有论文阅读的部分。

+另一个是 数据库内核月报 ,来自阿里云 PolarDB 数据库内核团队。

+ + + + + + + + +minibend ,一个从零开始、使用 Rust 构建的查询引擎。这里是 minibend 系列技术主题分享的第一期,来自 @PsiACE 。

+

++前排指路视频和 PPT 地址

+视频(哔哩哔哩):https://www.bilibili.com/video/BV1Ne4y1x7Cn

+PPT:https://databend-internals.psiace.me/minibend/ppt/minibend-001-basic-intro.pdf

+

minibend 是一款从零开始、使用 Rust 构建的查询引擎。

+查询引擎是数据库系统的一个重要组件,需要具备以下几点能力:

+通常我们会使用 SQL 也就是结构化查询语言进行交互。

+minibend 同时也是 Databend Internals,或者说 Databend 内幕大揭秘 这个手册的实战部分。Databend 内幕大揭秘 将会透过 Databend 的设计与实现,为你揭开面向云架构的现代数据库的面纱。

+

特别是在团队已经孵化出 Databend 这个现代开源云数仓的前提下,为什么还需要这样一个项目?

+先回到 Databend 内幕大揭秘 的初衷,设立这个项目是为了吸引更多人参与到 Databend 的学习、开发和生态建设中,所以目标受众定位在:

+但是,Databend 的更新迭代速度、代码量都意味着对刚开始接触 Rust 并尝试参与研发的新朋友会面临一个比较高的门槛。

+从现存的教程上看,或多或少存在一些问题:

+所以开启一个新的项目作为连接新开发者和 Databend 之间的纽带就成为一种自然的选择。

+++P.S. minibend 致力于解决这些问题,但可能很难完全解决,但至少,先开始运作起来。

+

首先,minibend 会提供视频、文章和代码三种材料。文章和代码将会同步到 Databend 内幕大揭秘 的 Repo 中,而视频则会发布到 Databend 的 B 站官方帐号下。欢迎大家持续关注。

+++Databend 内幕大揭秘:https://databend-internals.psiace.me/

+Databend(哔哩哔哩):https://space.bilibili.com/275673537

+

更新频率大概是每个月一到两期。内容上会包含必要的相关知识导读、设计和实现相关的说明、并进行回顾和展望。当然,也会不定期精选一部分论文摘要供大家进一步研讨和学习。

+在这个部分,我们不会深入数据库的细节,只是从部分组件的视角上进行观察。

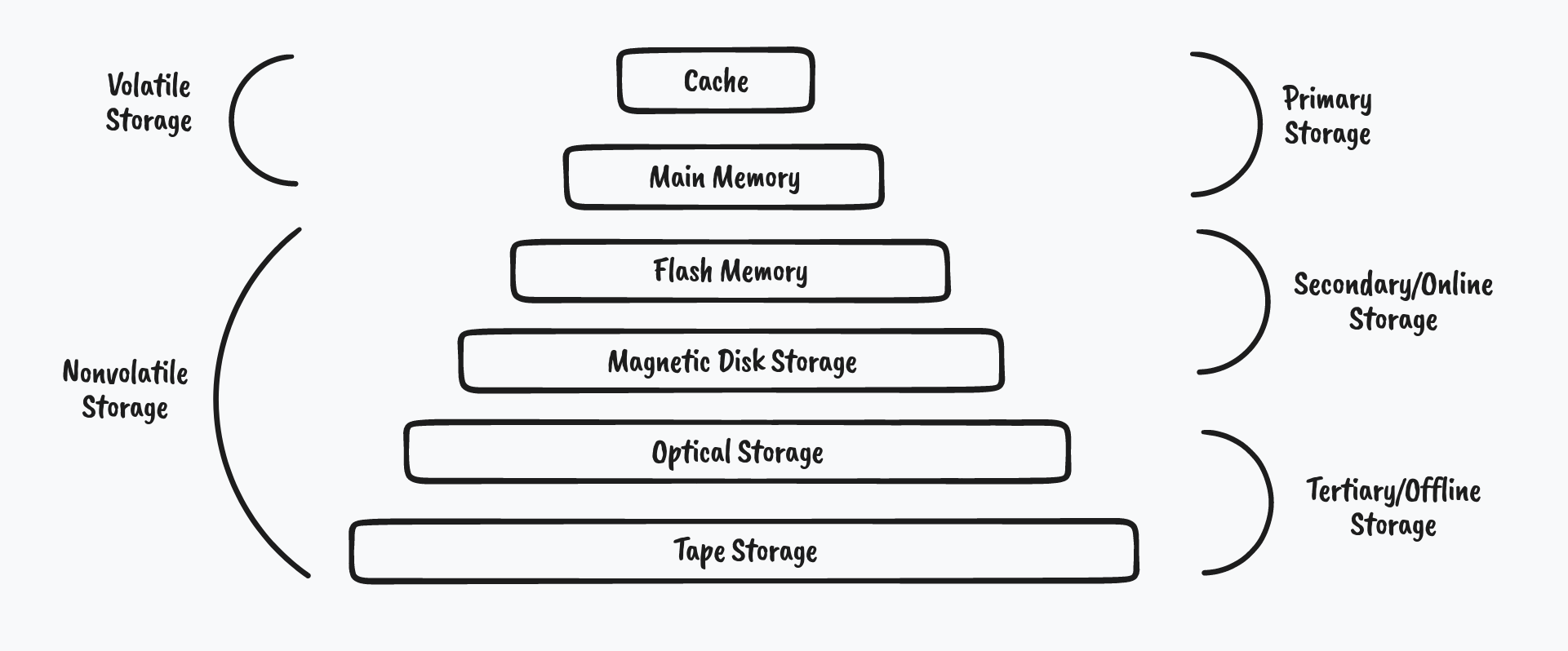

+存储解决的是两个问题,存在哪 以及 怎么存 。

+对于“怎么存”,不同背景的朋友可能会考虑到一些不同的细节,但大多数时候,可以想象到一个基本的模式是:数据以特定格式写入到某几类文件中,比如 Parquet 甚至 CSV 。

+但是“存在哪”呢?

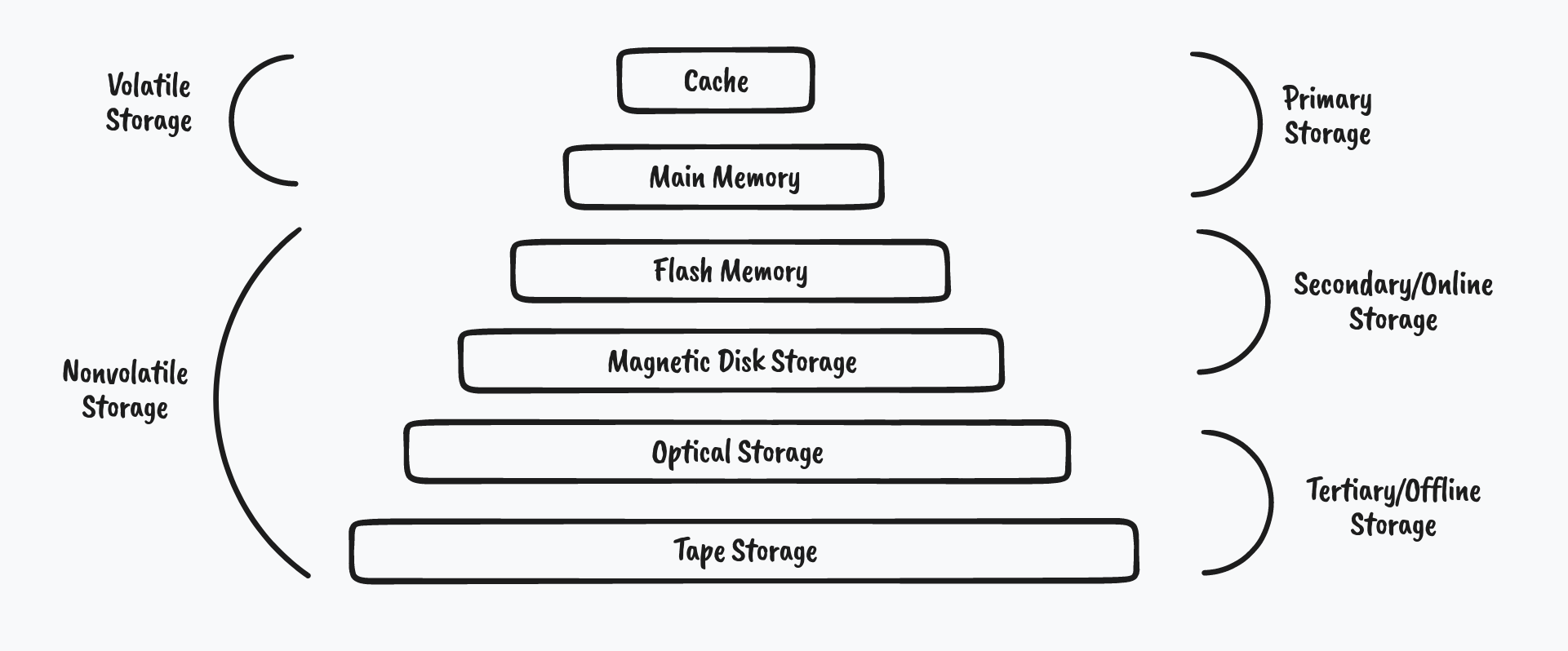

+

过去的一些存储方案更加关注上图所示的存储体系结构,将需要在线处理的数据存放在闪存和硬盘中,用于备份的数据放入光盘和磁带。

+云存储的兴起和网络带宽的不断提高带来了一些新的变化:云存储能够支持远程保存数据和文件,并通过网络连接进行访问。不仅可以节约拓展物理器件所带来的人力物力消耗,并能够提供更好的弹性以便于即时增减容量,还支持按需按量付费从而做到更好的成本管理与控制。

+Databend 早期的实现是包含一套分布式文件系统的,但到现在,存储的重心完全转移到云厂商提供(AWS S3, Azure Blob 等)或者自托管(MinIO 等)的云存储之上。

+尽管云存储越来越重要,但原有的经验和见解依然有效,我们仍然可以使用缓存和并行技术来改善性能,利用冗余来提高可靠性。

+引入索引的好处在于加快数据查询的速度,而缺点则在于构建和维护索引同样需要付出代价。

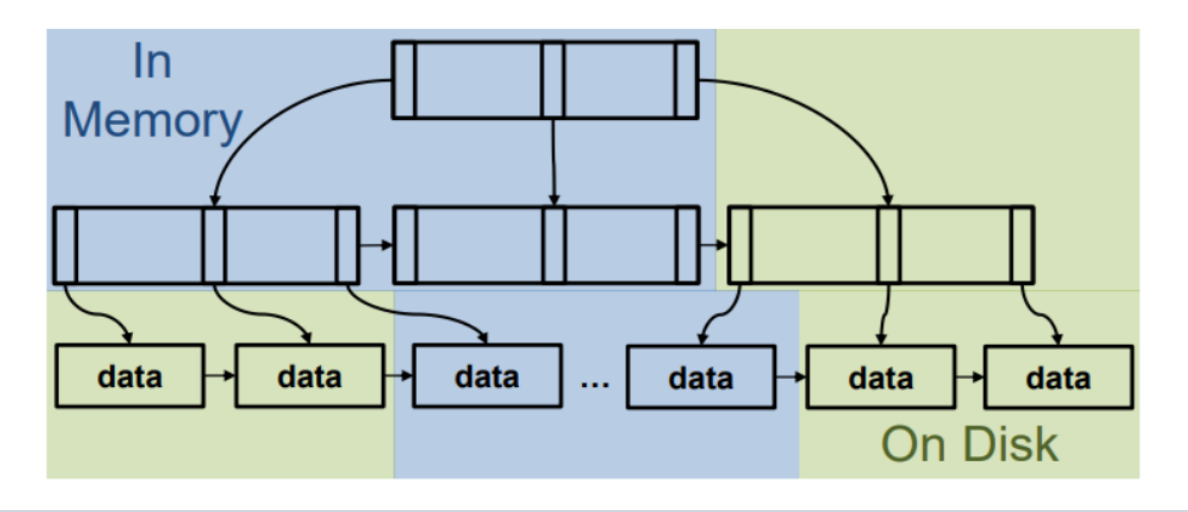

+

不同的索引可以针对不同的场景提供优化,B Tree 能够加速范围查询,而等值查询就可以使用 Hash 索引,BitMap(或者说更常用的 Bloom 索引)可以方便判断数据是否存在。

+Databend 的索引无需人为创建,由部署的实例自行维护。同时也采用了像 Xor 索引 这样的新技术来进一步加速查询并提高空间利用率。

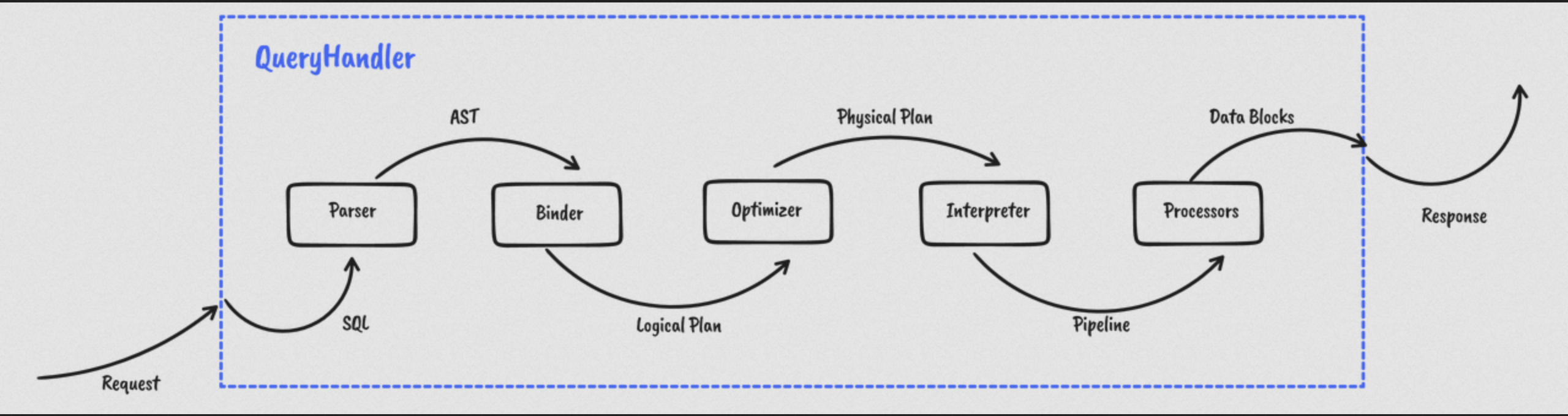

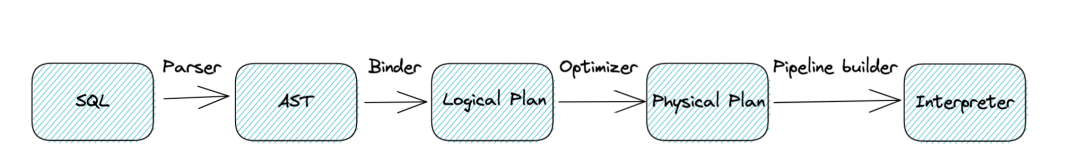

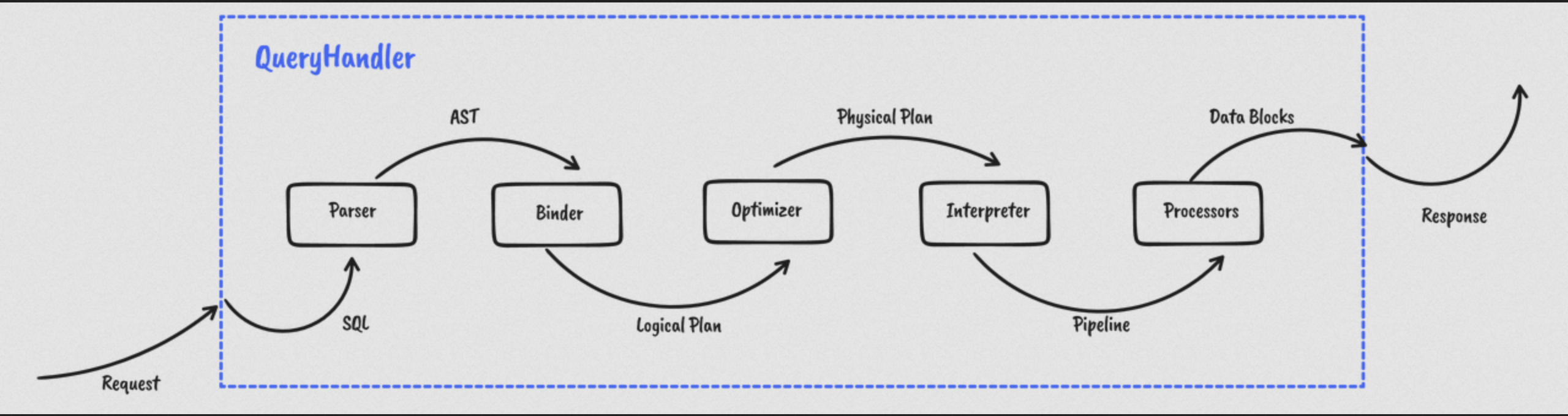

+尽管有各种各样的查询引擎,但具体到查询执行的环节大同小异,这里以 Databend 为例,简单讲一下过程。

+

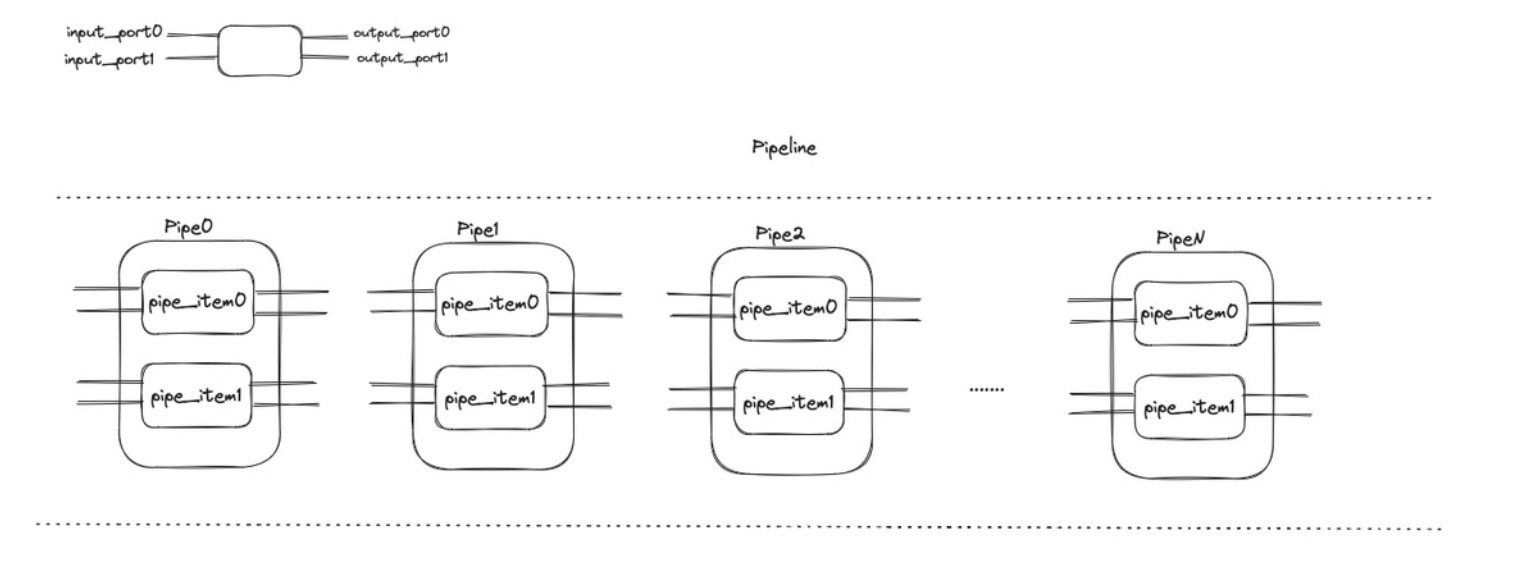

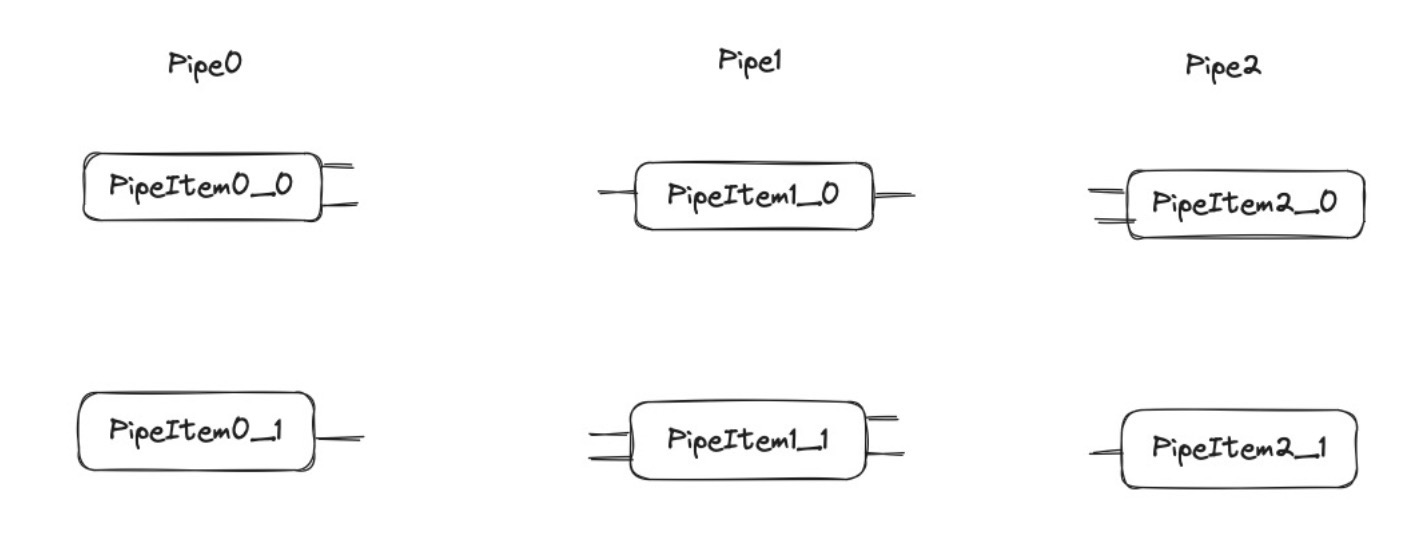

那么近年来新兴数据库大多受到 Morsel-Driven Parallelism 这篇论文的启发,在运行时确定任务的并行度,按流水线的方式执行操作,并通过调度策略来尽量保证数据的本地化,在实现 load banlance 的同时最小化跨域数据访问。

+同时,引入列式存储和向量化执行的技术,可以避免不必要的缓存和 I/O 资源浪费,同时,节约处理数据时需要传递的数据量,为进一步优化提供更多空间。

+查询执行的路径并非一成不变,不同的执行计划在不同场景下性能也存在差异,如何为查询选择合适的计划就是查询优化需要关注的内容。

+下面的图片展现的是一种典型的查询优化,对 JOIN 进行重排。

+

目前有两种主要的查询优化方案,一种是基于关系代数和算法的等价优化方案,一种是基于评估成本的优化方案。根据命名,不难看出优化的灵感来源和这两种方案在优化上的取舍。

+那么如何进行查询优化呢?查询优化通常包含以下四个步骤:

+Databend 引入了基于规则的 Cascades 优化器,通过自顶向下探索、模式匹配以及记忆化来提供更好的查询优化能力。

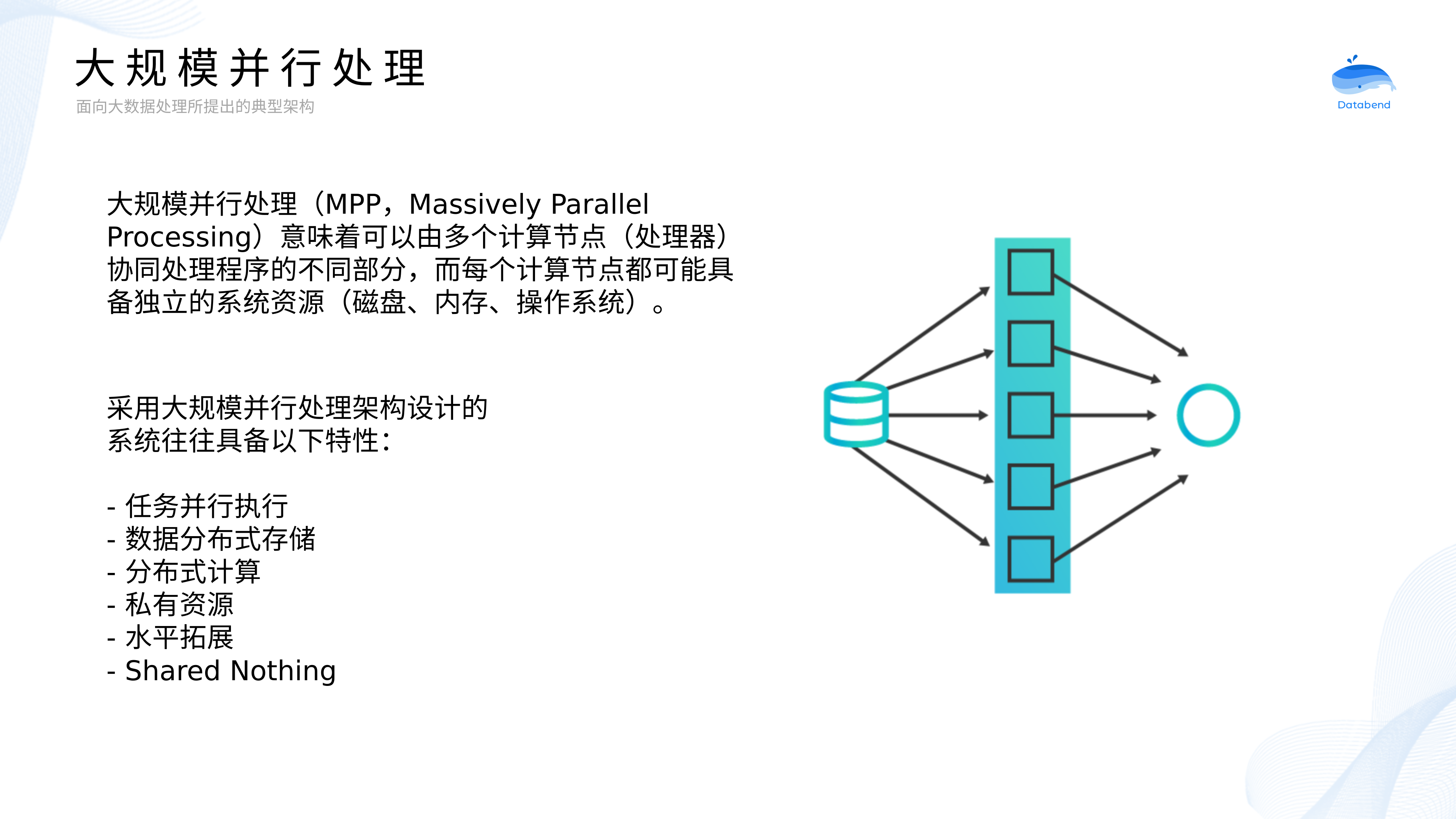

+大规模并行处理是大数据计算引擎的一个重要特性,可以提供高吞吐、低时延的计算能力。那么,当我们在讨论大规模并行处理时,究竟在讨论什么?

+

大规模并行处理(MPP,Massively Parallel Processing)意味着可以由多个计算节点(处理器)协同处理程序的不同部分,而每个计算节点都可能具备独立的系统资源(磁盘、内存、操作系统)。

+计算节点将工作拆分成易于管理、调度和执行的任务执行,通过添加额外的计算节点可以完成水平拓展。随着计算节点数目的增加,对数据的查询处理速度就越快,从而减少大数据集上处理复杂查询所需的时间。

+在近些年,MPP 和分布式设计往往会同时出现在同一套系统中。

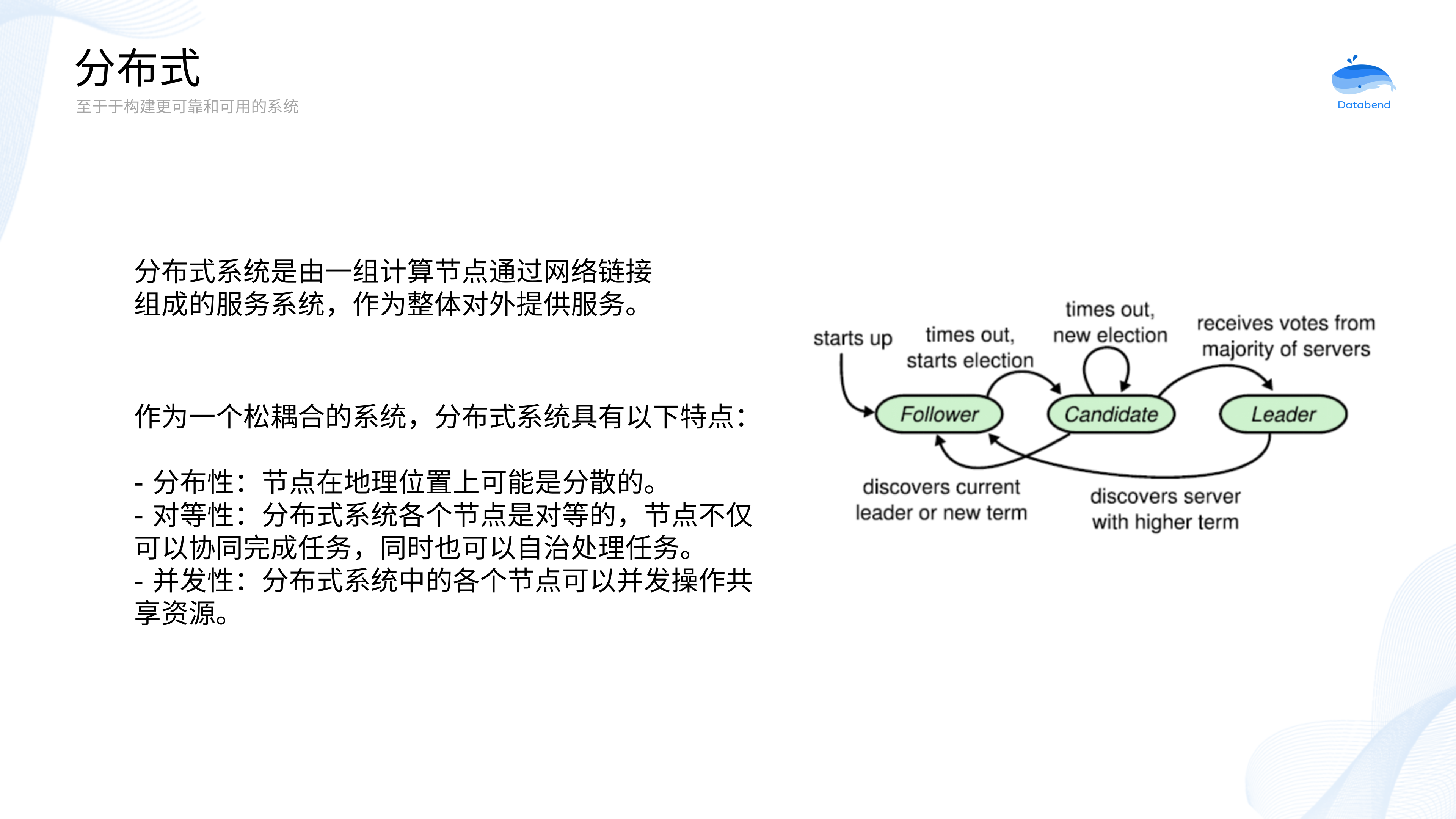

+

从某种视角上看,分布式系统与 MPP 系统有着惊人的相似。比如:通过网络连接、对外作为整体提供服务、计算节点拥有资源等。但是这两种架构仍然会有一些不同。

+刚刚介绍了数据库相关的一些基本概念,现在让我们将目光转向 Rust ,来一同了解这个正在走向流行的编程语言。

+

Rust 官方宣传语是:Rust 是一门赋予每个人构建可靠且高效软件能力的语言,现在距离它第一个版本发布也已经过去10年。

+Rust 没有运行时和垃圾回收,速度快且内存利用率高,几乎可以与 C 和 C++ 竞争。

+Rust 的类型系统和所有权模型为内存安全和线程安全提供保障,在编译期就能够消除各种各样的错误。

+特别值得一提的是,Rust 工具链内置很多实用工具,可以切实改善生产力:包管理器、构建工具、格式化程序、用于代码审计的 Clippy 等等。

+#[allow(dead_code)]

+// Functions

+// `i32` is the type for 32-bit signed integers

+fn add2(x: i32, y: i32) -> i32 {

+ // Implicit return (no semicolon)

+ x + y

+}

+上面函数是两个 32 位整数相加,返回值也是一个 32 位整数。值得注意的是,我们需要标注返回值类型,而函数体中的 x + y 是一种隐式返回,所以不需要添加 return 关键字,当然,也不需要在末尾添加分号。只添加末尾分号的话,则会将其视为普通语句执行,就没有返回值了(报错)。

// This is the main function

+fn main() {

+ // Statements here are executed when the compiled binary is called

+

+ // Print text to the console

+ println!("Hello World!");

+}

+经典的 Hello World 程序,大家应该会感觉到熟悉。main 函数也是 Rust 程序的入口点。通过调用 println! 这个宏,可以输出文本到终端。

// Struct

+struct Point {

+ x: i32,

+ y: i32,

+}

+

+// A struct with unnamed fields, called a ‘tuple struct’

+struct Point2(i32, i32);

+

+// Enum with fields

+enum OptionalI32 {

+ AnI32(i32),

+ Nothing,

+}

+

+// Generics //

+struct Foo<T> { bar: T }

+

+// Traits (known as interfaces or typeclasses in other languages) //

+trait Frobnicate<T> {

+ fn frobnicate(self) -> Option<T>;

+}

+

+impl<T> Frobnicate<T> for Foo<T> {

+ fn frobnicate(self) -> Option<T> {

+ Some(self.bar)

+ }

+}

+除了基本的字符串、整数、浮点数、布尔类型之外,Rust 还支持结构体和枚举类型,代码片段提供了一个基本的例子。为这些类型可以实现特定的方法,以支持各种各样的操作,通用的接口可以使用 trait 关键字进行定义。

let foo = OptionalI32::AnI32(1);

+match foo {

+ OptionalI32::AnI32(n) => println!("it’s an i32: {}", n),

+ OptionalI32::Nothing => println!("it’s nothing!"),

+}

+

+// Advanced pattern matching

+struct FooBar { x: i32, y: OptionalI32 }

+let bar = FooBar { x: 15, y: OptionalI32::AnI32(32) };

+

+match bar {

+ FooBar { x: 0, y: OptionalI32::AnI32(0) } =>

+ println!("The numbers are zero!"),

+ FooBar { x: n, y: OptionalI32::AnI32(m) } if n == m =>

+ println!("The numbers are the same"),

+ FooBar { x: n, y: OptionalI32::AnI32(m) } =>

+ println!("Different numbers: {} {}", n, m),

+ FooBar { x: _, y: OptionalI32::Nothing } =>

+ println!("The second number is Nothing!"),

+}

+模式是 Rust 中特殊的语法,它用来匹配类型中的结构,看起来有点像 switch,但要更加强大和简洁。无论类型是简单还是复杂,结合使用模式和 match 表达式以及其他结构可以提供更多对程序控制流的支配权。通过将一些值与模式相比较来使用它。如果模式匹配这些值,就可以对值的部分进行相应处理。

// for and ranges

+for i in 0u32..10 {

+ print!("{} ", i);

+}

+println!("");

+// prints `0 1 2 3 4 5 6 7 8 9 `

+

+// `if` as expression

+let value = if true {

+ "good"

+} else {

+ "bad"

+};

+

+// `while` loop

+while 1 == 1 {

+ println!("The universe is operating normally.");

+ // break statement gets out of the while loop.

+ // It avoids useless iterations.

+ break

+}

+

+// Infinite loop

+loop {

+ println!("Hello!");

+ // break statement gets out of the loop

+ break

+}

+上面是一些常见的控制流语法,for 循环和范围迭代看起来和其他语言很相似;而通过 let - if 语句,可以轻松将 if 当作表达式来使用;当然,Rust 同样支持 while 循环和无限 loop 循环。

// Owned pointer – only one thing can ‘own’ this pointer at a time

+// This means that when the `Box` leaves its scope, it can be automatically deallocated safely.

+let mut mine: Box<i32> = Box::new(3);

+*mine = 5; // dereference

+// Here, `now_its_mine` takes ownership of `mine`. In other words, `mine` is moved.

+let mut now_its_mine = mine;

+*now_its_mine += 2;

+

+println!("{}", now_its_mine); // 7

+// println!("{}", mine); // this would not compile because `now_its_mine` now owns the pointer

+Owned Pointer,一次只能有一个对象“拥有”此指针,这意味着当 Box 离开其作用域时,它可以安全地自动释放。

// Reference – an immutable pointer that refers to other data

+// When a reference is taken to a value, we say that the value has been ‘borrowed’.

+// While a value is borrowed immutably, it cannot be mutated or moved.

+// A borrow is active until the last use of the borrowing variable.

+let mut var = 4;

+var = 3;

+let ref_var: &i32 = &var;

+

+println!("{}", var); // Unlike `mine`, `var` can still be used

+println!("{}", *ref_var);

+// var = 5; // this would not compile because `var` is borrowed

+// *ref_var = 6; // this would not either, because `ref_var` is an immutable reference

+ref_var; // no-op, but counts as a use and keeps the borrow active

+var = 2; // ref_var is no longer used after the line above, so the borrow has ended

+Reference – 引用其他数据的不可变指针。当引用某个值时,我们称该值已被 “借用” 。当一个值被不可变借用时,它不能被修改或移动。借用直到在最后一次使用借用变量之前会一直处于活跃状态。

+// Mutable reference

+// While a value is mutably borrowed, it cannot be accessed at all.

+let mut var2 = 4;

+let ref_var2: &mut i32 = &mut var2;

+*ref_var2 += 2; // '*' is used to point to the mutably borrowed var2

+

+println!("{}", *ref_var2); // 6 , // var2 would not compile.

+// ref_var2 is of type &mut i32, so stores a reference to an i32, not the value.

+// var2 = 2; // this would not compile because `var2` is borrowed.

+ref_var2; // no-op, but counts as a use and keeps the borrow active until here

+可变引用,如果你有一个对该变量的可变引用,你就不能再创建对该变量的引用。

+上面的这些 Rust 片段节选自 Learn X in Y minutes ,只进行了一些粗浅的介绍。

+如果想要进一步学习,建议查阅以下资料:

+首先我们介绍了 minibend 这个系列课程,一方面,这会是一个从零开始、使用 Rust 构建的查询引擎;另一方面,它会参考 Databend 的设计,并致力于降低数据库内核开发的门槛。

+而在数据库相关基础知识的部分,云存储为现代数据库设计带来了一些新变化,而不同的索引又可以为不同的查询场景带来性能优化,接着是查询执行和查询优化的相关知识,以及对大规模并行处理和分布式技术的介绍。

+Rust 不完全指南里,从函数、类型、模式匹配、控制流、内存安全与指针进行了一个简单的介绍,为阅读 Rust 代码提供了一个简单的基础。

+下一期,我们将会介绍 Apache Arrow - 一种列式存储的内存格式规范,以及查询引擎中的类型系统,然后试着写一些关于数据源的代码。

+

本期课程推荐两本书给大家:

+一本是 The Rust Programming Language ,这是 rust 官方出品的 Rust 书籍,一般被称作 the book 。

+另一本是 How Query Engines Work ,Andy 同时也是 Datafusion 和 Ballista 的作者,不过这本书使用的是 kotlin 。

+ + + + + + + + +本篇文章是对 Databend 在 RustChinaConf 2022 上演讲的一个全文回顾。涉及「Databend 的架构和设计」以及「Databend 团队的 Rust 之旅」。+

那么,在进入正题之前,让我们先来回答这样一个问题:“什么是 Databend”?

+

官方的说法是:Databend 是一个使用 Rust 研发、开源、完全面向云架构的新式数仓。

+借用当下大数据分析领域最流行的两个数据库产品打个比方:Databend 就像是开源的 Snowflake 或者说云原生的 Clickhouse 。

+作为新式数仓,Databend 有哪些基本特性呢?

+

TIME TRIVAL,可以轻松回滚到任意时间节点。刚刚介绍了 Databend 的一些基本信息,接下来,让我们一起走进 Databend 的架构和设计。看看一个存算分离的云原生数仓该是什么样子。

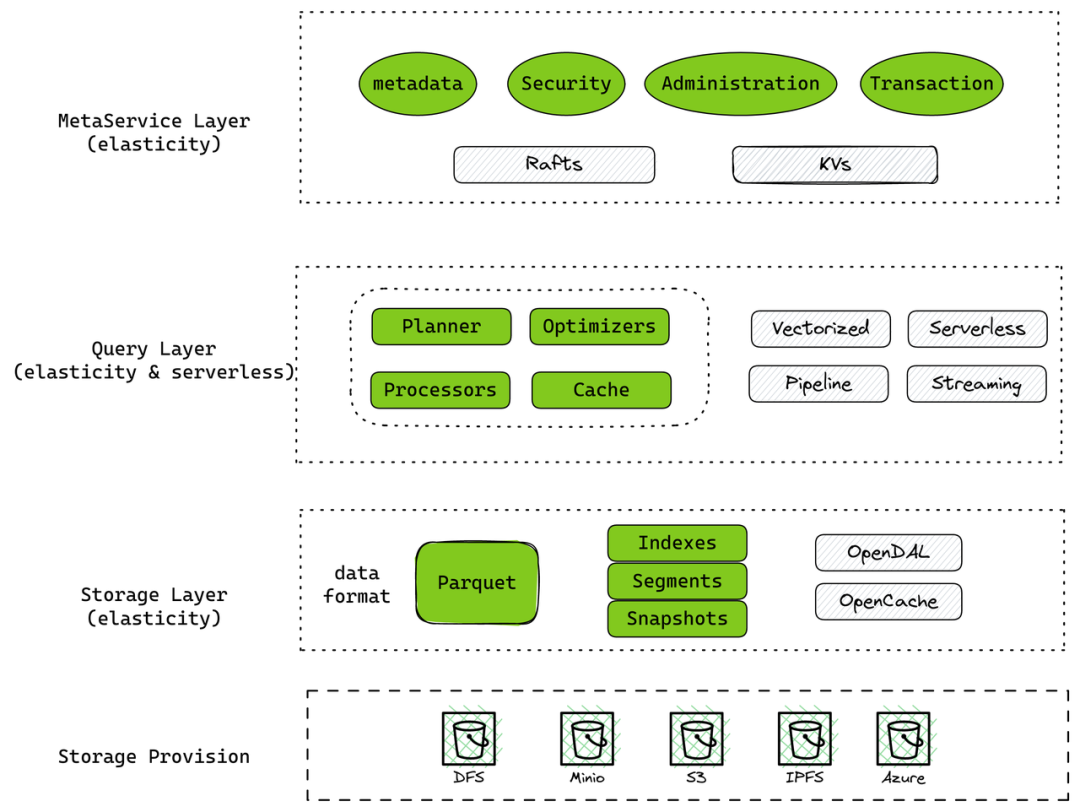

+

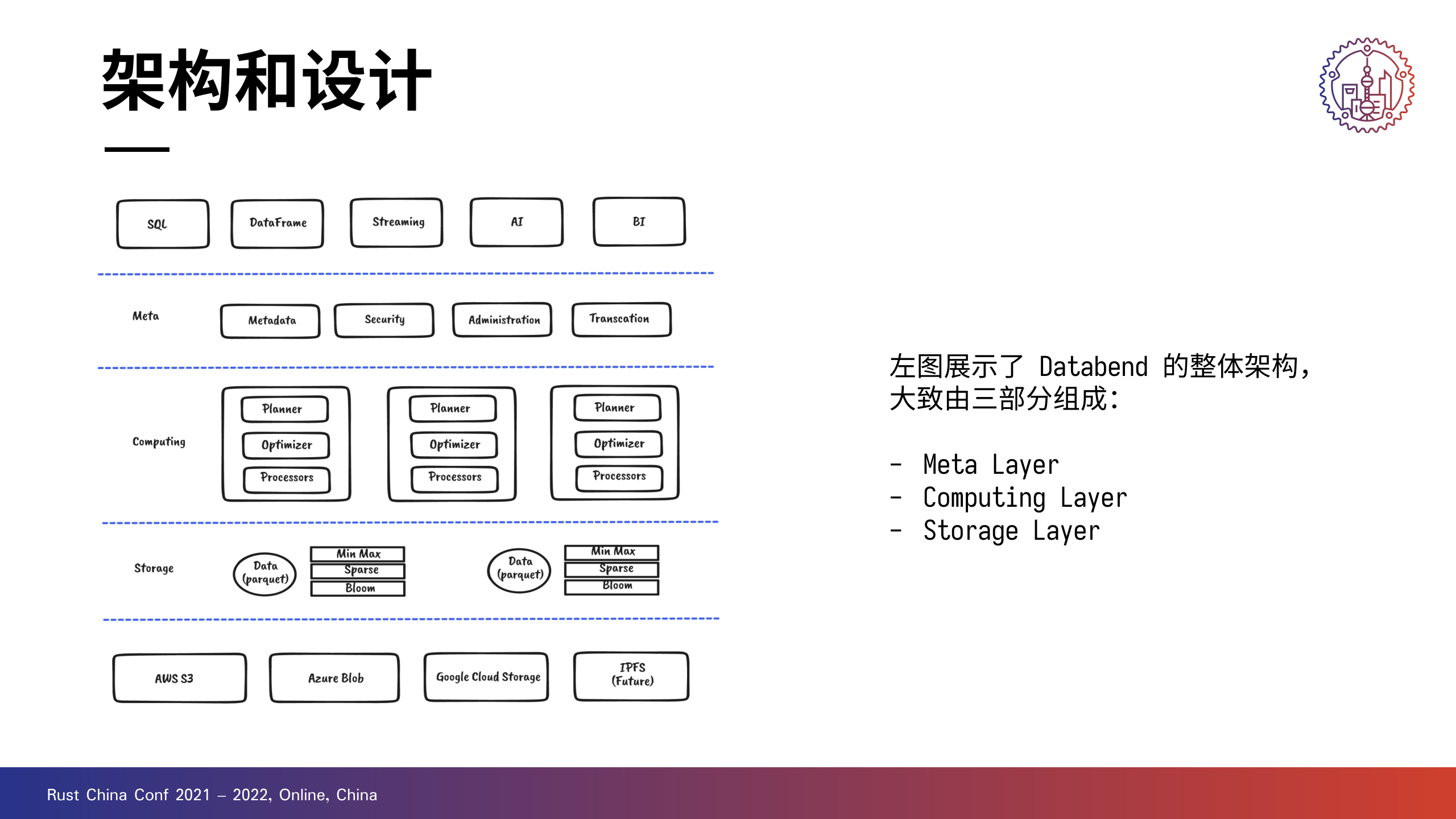

右边是 Databend 的一个架构图。

+最上一层对接 AI、BI 等应用,最下一层打通 S3、GCS、IPFS 等存储系统。中间三层则是 Databend 的主体部分。

+Databend 可以分成 Meta、Computing 和 Storage 三层,也就是元数据、计算和存储。

+说是存储层,其实叫做数据访问层更贴切一些。

+

Meta 是一个多租户、高可用的分布式 key-value 存储服务,具备事务能力。

+它会负责管理元数据,像索引和集群的一些信息;Meta 还具备租户管理的能力,包括权限管理以及配额使用统计。

+当然,安全相关的部分也由 Meta 承担,比如用户登录认证。

+

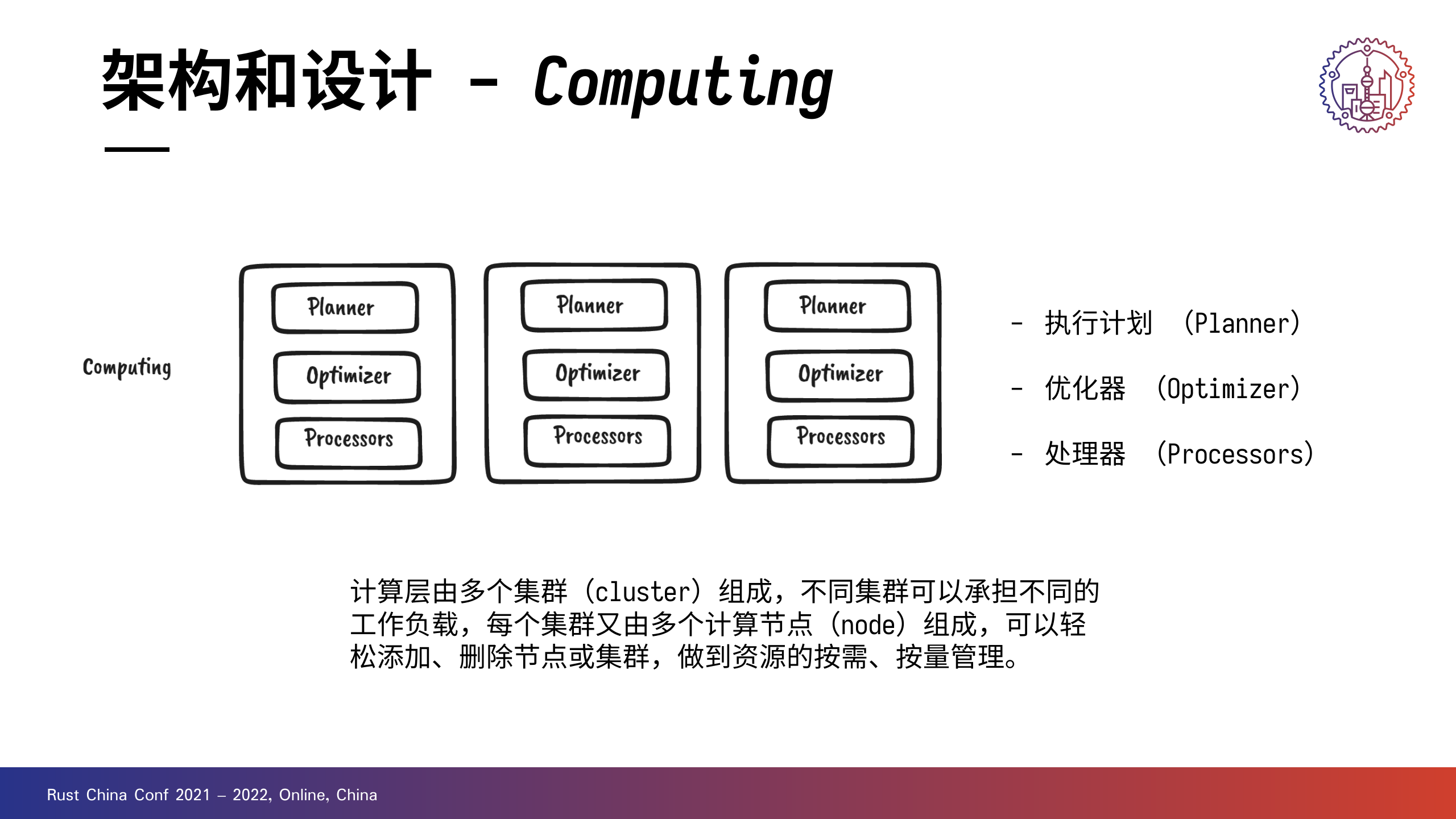

计算层可以由多个集群组成,不同集群可以承担不同的工作负载。每个集群又可以由多个计算节点(node)组成。

+计算层中的核心组件有三个:

+

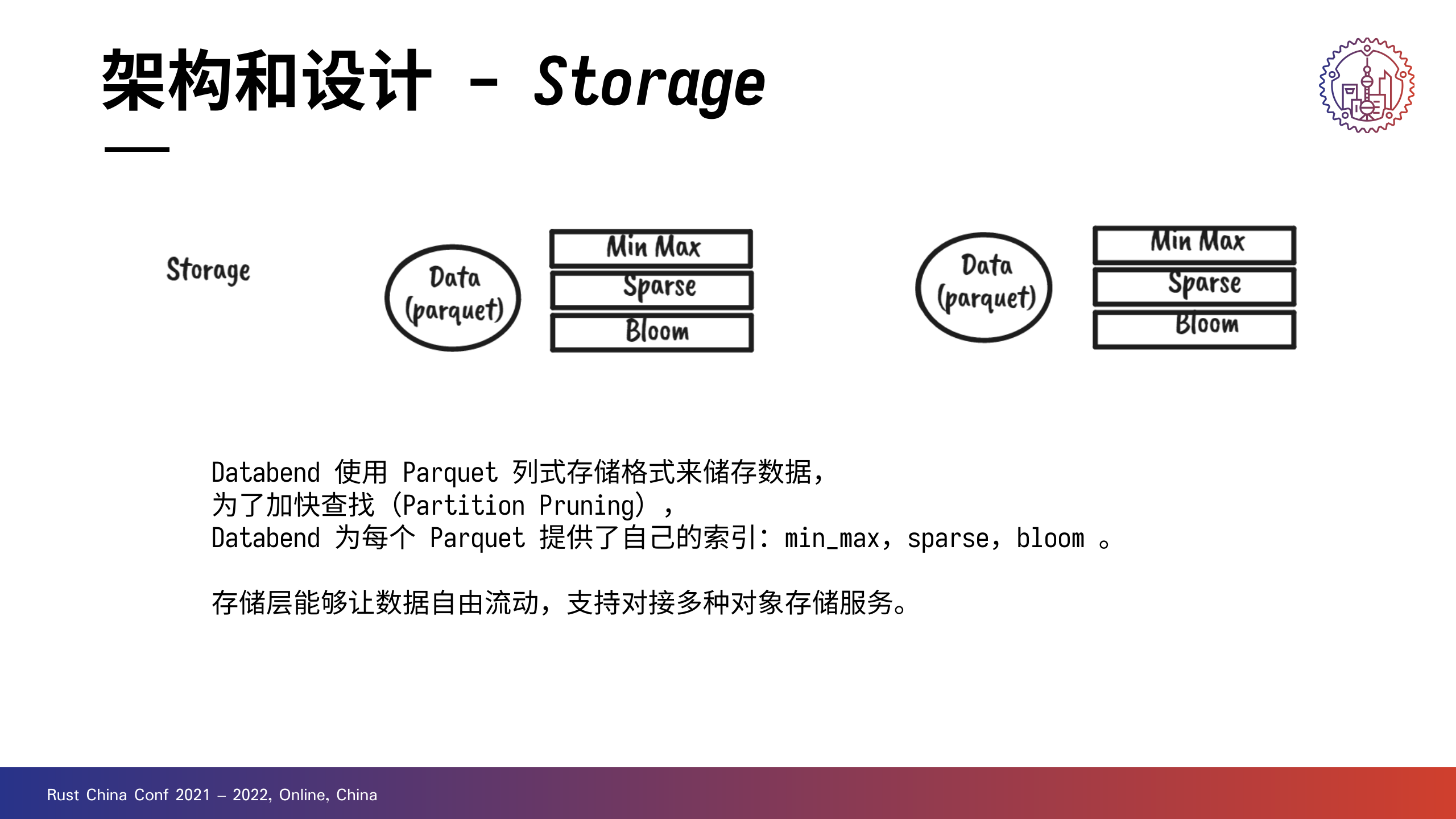

Databend 使用 Parquet 格式储存数据,为了加快查找(Partition Pruning),Databend 为每个 Parquet 提供了自己的索引:min_max,bloom 。这一部分工作是放在存储层完成的。

+前面其实有提到,存储层的另一个说法是数据访问层。

+一方面,它支持对接多种对象存储服务,像 AWS S3 和 Azure Blob,做到让数据自由流动。当然也支持在本地文件系统做测试,但是没有做专门的性能优化。

+另一方面,存储层也支持挂载多种 catalog,在社区小伙伴的帮助下,Databend 完成了 Hive 引擎的对接,支持进行一些简单的查询。

+“存算分离”、“云原生”对于新式数仓而言,只能算是基本特性。除了卯足劲大搞性能优化之外,还有没有其他值得关注的地方呢?让我们一起来看一下。

+好的产品是一定会强调用户体验的,Databend 作为一款云数仓产品,自然要关注查询体验。

+那么,在新的 parser 和 planner 中,Databend 引入了语义检查的环节,在查询编译过程中就可以拦截大部分错误。

+

右图展示的正是两类语义错误,一类是使用了不存在的 Column ,一类是 Column 具有歧义。

+其实新 planner 除了更加友好的查询体验之外,还为支持复杂查询打下了扎实的基础。那么 Databend 现在可以支持多种 Join 和关联子查询,感兴趣的小伙伴可以体验一下。

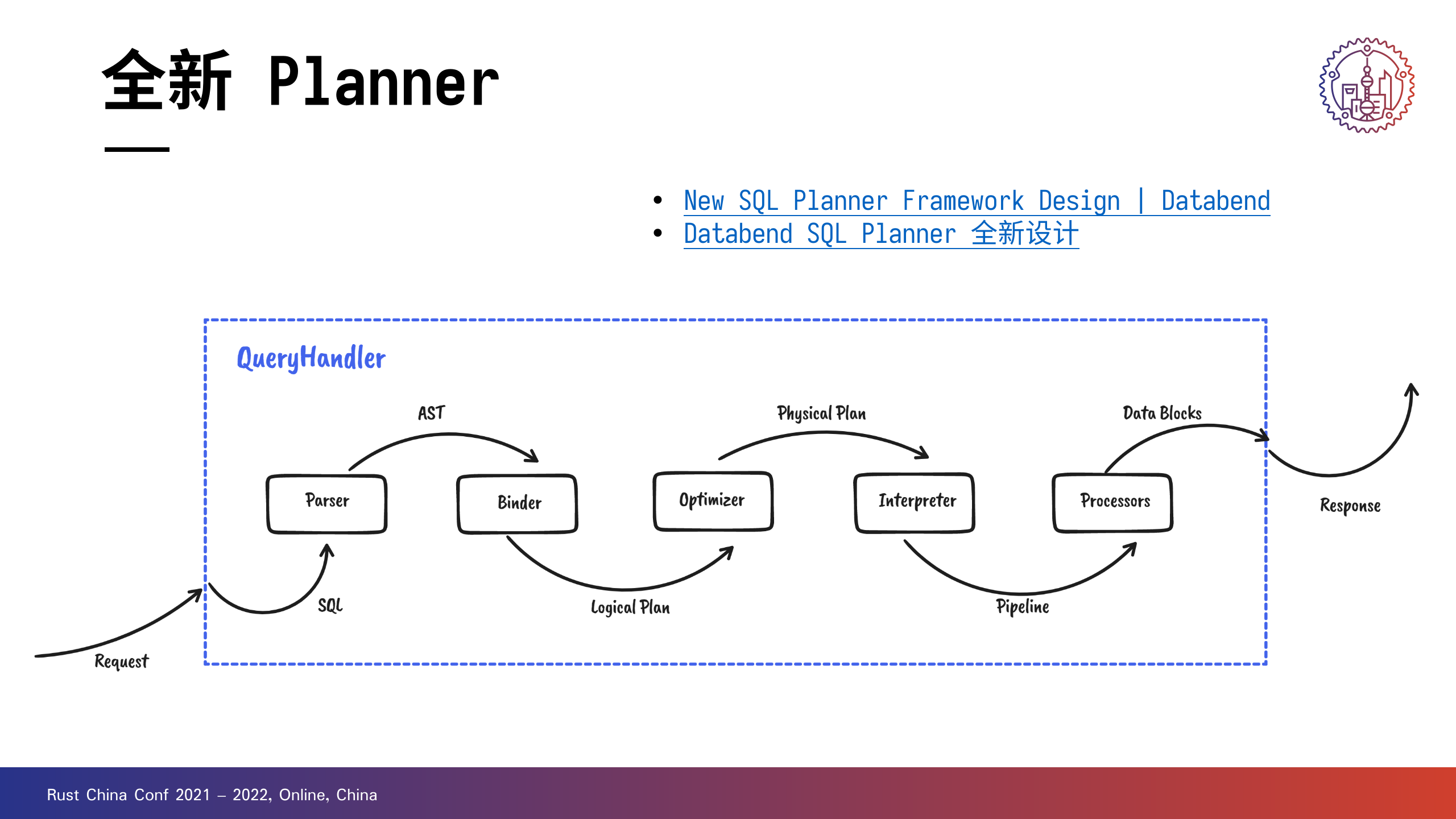

+在引入新 Planner 之后,计算层的架构得到进一步的划分,当一个查询请求进来以后,会经过以下处理:

+

对新 plannere 感兴趣的朋友可以看一下下面列出的内容。

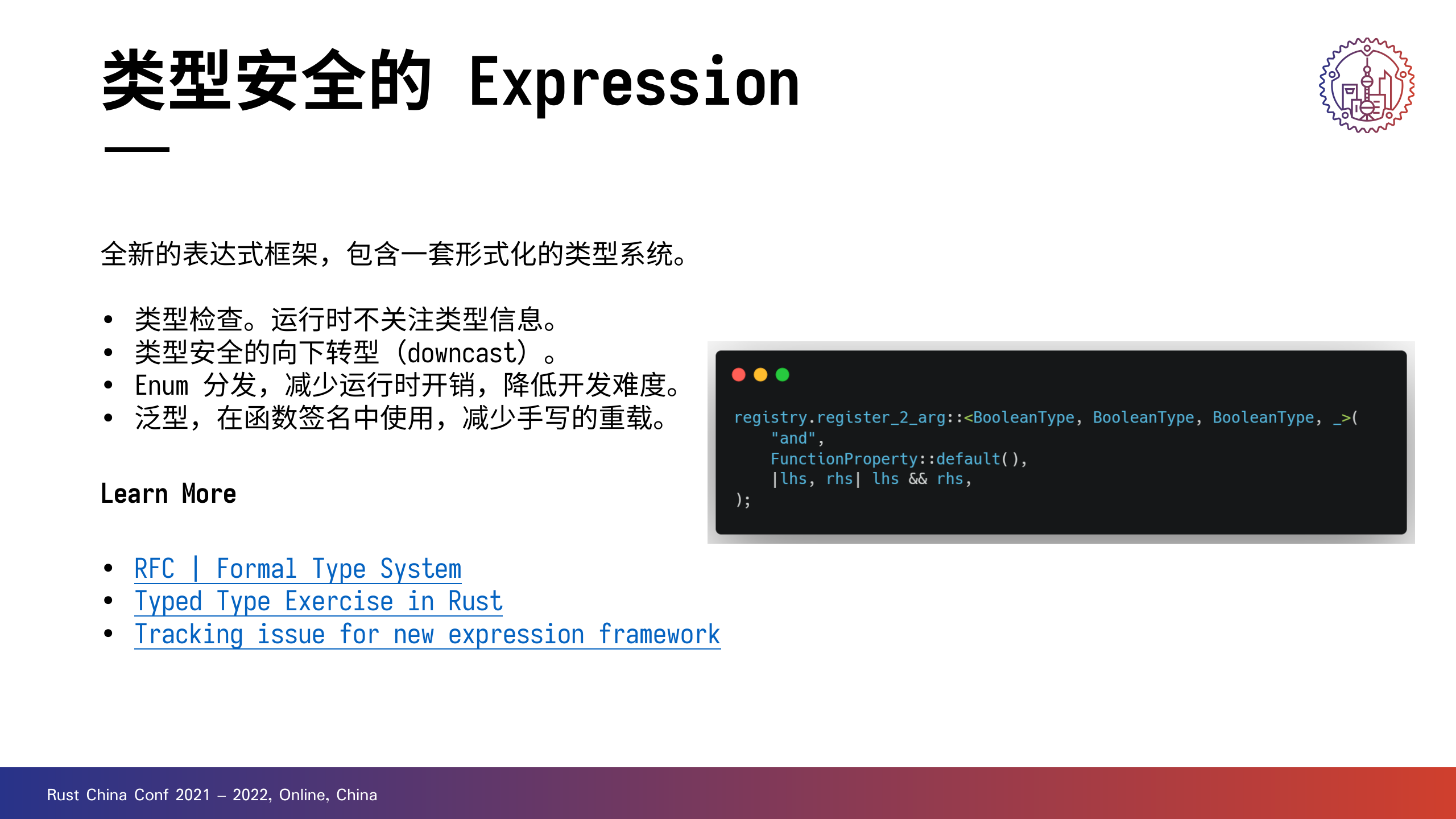

+ +Databend 最近正在研发一套全新的表达式框架,其中包含一套形式化的类型系统,算是使用 Rust 自定义类型系统的最佳范例。

+

通过引入形式化方法,可以提高设计的可靠性和健壮性。对应到新表达式框架中:

+一方面,引入类型检查,可以拦截 SQL 编译阶段的所有类型错误,运行时不再需要关注类型信息。

+另一方面,实现了类型安全的向下转型(downcast),得益于 Rust 的类型系统,只要函数能够正常编译就不需要担心类型转换的问题。

+当然,性能和开发体验也是新表达式框架非常关心的部分:

+通过 Enum 进行静态分发,可以减少运行时开销,降低开发难度。

+另外,在函数签名中大量使用泛型,减少手写的重载。

+图的右侧给出了一个例子:用几行代码即可定义一个快速、类型安全、自动向下转型并支持向量化的二元函数。

+如果对使用 Rust 自定义类型系统感兴趣,可以阅读下面列出的材料。我们也正在积极推进这套表达式框架的开发和迁移工作,欢迎体验。

+作为用 Rust 开发的大型项目,Databend 在一年半的迭代中也积累了一些经验,借这个机会和大家分享一下。

+Databend 选择 Rust ,其实有很多原因:极客精神、健壮性等。

+团队成员老 C 也分享了他的一个想法:

+参见:周刊(第7期):一个C系程序员的Rust初体验 - codedump的网络日志

+

这里给大家分享一下 Databend 的快速迭代方法论。

+

Databend 的单元测试组织形式有别于一般的 Rust 项目,像上图左侧展示的这样,针对性地禁用了 src 目录下的 doctest 和 test 。

+主要的优点就是节省构建测试需要的时间。

+一方面,减少遍历和检查的环节,并削减要构建的 test 目标;另一方面,如果不修改 src ,添加新单元测试时只需要编译对应的 test 目标。

+当然这样做也有缺点:不利于软件设计上的分层,需要引入编码规范并且更加依赖开发者的主动维护。

+上图右侧是 goldenfiles 的一个测试文件片段。Golden Files 测试是一种常用的测试手段,相当于是一类快照测试。我们计划大量使用它来替代手写断言。一方面变更测试文件无需重新编译,另一方面提供自动生成的办法可以减轻写测试的痛苦。

+测试相关的一些阅读材料见下:

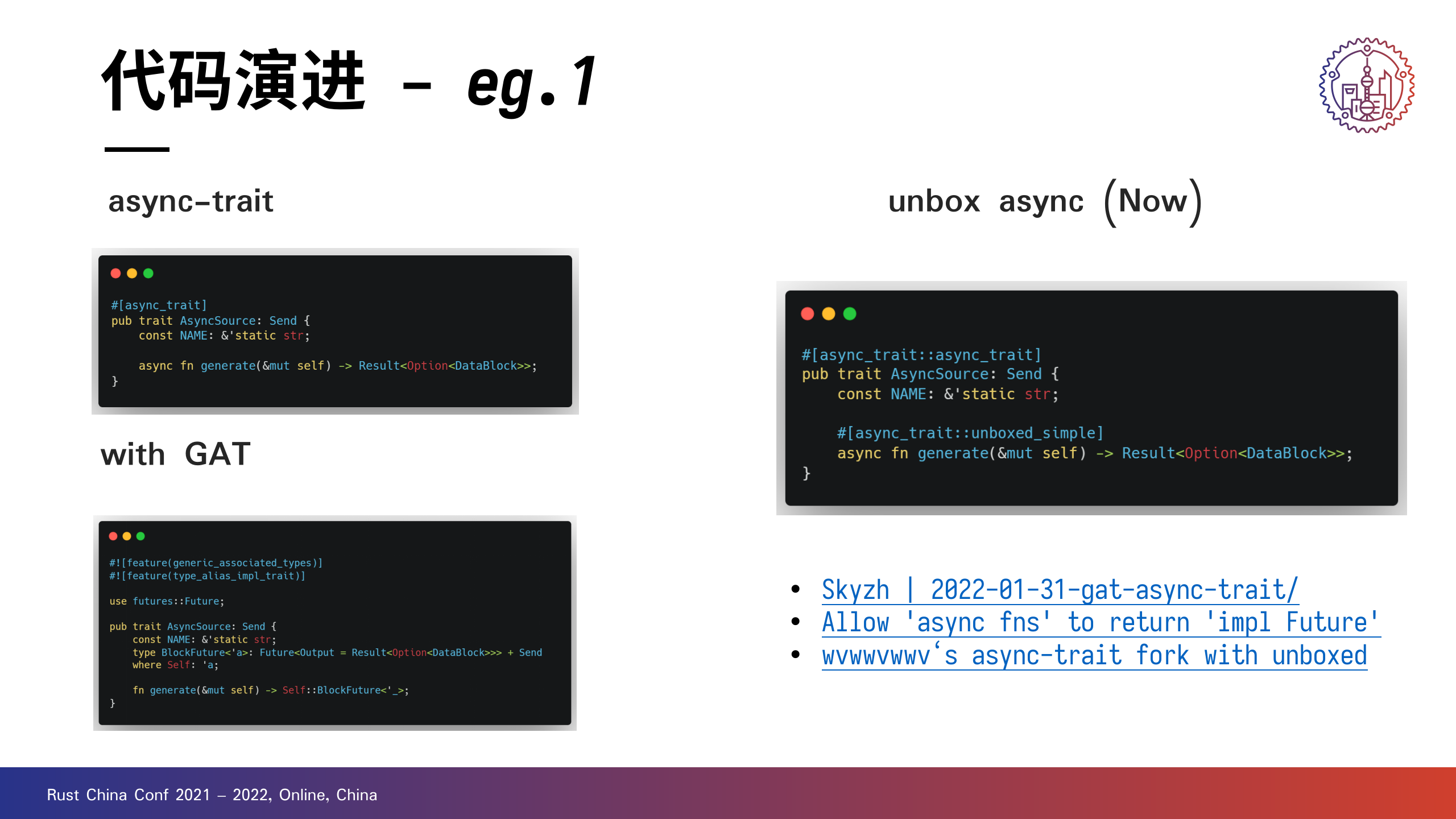

+重构要兼顾性能和开发人员的心智负担,这里分享 Databend 代码演进的两个例子。

+eg.1

+

第一个例子是大家编写异步代码时常用的 async trait ,用起来很方便,就像左上角的例子,但是有一些小缺点:

+一是动态调度会带来开销,比较难做一些编译器的优化。 +二是内存分配也会带来开销,每次调用都需要在堆上新建一个对象。如果是经常调用的函数,就会对程序的性能造成比较大的影响。

+那么有没有解决办法呢?左下角的例子中使用泛型关联类型对它进行了改写,虽然避免了开销,但是实现起来还是相对复杂一些。

+右上角是使用 SAP 的同学作的 async-trait 分叉,只需要加一个 unboxed_simple 就可以做到同样的效果,省心省力。

eg.2

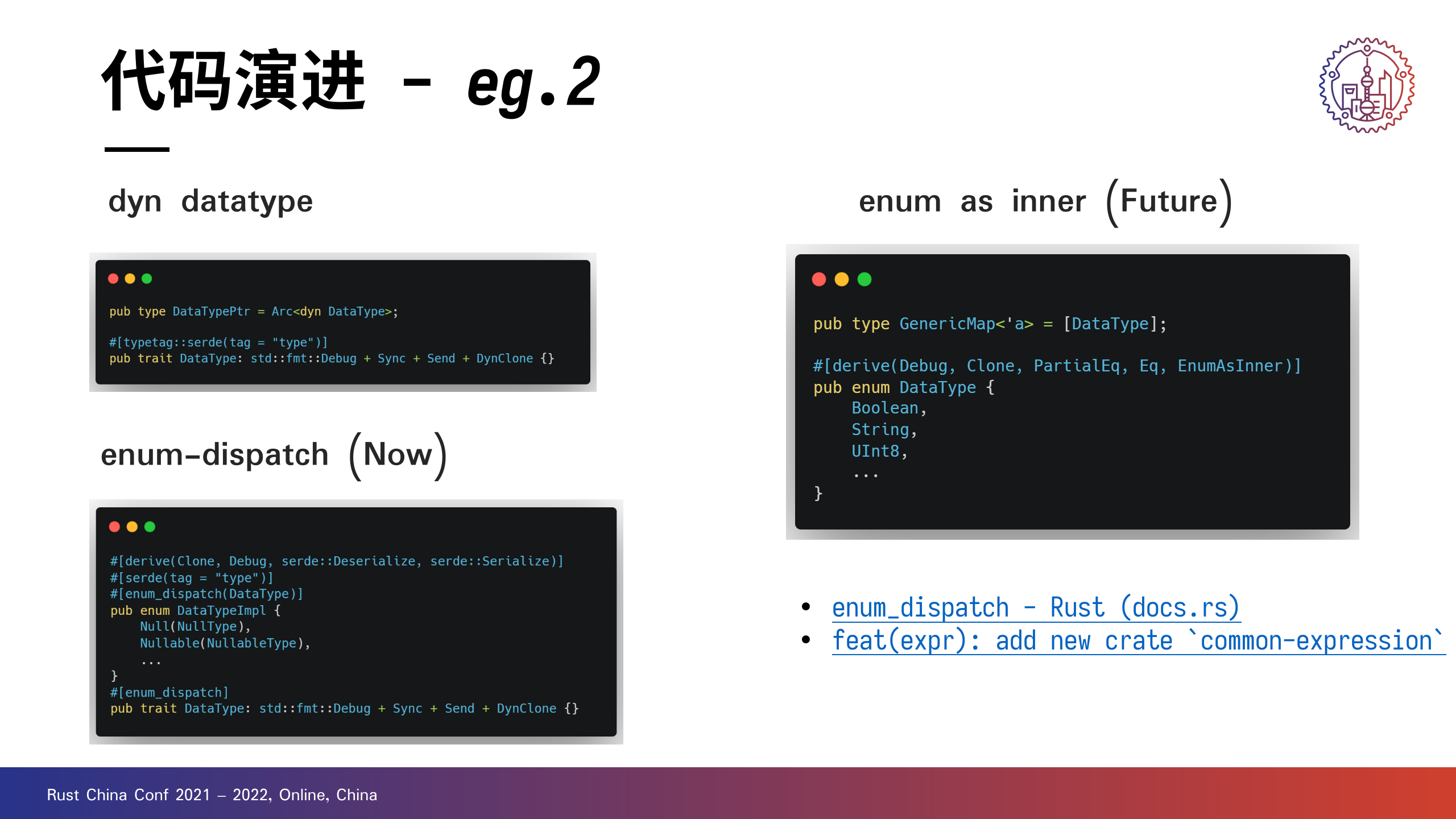

+

第二个例子是关于分发的,分发其实就是要确定调用接口时是调用哪个实例和它具体的类型。分发的方式不同,其成本也不同。

+左上角的例子是利用 trait object 动态分发,当然这会有一些开销。

+左下角使用 enum 进行静态分发,从语法上更便利。有数十倍的一个提升,但是 enum-dispatch 实现上比较硬核,基本上无法自动展开,需要自己手写规则。

+在新表达式框架中,使用 EnumAsInner 完成静态分发,代码更简洁,而且对 IDE 也更友好。

尽管 Rust 是一门健壮的语言,但程序的健壮性还需要开发者自己用心,这里分享两例完全可以避免的内存问题。

+eg.1

+

之前,上图中的代码片段没有加环境变量判断,导致程序会默认开启日志发送服务。

+但可能这个时候集群里没开对应的日志收集服务,没发的日志被 buffer 住,时间久了越攒越多,自然引发 OOM 。

+eg.2

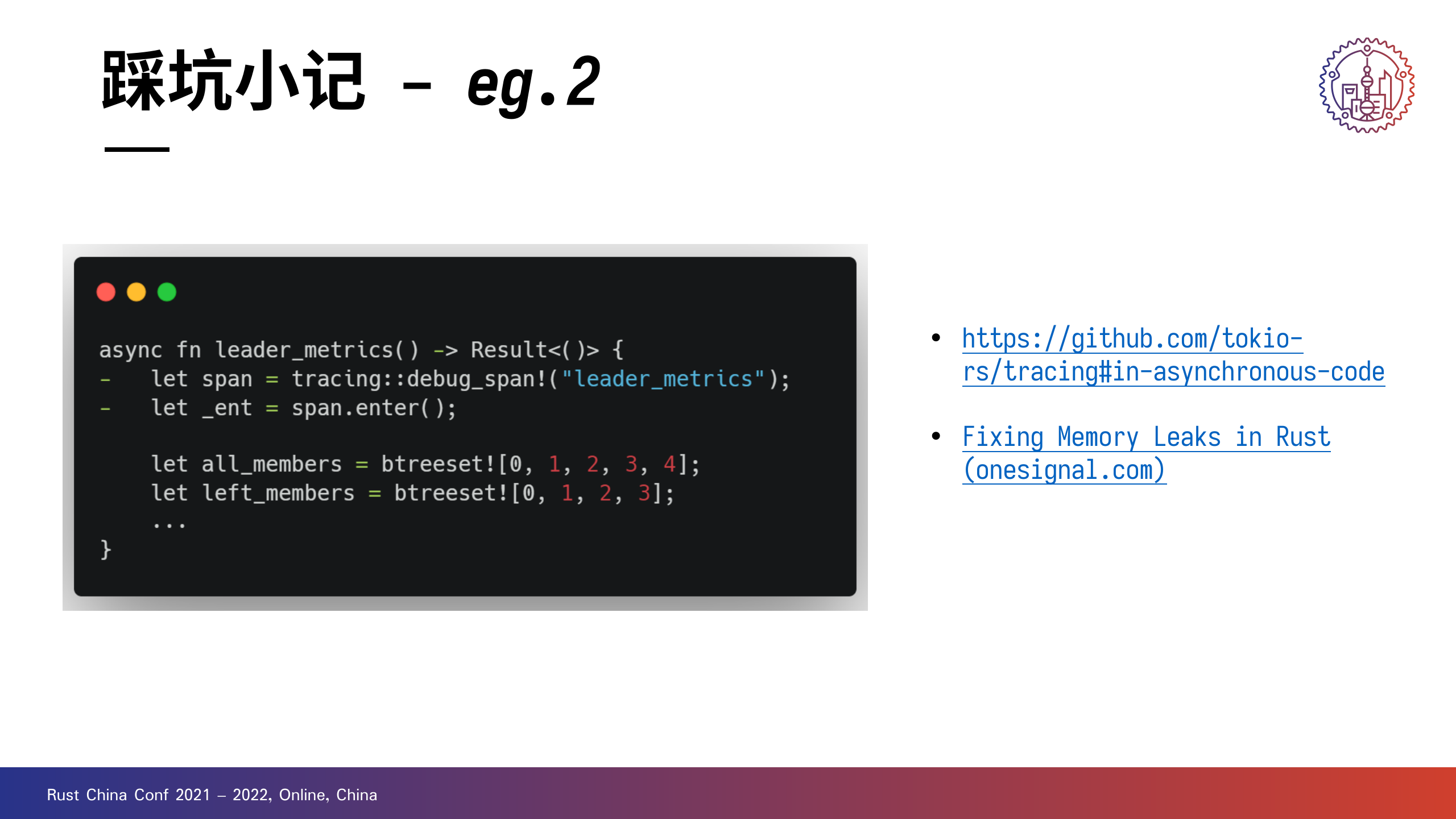

+

左图这个代码片段其实 tracing 的文档中已经给了提示。

+由于进入的 span 在异步执行结束后无法正确释放,会造成内存。onesignal 为此专门写了一篇文章,比较值得读。

+Databend 的成长离不开 Rust 社区和开源共同体,Databend 社区也在为共筑更好的 Rust 生态而努力。

+这里介绍三个 Databend 社区维护的开源项目。

+openraft

+https://github.com/datafuselabs/openraft

+openraft 是基于 tokio 运行时的异步共识算法实现,是披着 Raft 外壳的 Paxos,旨在成为构建下一代分布式系统的基石。

+目前已经应用在 SAP / Azure 的项目中。

+opendal

+https://github.com/datafuselabs/opendal

+opendal 的口号是:让所有人都可以无痛、高效地访问不同存储服务。

+近期的提案包括实现一个命令行工具,以操作不同服务中存储的数据,并支持数据迁移。

+opensrv

+https://github.com/datafuselabs/opensrv

+opensrv 为数据库项目提供高性能和高可度可靠的服务端协议兼容,建立在 tokio 运行时上的异步实现。目前在 CeresDB 中得到应用。

+

自 21 年 8 月起,Databend 和 Rust 中文社区、知数堂, +启动了面向 Rust 和数据库开发人员的公开课计划,前后一共输出 34 期课程。

+ +新一轮的公开课也在积极筹备,敬请期待。

+对待开源,Databend 一直秉承着上游优先的理念。也就是说开源协作理所当然地需要将变更反馈给社区。不光是做一个好的用户,也要做一个好的开发者。

+ +一个典型的例子是 arrow2 ,Databend 的核心依赖,我们应该是最早一批使用 arrow2 的项目。在 arrow2 的贡献者中有 9 位是 Databend Labs 成员,其中有三位是 top 15 贡献者。

+Databend 是一款云数仓,不仅仅是云原生数仓,更是云上数仓。

+

Databend Cloud 是 Databend 打造的一款易用、低成本、高性能的新一代大数据分析平台,让用户更加专注数据价值的挖掘。

+目前 Databend Cloud 正处于测试阶段,有需要的朋友可以访问 app.databend.com 注册帐号体验。

+ + + + + + + + +质量保障(Quality Assurance)用于确认产品和服务能够满足规定的质量需求。让我们一起来看一下 Databend 的质量保障实践。+

作为从 Day 1 就开源的现代云数仓,Databend 依托于 GitHub Actions 建立了一套相对完备的质量保障体系,以支撑快速迭代。

+Databend 的质量保障大概分为以下几个方面:

+流程篇

+基础篇

+测试篇

+好的流程有助于质量保障,从而持续推动 Databend 的进步。

+质量保障离不开对 Issue 的管理。Features / Bugs / Questions ,不同的分类决定了投递的形式和处理的方式。

+目前,Databend 格外关注 Bugs 类 Issue ,要求提供包括版本、报错、复现步骤并要求确认是否会提交相关的补丁。

+Databend 团队成员会检查 Issue 、沟通确认情况并进行评估。如确认存在需求,则会根据优先级和排期处理;而对于缺陷,则会及时修复并进行验证。

+周期性维护的目标是:在保证 Databend 稳定的前提下,有序推进工具链和依赖的更新。

+Databend 会在每月初进行一次集中维护:

+在无特殊需要的情况下,避免工具链和依赖版本的频繁变更,可以降低协作成本,帮助开发工作的稳定推进。

+当前 Databend 采用 nightly release 和 milestone release 结合的发布机制。每日都会发布的 nightly release 有助于日常情况的跟踪,而不定期的 milestone release 则方便进行阶段性的规划。

+Databend 的路线图由年度规划和版本计划组成,年度规划将会列出当年关注的一些主要目标,而版本计划则会根据当前的开发情况和 issue 组成进行调整。

+随着版本和路线图的不断演进,对 Databend 的质量也会有更高的要求,比如稳定性、跨版本兼容性等。

+除了测试之外,推进质量保障的一些常规手段。

+代码审计是保障 Databend 代码质量和稳定构建的第一道关口,在这一过程中,主要关注以下两个方面:

+代码审计不光是提高质量的一种手段,同时也能降低 reviewer 的负担。

+作为跨平台的 Cloud Warehouse ,确保在各个平台上的顺利编译也是质量保障的重要环节。

+Databend 的跨平台编译主要是针对 Linux(GNU) 和 MacOS 这两个平台,且完成对 x86 和 aarch64 两种体系结构的支持。额外地,在 release 阶段,也会构建针对 Linux(MUSL) 的静态编译版本。

对于日常提交,需要保证能够顺利在这些平台上完成构建。

+性能监控是质量保障中必不可少的一环,目前 Databend 主要关注:

+所有数据都会收集到 datafuselabs/databend-perf 这一 repo 中。访问 https://perf.databend.rs 即可查看可视化结果。

+测试是确保开发迭代和质量控制的重要内容。

+单元测试主要考虑基本组成单元(如:函数、过程)的正确性。

+Databend 目前共有接近 800 条单元测试,对重点函数做到了应测尽测。通过 Mock 部分全局状态,帮助开发者更加容易的编写测试用例。

+所有单元测试按 crate 进行组织,分布在对应的 tests/it 目录下,并按对应模块进行组织。这种编排方式可以减轻测试构建压力,在修改/添加新的测试时,无需重复编译对应的 lib 。

每个功能都是由若干函数/过程组成的,功能测试正是为评估功能的正确性而设立。功能测试会以 standalone 和 cluster 两种模式进行,以确保 Databend 的分布式执行功能,。

+当前 Databend 的功能测试主要由 sqllogictest 测试和 stateful 测试两个部分组成,这两类测试都可以在 tests 目录下找到。

sqllogictest 即 SQL 逻辑测试,是为了解决之前的 stateless 的一些旧有问题而专门设计实现的测试方案。RFC | New SQL Logic Test Framework 中介绍了其基本背景和方案概要。

Databend stateful 功能测试目前采用 Clickhouse 的方法,将测试所需执行的 SQL 集放入一个文件,预期结果集放入另一个文件。在测试时会调用 SQL 集生成对应的测试结果集,并与预期结果集进行对比。

上面简要介绍了 Databend 日常开发中涉及的质量保障内容,但质量保障体系仍然处于持续演进的过程中,这里列出了一些值得关注的内容:

+本文介绍了天空计算的概念和背景,以及 Databend 的跨云数据存储和访问。欢迎部署 Databend 或者访问 Databend Cloud ,即刻探索天空计算的无尽魅力。+

云计算时代的开端可以追溯到 2006 年,当时 AWS 开始提供 S3 和 EC2 服务。2013 年,云原生概念刚刚被提出,甚至还没有一个完整的愿景。时间来到 2015 年 CNCF 成立,接下来的五年中,这一概念变得越来越流行,并且成为技术人绕不开的话题。

+++根据 CNCF 对云原生的定义:云原生技术使组织能够在公共、私有和混合云这类现代、动态的环境中构建和运行可扩展的应用程序。典型示例包括:容器、服务网格、微服务、不变基础设施和声明式 API 。

+

然而,无论是公有云还是私有云、无论是云计算还是云服务,在天空中都已经存在太多不同类型的“云”。每个“云”都拥有自己独特的 API 和生态系统,并且彼此之间缺乏互操作性,能够兼容的地方也是寥寥无几。云已经成为事实上的孤岛。这个孤岛不仅仅是指公有云和私有云之间的隔阂,还包括了不同公有云之间、不同私有云之间、以及公有云和私有云之间的隔阂。这种孤岛现象不仅给用户带来了很多麻烦,也限制了云计算的发展。

+2021 年 RISELab 发表了题为 The Sky Above The Clouds 的论文,讨论关于天空计算的未来。天空计算将云原生的思想进一步扩展,从而囊括公有云、私有云和边缘设备。其目标是实现一种统一的 API 和生态体系,使得不同云之间可以无缝地协作和交互。这样一来,用户就可以在不同的云之间自由地迁移应用程序和数据,而不必担心兼容性和迁移成本的问题。同时,天空计算还可以提供更高效、更安全、更可靠的计算服务,从而满足用户对于云计算的不断增长的需求。总体上讲,天空计算致力于允许应用跨多个云厂商运行,实现多云之间的互操作性。

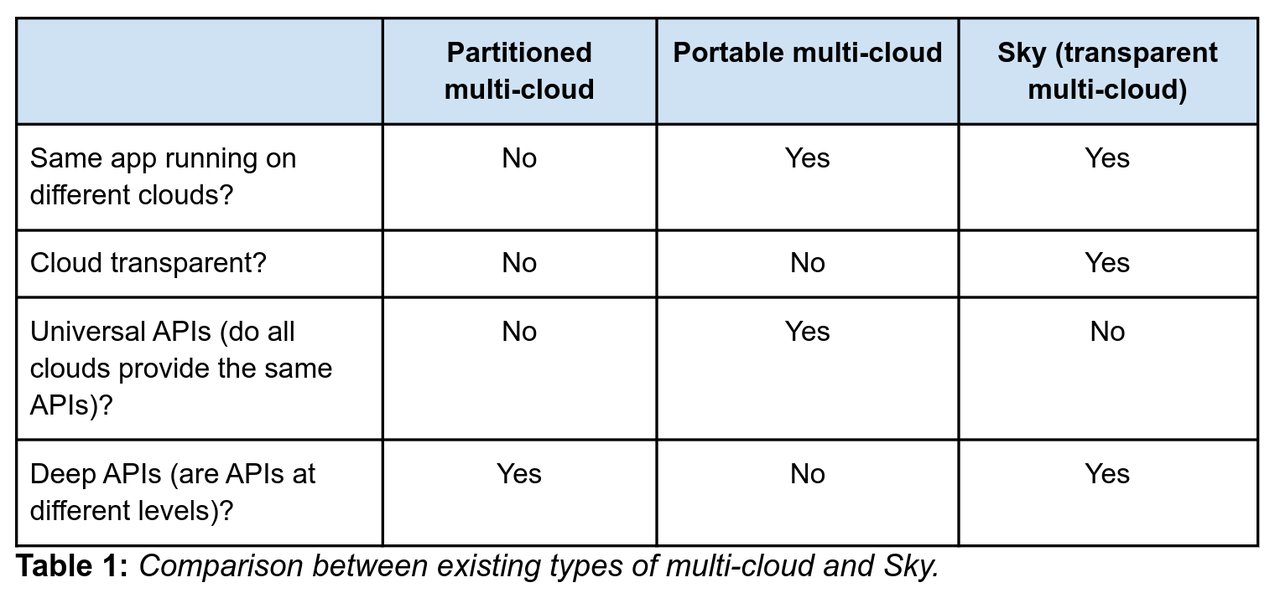

+

(上图引自论文,展示不同类型的多云与天空的区别)

+Databend 能够满足用户在不同的云之间自由地访问数据并进行查询,而不必担心兼容性和迁移成本的问题。同时,Databend 还可以提供更高效、更安全、更可靠的计算服务,从而满足用户对于云计算的不断增长的需求。从这个角度来看,Databend 已经初步形成了一套天空计算的解决方案。那么,对 Databend 而言,跨云的关键到底落在哪里呢?

+

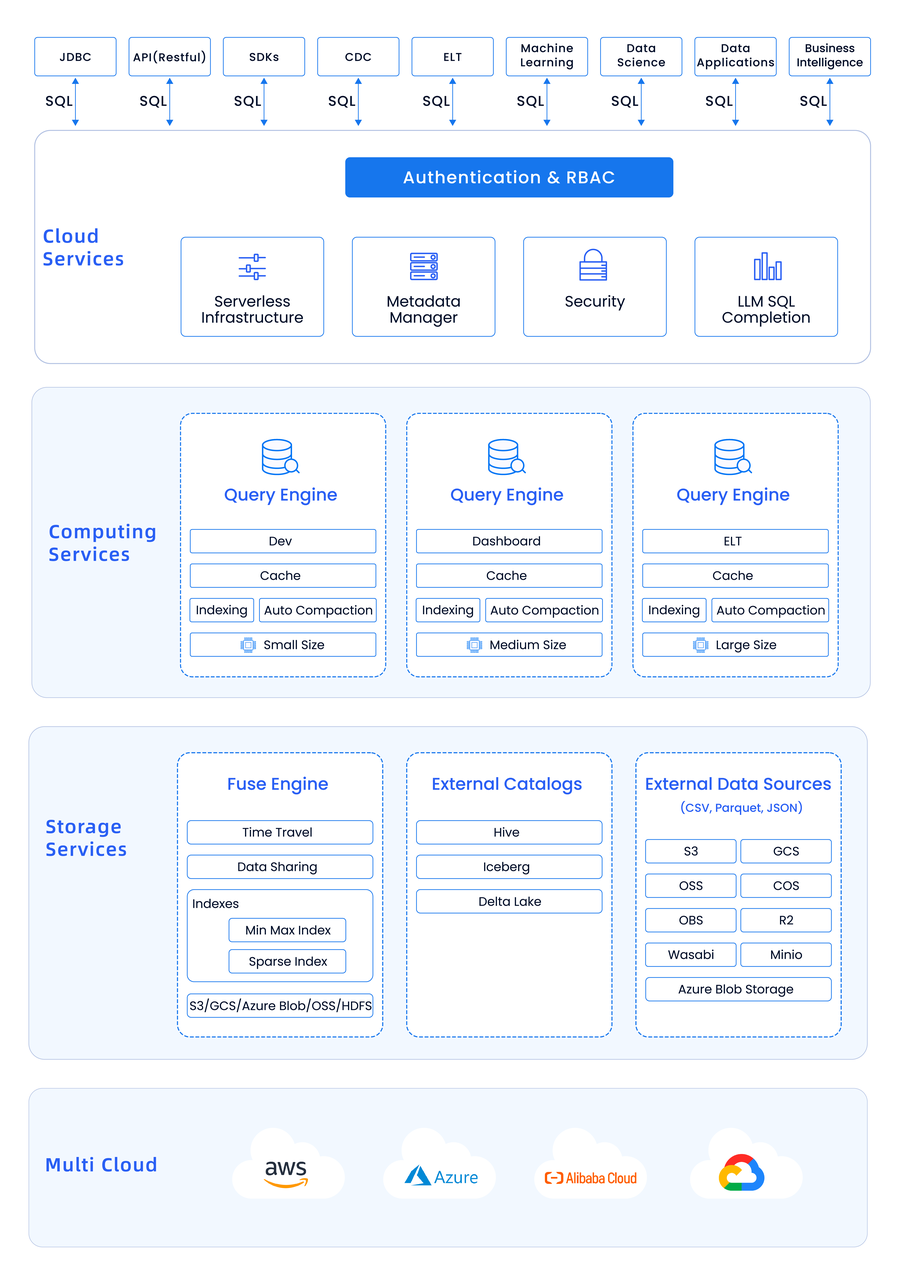

(上图所示为 Databend Cloud 架构示意图)

+Databend 采用存算分离的架构,并完全面向云对象存储进行设计决策。得益于存储与计算分离、存储与状态分离,Databend 可以实现对资源的精细化控制,轻松部署与扩展 Query 和 Meta 节点 ,并支持多种不同的计算场景和存储场景,而无需考虑跨云数据管理与移动的问题。

+Query 节点和 Meta 节点本身都是轻量化的服务,并且对于部署环境没有严格的依赖。但数据的存储和访问管理就不一样,我们需要考虑不同云服务之间的 API 兼容性、以及如何与云服务本身的安全机制交互从而提供更安全的访问控制机制。对于 Databend 而言,跨云,或者说实现天空计算的关键,就落在数据的管理与访问之上。

+

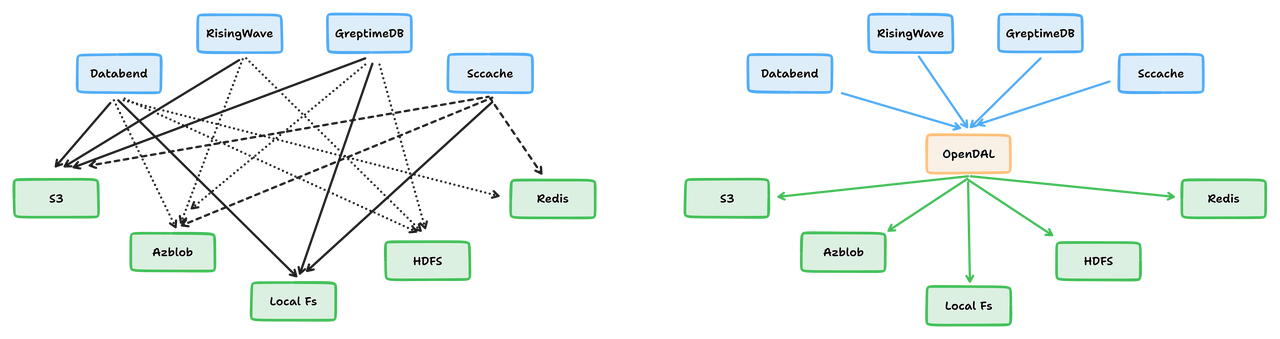

(OpenDAL 可以将数据访问问题从 M*N 转化为 M+N)

+为了解决这一问题,Databend 抽象出一套统一的数据访问层(OpenDAL,现在是 Apache 软件基金会旗下的孵化项目),从而屏蔽了不同云服务之间的 API 兼容性问题。在接下来的部分,我们将会从不同的视角来观察 Databend 的无痛数据访问体验,体验真正完全云原生的天空计算的魅力。

+Databend 存储后端的细节隐藏在简单的配置之下,通过修改配置文件就可以轻松地在十数种存储服务之间切换。例如,如果你想使用 AWS S3,只需要指定类型为 s3 即可,Databend 会自动尝试使用 IAM 来进行认证。如果你想使用其他与 S3 兼容的对象存储服务,也可以通过 endpoint_url 等设置来调整。

[storage]

+type = "s3"

+

+[storage.s3]

+bucket = "databend"

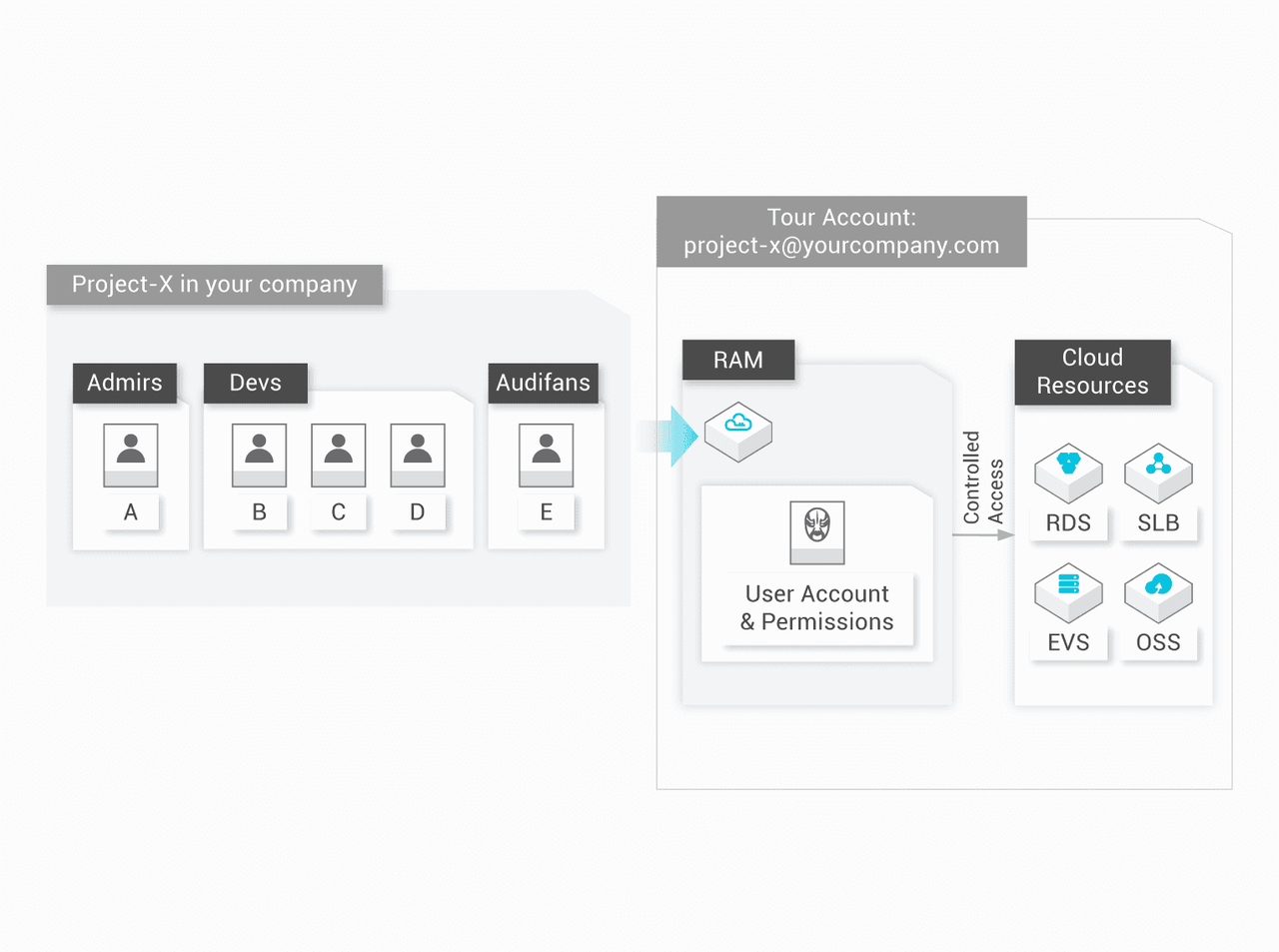

+当然,仅支持 S3 兼容的对象存储服务还不够。Databend 通过 OpenDAL 实现了 Google Cloud Storage、Azure Blob、Aliyun OSS、Huawei OBS 和 HDFS 等服务的原生存储后端支持。 +这意味着 Databend 可以充分利用各种供应商提供的 API,为用户带来更优秀的体验。例如,Aliyun OSS 的原生支持使得 Databend 可以通过 Aliyun RAM 对用户进行认证和授权,无需设置静态密钥,从而大大提高安全性并降低运维负担。

+

(上图选自阿里云官网,访问控制场景与能力)

+此外,原生支持还可以避免出现非预期行为,并与服务供应商提供更紧密的集成。虽然各大厂商都提供了 S3 兼容 API,但它们之间存在微妙差异,在出现非预期行为时可能会导致服务性能下降或读写数据功能异常。Google Cloud Storage 提供了 S3 兼容的 XML API,但却没有支持批量删除对象的功能。这导致用户在调用该接口时遇到意外错误。而 Google Cloud Storage 的原生支持使 Databend 不必担心 GCS 对 S3 的兼容实现问题对用户业务造成影响。

+总之,Databend 通过为各个服务实现原生支持来为用户提供高效可靠的数据分析服务。

+前面讲过了存储后端的跨云支持,现在让我们将目光聚焦到数据的管理。更具体来说,数据在 Databend 工作流中的流入与流出。

+要讲数据管理,就不得不讨论数据从哪里来。过去可能还需要考虑是否需要迁移存储服务,但现在,你可以从数十种 Databend 支持或兼容的存储服务中加载数据,一切都显得那么自然。

+COPY INTO 语句是窥探 Databend 跨云能力的一个窗口,下面的示例展示了如何从 Azure Blob 加载数据到 Databend 之中。

COPY INTO mytable

+ FROM 'azblob://mybucket/data.csv'

+ CONNECTION = (

+ ENDPOINT_URL = 'https://<account_name>.blob.core.windows.net'

+ ACCOUNT_NAME = '<account_name>'

+ ACCOUNT_KEY = '<account_key>'

+ )

+ FILE_FORMAT = (type = CSV);

+当然,不止是 Azure Blob ,Databend 支持的其他云对象存储服务、IPFS 以及可以经由 HTTPS 访问的文件都可以作为 External location ,通过 COPY INTO 语句加载进来。

++Databend 的

+COPY INTO语句还支持进行基本的转换服务,可以减轻 ETL 工作的负担。

刚刚提到 External location ,事实上,要加载到 Databend 中的数据文件还可以在 Stage 中暂存。Databend 同样支持 Internal stage 和 Named external stage 。

+数据文件可以经由 PUT_INTO_STAGE API 上传到 Internal Stage,由 Databend 交付当前配置的存储后端进行统一管理。而 Named external stage 则可以用于挂载其他 Databend 支持的多种存储服务之中的 bucket 。

下面的例子展示了如何在 Databend 中创建一个名为 whdfs 的 Stage ,通过 WebHDFS 协议将 HDFS 中 data-files 目录下的数据文件导入 Databend 。

+bendsql> CREATE STAGE IF NOT EXISTS whdfs URL='webhdfs://127.0.0.1:9870/data-files/' CONNECTION=(HTTPS='false');

+Query OK, 0 rows affected (0.01 sec)

+

+bendsql> COPY INTO books FROM @whdfs FILES=('books.csv') file_format=(type=CSV field_delimiter=',' record_delimiter='\n' skip_header=0);

+Query OK, 2 rows affected (1.83 sec)

+++如果你并不想直接导入数据,也可以尝试

+SELECT FROM STAGE,快速分析位于暂存区中的数据文件。

放在对象存储中的数据加载得到了解决,还有一个值得思考的问题是,如果数据原本由其他数据分析系统所管理,该怎么办?

+Databend 提供多源数据目录(Multiple Catalog)的支持,允许挂载 Hive 、Iceberg 等外部数据目录。

+下面的示例展示如何利用配置文件挂载 Hive 数据目录。

+[catalogs.hive]

+type = "hive"

+# hive metastore address, such as 127.0.0.1:9083

+address = "<hive-metastore-address>"

+除了挂载,查询也是小菜一碟 select * from hive.$db.$table limit 10; 。

当然,这一切也可以通过 CREATE CATALOG 语句轻松搞定,下面的例子展示了如何挂载 Iceberg 数据目录。

CREATE CATALOG iceberg_ctl

+ TYPE=ICEBERG

+ CONNECTION=(

+ URL="s3://my_bucket/path/to/db"

+ AWS_KEY_ID="<access-key>"

+ AWS_SECRET_KEY="<secret_key>"

+ SESSION_TOKEN="<session_token>"

+ );

+++Multiple Catalog 相关的能力还在积极开发迭代中,感兴趣的话可以保持关注。

+

数据导出是数据管理中的另外一个重要话题,简单来讲,就是转储查询结果以供进一步的分析和处理。

+这一能力同样由 COPY INTO 语法提供支持,当然,同样支持数十种存储服务和多种文件输出格式。下面的示例展示了如何将查询结果以 CSV 格式文件的形式导出到指定 Stage 中。

-- Unload the data from a query into a CSV file on the stage

+COPY INTO @s2 FROM (SELECT name, age, id FROM test_table LIMIT 100) FILE_FORMAT = (TYPE = CSV);

+这一语法同样支持导出到 External location ,真正做到数据的自由流动。

+++Databend 还支持

+PRESIGN,用来为 Stage 中的文件生成预签名的 URL ,用户可以通过 Web 浏览器或 API 请求自由访问该文件。

刚才提到的 Databend 数据管理环节跨云主要是指 Databend 与外部服务之间的交互。此外,Databend 实例之间也可以经由多种云存储服务来支持数据共享。